Есть множество способов выполнить резервное копирование отдельной информации или целых серверов. Я хочу рассказать о самом простом способе полного бэкапа сервера и переноса его на другое железо, если будет такая необходимость. Делается все это очень просто, без лишних телодвижений с помощью бесплатного Veeam Agent for Linux FREE.

На углубленном курсе "Архитектура современных компьютерных сетей" вы с нуля научитесь работать с Wireshark и «под микроскопом» изучите работу сетевых протоколов. На протяжении курса надо будет выполнить более пятидесяти лабораторных работ в Wireshark.

Реклама ИП Скоромнов Д.А. ИНН 331403723315

Введение

Ранее я уже неоднократно рассматривал вопрос резервного копирования данных или целых серверов linux. Конкретно в этих статьях:

- Бэкап сервера с помощью Duplicity.

- Создание резервной копии на Яндекс.Диске.

- Настройка Rsync для бэкапа данных.

Забэкапить сразу весь сервер можно, например, с помощью Duplicity. Но вот восстановить его на другом железе будет не так просто. Помимо данных нужно будет, как минимум, позаботиться о разметке диска, установке загрузчика. На это необходимо затратить некоторые усилия и немного разбираться в теме initramfs и grub. Сам я не очень разбираюсь в нюансах работы этих инструментов и очень не люблю с ними возиться.

Некоторое время назад появился отличный бесплатный продукт для бэкапа всего сервера целиком. Речь идет о Veeam Agent for Linux FREE. С его помощью можно сделать полный backup сервера, положить его куда-нибудь по smb или nfs, потом загрузиться с live cd и восстановить из бэкапа на другом железе.

Сразу расскажу о некоторых нюансах работы бесплатной версии, с которыми столкнулся в процессе эксплуатации замечательного продукта от veeam.

- Бэкап можно сделать либо всего сервера сразу, либо отдельного диска, либо отдельных папок и файлов. При выборе бэкапа всего диска или сервера, нельзя задать исключения для отдельных папок или файлов. Это очень неудобно, но увы и ах, таков функционал. Исключения можно сделать только если вы делаете бэкап на уровне папок.

- Бэкап можно положить локально на соседний раздел, если делаете резервную копию раздела, локально в папку - если делаете бэкап файлов и папок. Если бэкапите всю систему целиком, то удаленно по smb и nfs. К сожалению, по ftp или sftp программа не работает.

В качестве хранилища для архивов может выступать репозиторий Veeam Backup & Replication. Но я не рассматриваю этот вариант, так как в данном случае использую только бесплатное решение.

Мне очень хотелось настроить резервную копию всего сервера на Яндекс.Диск, но, к сожалению, у меня это не получилось из-за технических ограничений. Яндекс.Диск подключается к системе через webdav. Для того, чтобы сделать резервную копию всей системы, нужно бэкапить либо всю систему сразу, либо образ диска. Если у вас небольшой веб сервер, то скорее всего на нем только один раздел. На этом же разделе хранится кэш, который использует webdav для передачи файлов. Без кэша он работать не умеет.

Думаю вы уже поняли, в чем проблема сделать полный backup сервера с помощью Veeam Agent for Linux на Яндекс.Диск по webdav. Вы не сможете добавить в исключения папку с кэшом от webdav. В итоге, во время бэкапа с помощью veeam будет расти папка с кэшом webdav, которая, в свою очередь, будет бэкапиться. В итоге, свободное место на диске закончится, бэкап прервется.

Я подробно описал ситуацию с Яндекс.Диском, потому что пространство на нем не дорого стоит. Я часто его использую в повседневной жизни, настраиваю бэкапы, храню данные и т.д. В общем, мне он нравится по ряду причин. Для того, чтобы бэкапить весь сервер целиком, вам придется найти место для архивных копий с доступом по smb или nfs. Таких предложений не очень много на рынке. Практически не из чего выбирать, я специально искал.

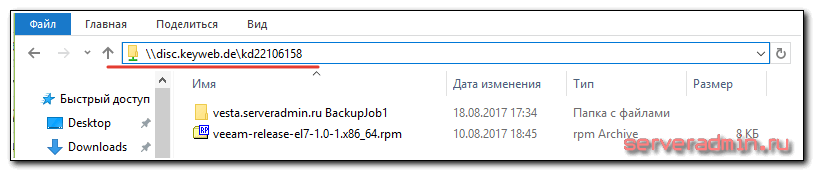

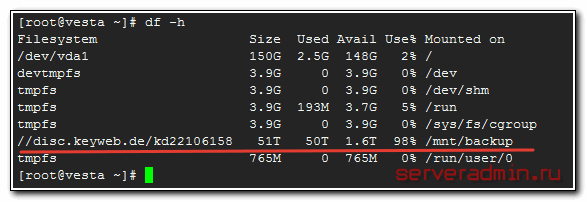

Остановился вот на этом варианте - KeyDisk. После оплаты, вам дают адрес сервера, логин и пароль. Вы можете сразу же подключаться по smb к хранилищу. Можно прям в windows через два обратных слеша зайти или подмонтировать хранилище к linux серверу.

Дальше я подробно на конкретном примере расскажу как все настроить и восстановить или перенести сервер целиком, если понадобится. Причем переносить буду вообще на другое железо. Но обо всем по порядку.

Установка Veeam Agent for Linux

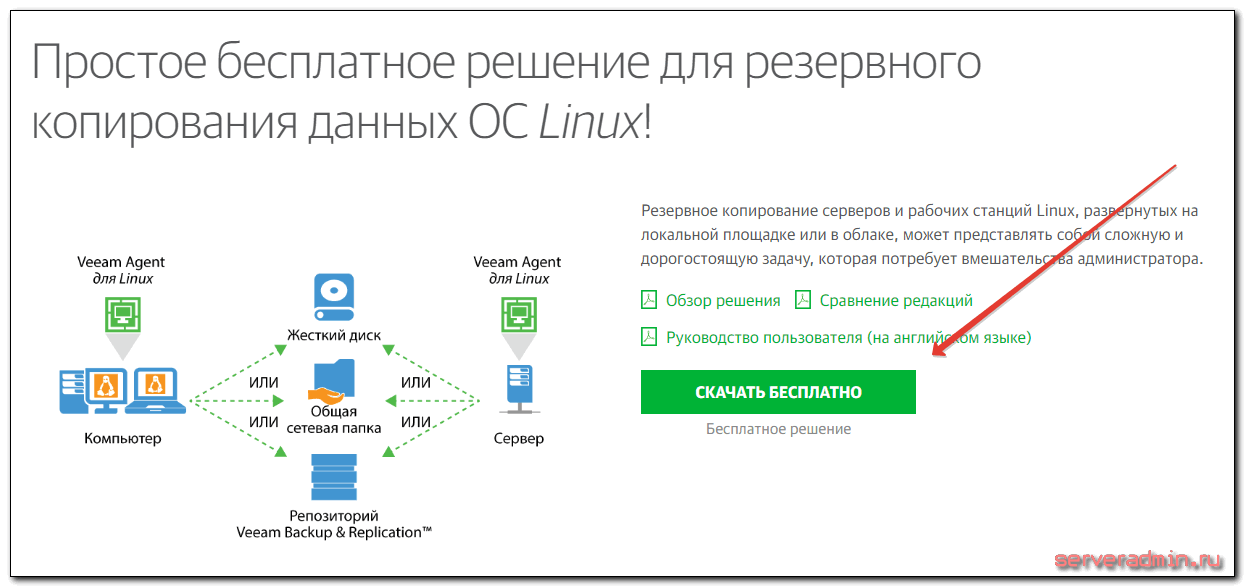

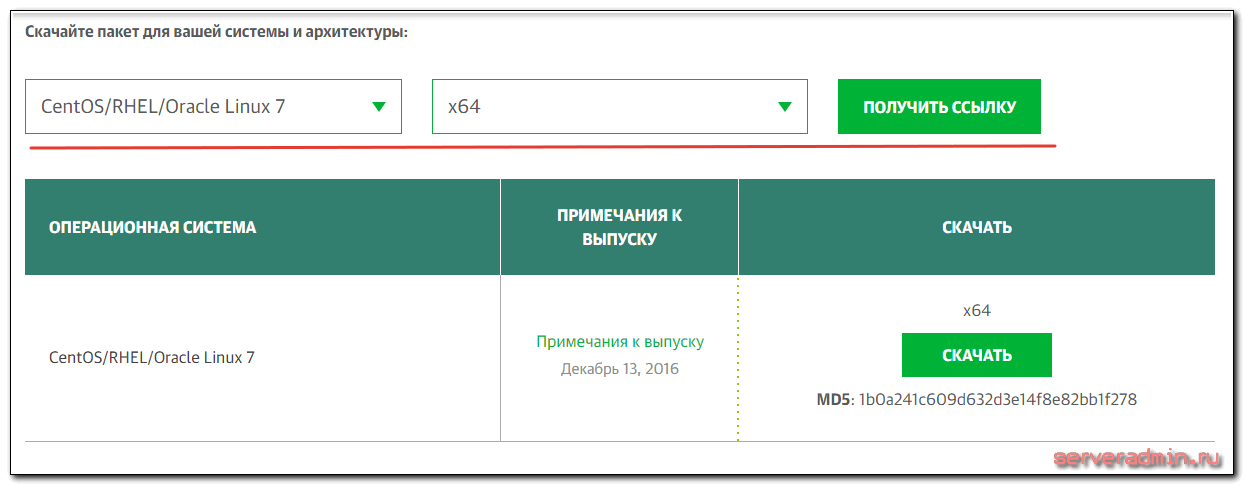

Для установки Veeam Agent for Linux необходимо подключить репозиторий veeam под нужную вам систему. Это можно сделать либо руками, либо скачать файл с репозиторием в виде rpm или deb пакета. Сделать это можно на странице с описанием продукта.

Для того, чтобы получить доступ к разделу с загрузками, придется зарегистрироваться. Выбираете тип системы и скачиваете репу.

Чуть ниже рекомендую сразу же скачать Veeam Linux Recovery Media. Он нам понадобится, когда мы будем переносить сервер на другое железо или восстанавливать из бэкапа.

Копируем файл с репозиторием на сервер и устанавливаем его. На момент написания статьи, файл можно было скачать по прямой ссылке.

# cd /root # wget https://download2.veeam.com/veeam-release-el7-1.0-1.x86_64.rpm # rpm -Uhv veeam-release-el7-1.0-1.x86_64.rpm

Обновляем репозитории и устанавливаем veeam.

# yum update # yum install veeam

Все, Veeam Agent for Linux установлен и готов к работе.

Настройка полного бэкапа сервера

Сделать бэкап с помощью Veeam Agent for Linux очень просто. Вариантов настроек не так много, можете сами все проверить и посмотреть. Я для примера рассмотрю вариант с созданием полного бэкапа всей системы и перенос ее на другое железо. Создаем задачу для резервного копирования сервера на наше хранилище по smb.

# veeam

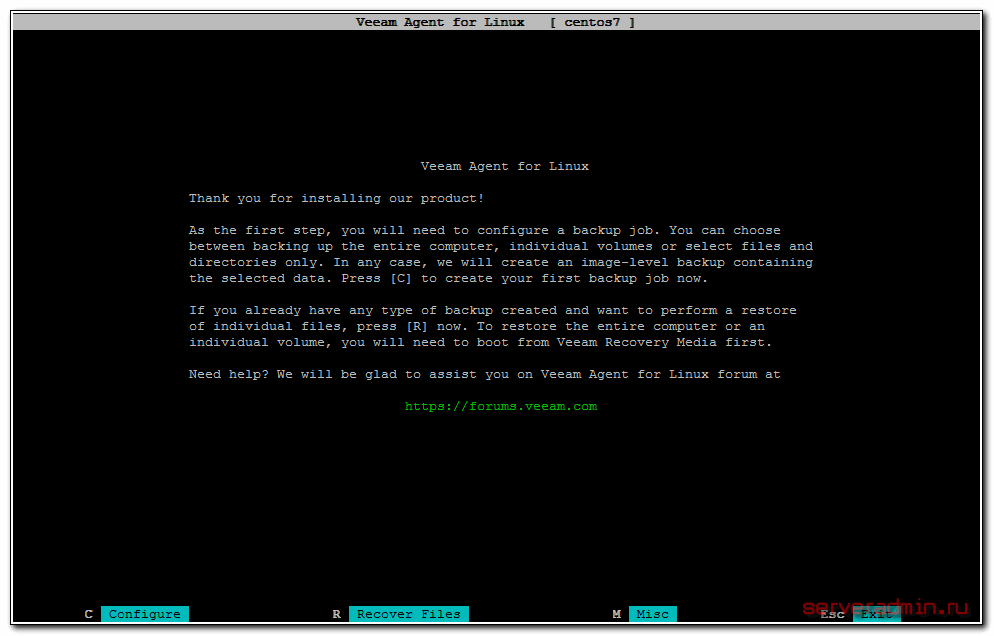

Нам сразу же предлагают указать файл с лицензией. Так как у нас лицензии нет, то отказываемся. Нас встречает главное окно программы.

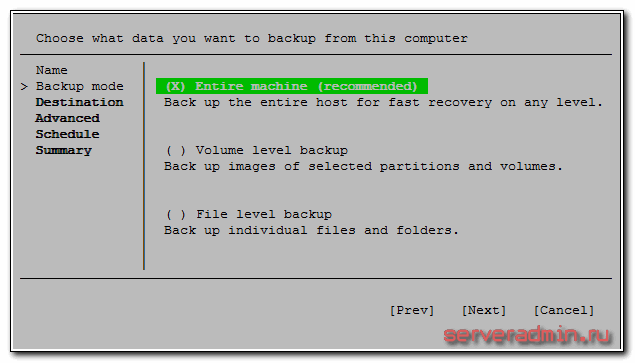

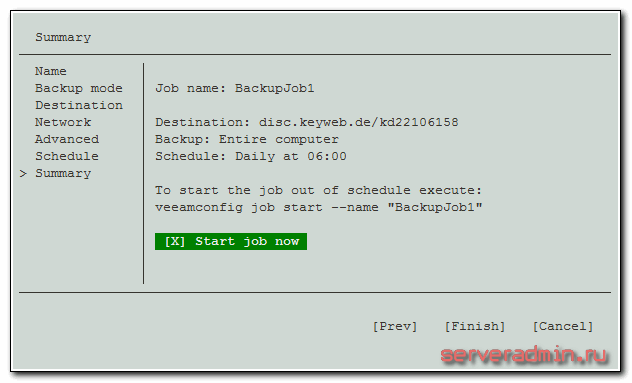

Нажимаем C (configure) для настройки задания на backup. Задаем любое имя задания, затем указываем, что будем делать полный бэкап сервера.

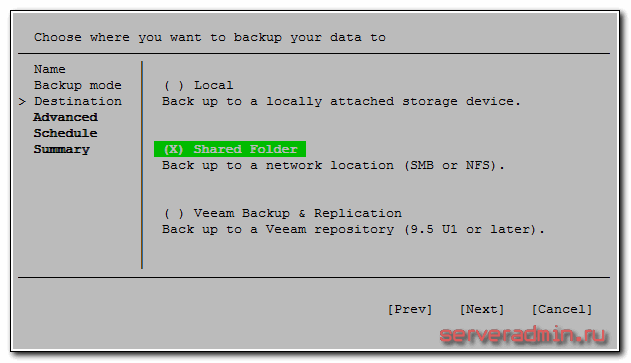

В качестве приемника для архива системы, указываем Shared Folder.

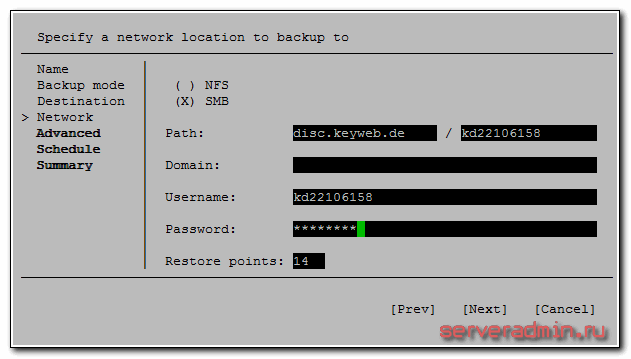

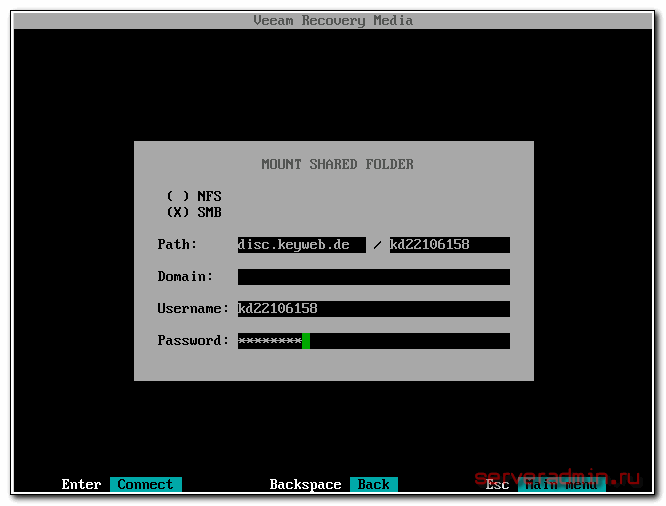

Далее нужно ввести параметры доступа к хранилищу бэкапов. Я использую свои от системы KeyDisk.

В пункте Restore Points указывается глубина архива. Это число копий, которые будут храниться на сервере. Если делать бэкап каждый день и указать число 14, то будут храниться резервные копии системы за последние 14 дней. Если делать будете через день, то за 28 дней и т.д.

Можно создавать несколько заданий с различной глубиной архива. Например, каждый день с глубиной 7 копий, раз в неделю с глубиной 4, и раз в месяц с глубиной в 12. Таким образом у вас всегда будут последние 7 бэкапов системы на этой неделе. Потом по одному бэкапу в неделю за последний месяц и 12 бэкапов по месяцам в течении последнего года.

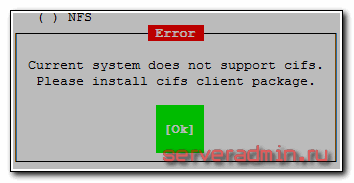

Если получите ошибку:

Current system does not support cifs. Please install cifs client package.

Установите пакет cifs. В CentOS вот так:

# yum install cifs-utils

И так в Debian/Ubuntu:

# apt install cifs-utils

Запускайте заново veeam и продолжайте. После настройки Destination, предлагается указать скрипты для выполнения перед и после бэкапа. Нам сейчас это не надо. Далее настраиваем расписание и запускаем задание на архивацию в конце настройки.

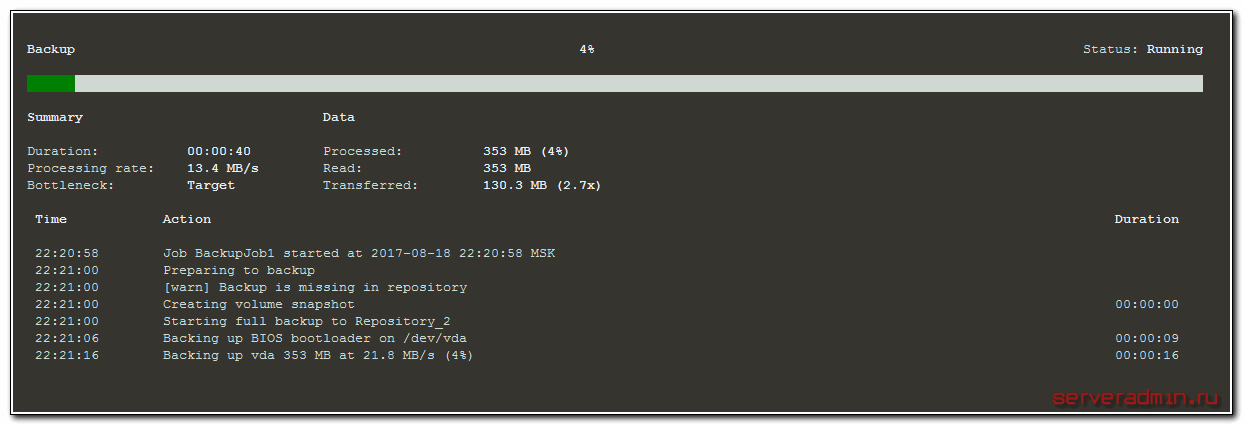

Запустилась архивация. Можно следить за ее прогрессом.

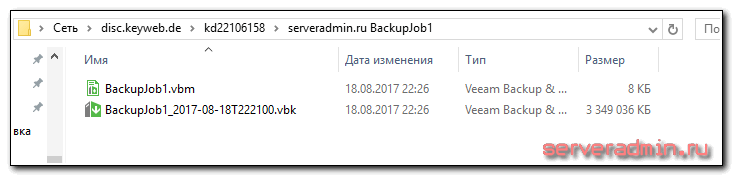

После завершения архивации системы, можно проверить содержимое сетевого хранилища, зайдя на него прямо из винды.

На этом настройку полного бэкапа сервера мы завершили. Резервная копия системы лежит в надежном месте. Попробуем теперь с нее восстановиться.

Перенос или восстановление linux сервера

Представим теперь ситуацию, что наш веб, или какой-нибудь другой сервер умер, и нам надо восстановить систему в другом месте. Выполним полное восстановление всего сервера с помощью созданной ранее резервной копии. Для этого нам понадобится Veeam Linux Recovery Media, который мы скачали ранее.

Для восстановления системы нужно соблюсти два обязательных условия:

- Готовим новый сервер с диском, который должен быть не меньше диска исходного сервера. Это обязательное условие, иначе восстановление системы даже не начнется. Veeam скажет, что размер диска недостаточный и не предложит больше никаких вариантов восстановления.

- Оперативной памяти для системы должно быть не меньше 1024 Мб. Если меньше, то загрузка с диска не будет выполнена. Система скажет, что она не может развернуть корневой раздел.

Загружаемся с диска. В разделе Configure network убеждаемся, что сеть настроена, получен ip адрес, который имеет доступ к интернету. Далее выбираем Restore volumes -> Add shared folder. Заполняем параметры доступа к хранилищу архивов.

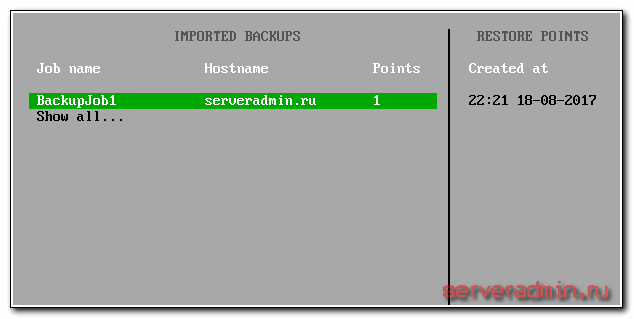

Выбираем там директорию с нашим архивом системы, которую будем восстанавливать. Далее будет показан список задач в левом столбце и список резервных копий в правом.

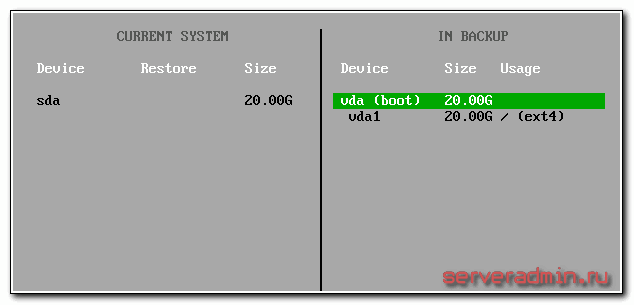

В моем случае там только одна копия. Выбираю ее. Дальше мы видим слева список дисков нашего сервера, справа диски резервной копии.

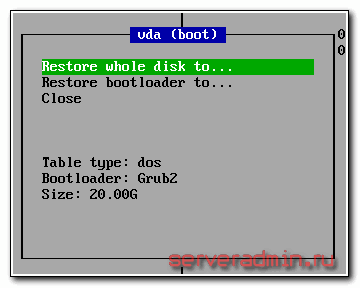

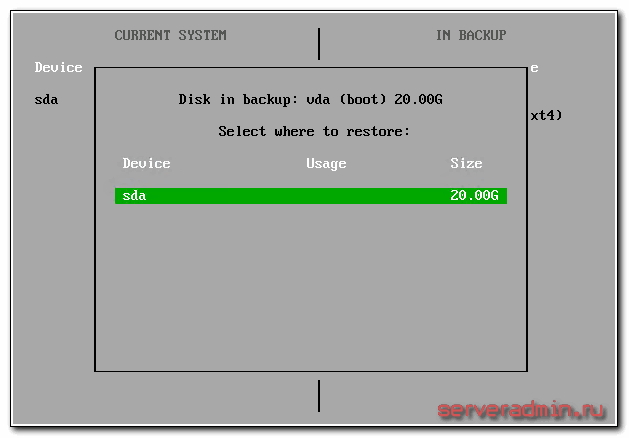

У меня слева чистый диск, справа тоже один диск, на который установлен загрузчик и есть один раздел с корнем системы. Выбираем справа наш диск (не раздел с корнем!!!) и жмем Restore whole disk to.

В качестве приемника выбираем пустой диск на новом сервере.

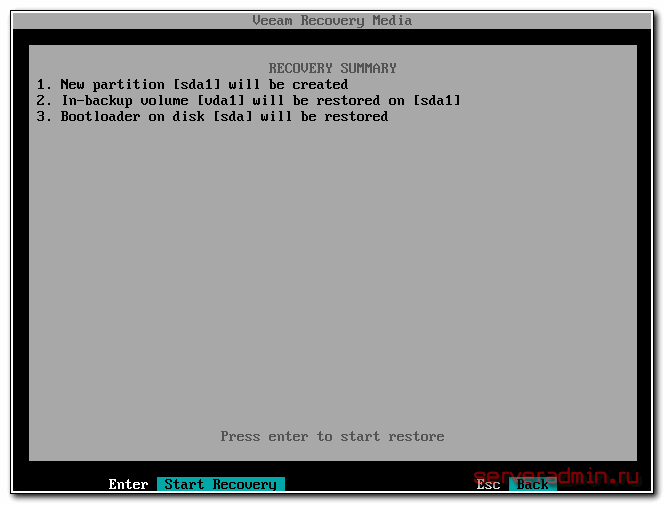

Нажимаем S ( Start restore ). Визард покажет список действий, которые будут выполнены и попросит их подтвердить, нажатием на Enter.

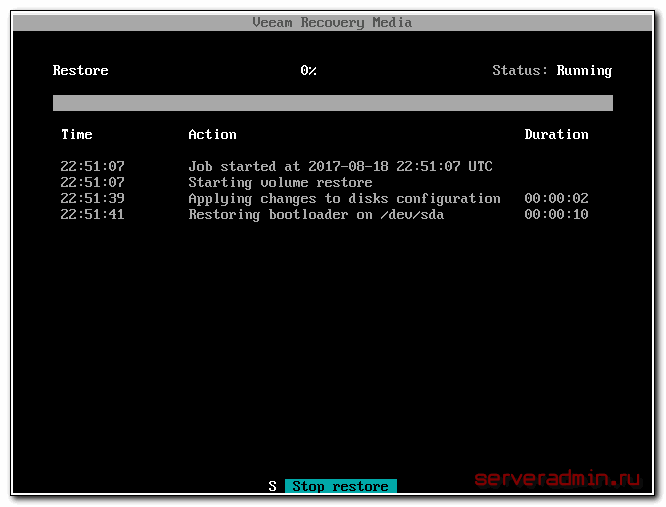

Делаем это и наблюдаем за процессом восстановления сервера centos из бэкапа.

Дожидаемся окончания переноса сервера, выбираем перезагрузку и извлекаем загрузочный CD. Грузимся с жесткого диска.

Дальше может быть много различных вариантов. Если вы переносите сервер на тот же гипервизор, то проблем скорее всего не будет, и все заведется сразу. Если же гипервизор другой, то могут быть варианты, в зависимости от ситуации.

Перенос виртуальной машины с KVM на Hyper-V

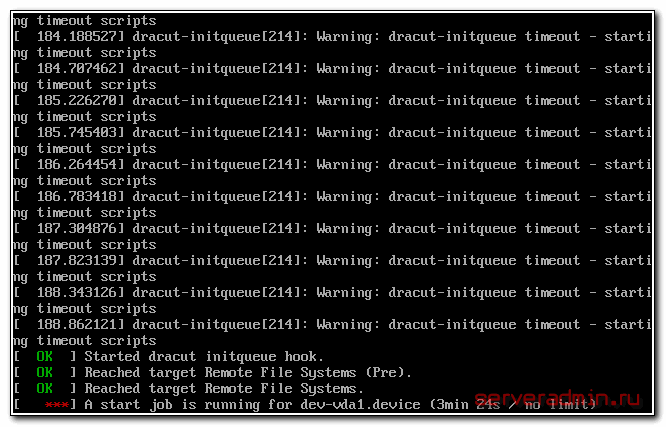

В моем случае я переношу сервер с KVM на Hyper-V. После загрузки системы я получаю такую картину.

Сервер начинает бесконечно висеть в подобном состоянии с такими характерными ошибками:

Warning: dracut-initqueue timeout starting timeout scripts

a start job is running for dev-disk-by ......

Начинаю разбираться в чем может быть дело. Конечно, тут решение проблемы будет зависеть от конкретной ситуации. А успешность решения от квалификации сисадмина. Я уже немного повозился с подобными переносами и примерно представляю, в чем тут может быть проблема. Частично я эту тему затрагивал, когда делал перенос виртуальных машин с XenServer на Hyper-V. Но там была другая проблема, связанная с кастомным ядром от Xen.

В нашей ситуации с переносом виртуальной машины с KVM на Hyper-V проблема в другом. У нас поменялось имя диска. Нам нужно изменить это имя в fstab и в конфиге grub. До кучи я еще собрал заново initramfs, но не уверен на 100%, что в данном случае это нужно было делать. Я сделал на всякий случай сразу все за один заход.

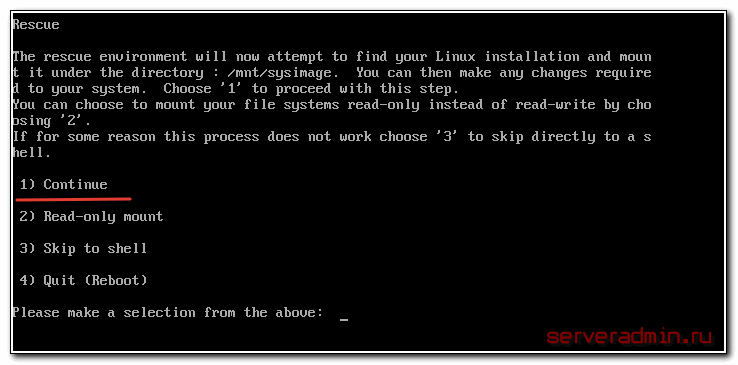

Итак, загружаемся с установочного диска CentOS 7 и выбираем режим Rescue a CentOS system. Подробно об этом рассказывал в упомянутой ранее статье с переносом от xen. Выбираем первый режим запуска.

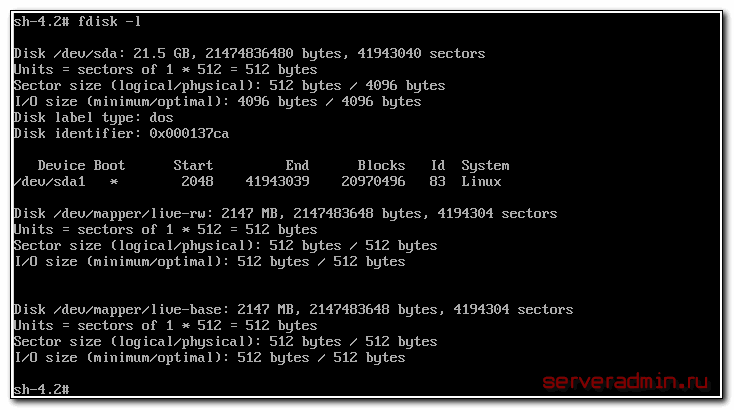

Дальше работаем в консоли. Смотрим, как называется наш диск.

# fdisk -l

У меня это sda, а на прошлом сервере он назывался vda. Нам нужно внести эти изменения в 2 файла:

- /etc/fstab

- /boot/grub2/grub.cfg

Диск восстановления в самом начале мог сам смонтировать системный раздел в директорию/mnt/sysimage. Если он этого не сделает по какой-то причине, то сделайте это сами:

# mount /dev/sda1 /mnt/sysimage

Теперь нам надо сделать chroot в систему, предварительно смонтировав туда информацию о текущей системе. Выполняем команды:

# mount --bind /proc /mnt/sysimage/proc # mount --bind /dev /mnt/sysimage/dev # mount --bind /sys /mnt/sysimage/sys # mount --bind /run /mnt/sysimage/run # chroot /mnt/sysimage

Мы загрузились в окружение нашего сервера. Тут можете использовать установленный у вас на сервере текстовый редактор. С его помощью изменяете имена дисков в файлах /etc/fstab и /boot/grub2/grub.cfg. Можете просто автозаменой поменять имена.

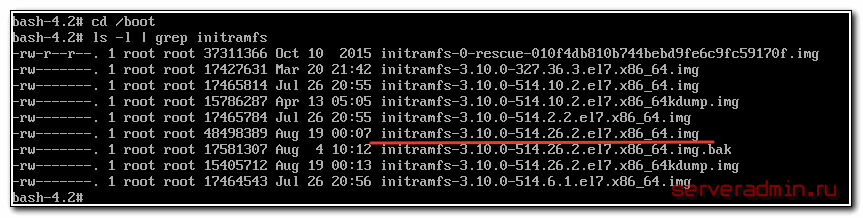

Теперь соберем новый initramfs. Идем в директорию /boot и смотрим там последнюю версию ядра.

# cd /boot # ls -l | grep initramfs

В данном случае просто смотрим самые высокие цифры. Соберем новый initramfs в соответствии с версией ядра.

# dracut initramfs-3.10.0-514.26.2.el7.x86_64.img 3.10.0-514.26.2.el7.x86_64

В завершении установим измененный загрузчик на наш диск:

# grub2-install /dev/sda

Перезагружаем сервер. После этих изменений, у меня благополучно все загрузилось. Перенос виртуальной машины с KVM на Hyper-V выполнен полностью. Причем, у нас не было доступа к образу системы. Хотя подобная ошибка скорее всего все равно возникла бы, даже если бы мы конвертировали и переносили готовый образ.

Заключение

Изначально планировал написать небольшую заметку на тему использования Veeam для бэкапа сервера. Но в процессе получилось разобрать еще и перенос сервера с одного гипервизора на другой. Еще раз повторюсь, кому показалось это слишком сложным. Если вы будете бэкапить и восстанавливать сервер в рамках одного и того же гипервизора, то описанных выше проблем у вас не будет. Все пройдет гладко.

При переносе с железа на виртуальную машину или наоборот, тоже скорее всего возникнут какие-нибудь проблемы. Не существует софта или готового решения, которое бы позволило все это выполнить в автоматическом режиме. С проблемами загрузки придется разбираться по ходу дела. Но две основные проблемы я разобрал:

- Неподходящие версии ядер. После переноса нужно будет переустановить или обновить ядро.

- Разные имена дисков или меток разделов. Нужно будет их привести в соответствие с новым железом.

Это наиболее популярные проблемы. С другими мне не приходилось сталкиваться. Хотя не сказать, что мне часто приходилось переносить сервера, но некоторый опыт есть. Думаю, эта статья будем многим полезна, так как подобный перенос не очень раскрыт в статьях в интернете. По крайней мере мне не попадались хорошие гайды на эту тему. Разбираюсь обычно сам с помощью гугления по англоязычному сегменту.

Делитесь своим опытом и оставляйте замечания к статье или указывайте на ошибке в комментариях.

На углубленном курсе "Архитектура современных компьютерных сетей" вы с нуля научитесь работать с Wireshark и «под микроскопом» изучите работу сетевых протоколов. На протяжении курса надо будет выполнить более пятидесяти лабораторных работ в Wireshark.

Реклама ИП Скоромнов Д.А. ИНН 331403723315

Server Admin Авторский блог системного администратора

Server Admin Авторский блог системного администратора

Спасибо за статью. Не подскажете, при полном бэкапе CIFS/SMB примонтированные к целевому серверу включены в файл бэкапа?

Нет, сетевые диски не бэкапятся.

Спасибо за статью! К моему переносу альта тут мало что пригодно, но основные моменты и направление мысли для переноса системы вы указали, до остального сам дошел!)

19:51:34 Job job1 started at 2023-11-27 19:51:34 UTC

19:51:44 [error] Failed to perform backup

19:51:44 [error] Backup to Veeam Cloud Connect functionality requires a valid license

19:51:44 [error] Processing finished with errors at 2023-11-27 19:51:44 UTC

Где взять лицензию бесплатно ? для бэкапа в облако

Не понял, в какое облако?

разобрался, можно триал взять на сайте veeam. Агенты inux для облака платные у них

Добрый день! Возникла проблема. Переношу ВМ на Linux с одного хоста Hyper-V на другой хост Hyper-V. Бэкап разворачивается на новом месте без проблем, но при старте ВМ ничего не происходит. Гипервизор не запускает загрузчик Grub. Если зайти чрутом в восстановленую систему, то можно понять что бэкап реально восстановил все что было. Пробовали переустанавливать grub, обновлять его, переносить с оригинальной копии - результата ноль. Гипервизор выдает ошибку что не нашел файлов загрузки и не запускает ничего.. Кто-нибудь сталкивался?

Попробуйте зайти чрутом в восстановленную систему и переустановить grub через команды: update-grub, grub-install, dpkg-reconfigure grub-pc или что-то в этом роде. Сейчас уже не помню точно, в каком дистрибутиве какая команда чинит grub.

Судя по тому, что ничего не происходит при запуске VM, установщика нет вообще.

Не поверите, если в Hyper-V 2019 сделать новую ВМ 1-го поколения то все работает сразу, без ошибок!

второе поколение виртуалок гиперв могут загрузку только ефи

а первое только мбр

т.е. или надо диск конвертировать в гпт и так далее и так далее. или сделать поколение как было на исходном

К виртуалке проще подцепить еще один диск и забекапить на него нужные разделы, а потом забрать по ssh, чем бекапить через интернет на smb.

При восстановлении бекапа долго бился головой из-за того, что не мог подобрать структуру разделов правильно.

Для восстановления GRUB нужно иметь пустую область на диска ДО первого раздела.

По итогу - после переустановки GRUB все взлетело даже без пересборке initramfs... :)

Спасибо за Ваши статьи!

Конечно, если есть возможность подцепить диск, лучше через него бэкапить. Тащить полные бэкапы VM через интернет очень нестабильно. Любой обрыв связи и начинай всё с начала.

Доброго дня!

Устанавливал Veem Agent на Debian, в процессе установки, при сборке iso Veeam Linux Recovery Media, получил вот такую ошибку: https://i.postimg.cc/Njw4XMWN/2022-01-08-06-23-06.png

Решал следующим образом:

1. vi /lib/systemd/system/veeamservice.service

2. В секции [Service] добавляем 2 строки:

LimitNOFILE=524288

LimitNOFILESoft=524288

3. Выполняем systemctl daemon-reload

Может кому пригодится и самому чтоб не забыть )))

Спасибо за информацию. В стандартные системные лимиты Linux упёрлись. Странно, что так вышло. Интересно, что там такое происходило в системе при создании Recovery Media. Если что, то эти лимиты вот тут живут - /etc/security/limits.conf Можно для всей системы поменять разом, либо для отдельных процессов через systemd.

А происходит там буквально следующее: unsquashfs при распаковке iso образа с большим количеством файлов и упирается в лимиты...

Добрый день.

Прошу совета. Имеется сервер Bitrix virtual appliance version 7.5.0 развёрнутый на VPS.

Появилась необходимость перенести его на свой ESXi-хост.

Как лучше это сделать и какими инструментами?

Спасибо.

Из автоматических только описанный в статье Veeam. Но может быть что-то сам хостер сможет предложить. Может есть какие-то платные варианты создания и конвертации бэкапов виртуальной машины целиком.

Утилита отличная. Но умела бы она восстанавливать данные из резервной копии на диск меньшего объема тогда бы цены не было.

А то у меня на самом CentOS 7 диск 500ГБ.

А на компьютере под тестовую виртуальную машину свободно 300ГБ

При всем этом на CentOS 7 физически данных хранится не на 500ГБ а гораздо меньше.

Она точно не умеет на диск меньшего объёма разворачивать? Я не проверял никогда. Жаль, если так. Тот же Acronis умеет разметку диска менять, если на меньший раздел восстанавливаешь.

Переносил CentOS-8 с VirtualBOX на VMWare ESXi, была та же ошибка (Warning: dracut-initqueue timeout starting timeout scripts) но ваше решение не помогало, причем не понятно почему - вроде все команды выполняю, ошибок нет - после ребута та же история.

Нашел другое решение:

При загрузке ОС выбираем самый нижний пункт "CentOS Linux (.rescue.....)"

Авторизуемся и вводим всего одну команду:

dracut --regenerate-all --force

Ребутаемся

Возможно она влияет на другие параметры, не силён в деталях - я так перенес несколько машин. Вдруг кому то поможет

Спасибо, полезная информация. Не знал, про эту команду и такую возможность. По идее, она делает то же самое автоматически, что я вручную делал в статье.

У вас удачно получился этот метод с командой ?

При тестировании развернутой резервной копии все работало ?

>Похожих предложений с доступом по smb я лично вообще не нашел в принципе

Storage Boxes hetzner

3.45 € 100GB

5.83 € 500 GB

9.40 € 1 TB

Чем больше объём тем дешевле в итоге за 1Гб

FTP

FTPS

SFTP

SCP

Samba/CIFS

BorgBackup

rsync via SSH

HTTPS

WebDAV

Спасибо за статью Zerox. Интересует Ваше мнение. Как бы Вы реализовали полную систему резервного копирования? Имеется 10 серверов VPS. На каждом размещены LEMP и MEAN с некоммерческими сайтами, а также некоторые другие сервисы. Интересует в первую очередь лёгкость (по ресурсам) решения и возможность делать помимо стандартных полные копии сервера.

Я бы настроил полные бэкапы с помощью veeam linux agent и ОБЯЗАТЕЛЬНО бы добавил бэкапы самих сайтов в виде файлов и дампов баз данных.

Коллега, спасибо за ответ и сайт. Один из немногих ресурсов рунета с обоснованием информации и внятными комментариями. Устал от "ужатых" статей "скопировал-вставил" для безмозглых и воплей мамкиных копирастеров "много воды много воды". Желаем процветания и 24/7 Вам на ресурсах!

Хорошо бы, если в этой статье не смешивались бы в одну кучу кучу кони, люди, и залпы тысячи орудий.

Т.е - Яндекс-диск, виртуалки и гипервизоры. Можно было по-простому - только бекап дедика и все?

А остальное отдельно.

А то до сих пор непонятно, что тут вообще делается - бекап на лету или что?

Если что-то не понятно, всегда можно прочитать ещë раз.

Ответ такой же бесполезный, как и статья

Спасибо, что поделился своим мнением. Интернет большой, наверняка удастся найти что-то более полезное. А может даже у тебя есть статьи еще лучше. Поделись ссылкой, я почитаю, поучусь, как надо писать, чтобы было понятно с первого раза всем.

Zerox, ну зачем же вы так? Ваш сайт и ваши статьи очень полезны, и я очень часто пользуюсь ими.

Но данная статья запутанная, потому что вы смешали сразу несколько задач, и понять в них главное затруднительно, на что вам и намекнул строками из стихотворения.

Но в ответ вы съязвили, и я тоже не сдержался.

Такой путь ведет в никуда, к сожалению.

Запутанная это субъективная характеристика. Об этом, к слову, ранее никто не писал, хотя комментариев очень много. Я посчитал, что в таком изложении она будет более полезной и целостной и даст максимальную пользу, так как объединяет в себе так и ли иначе темы бэкапа. Наиболее популярные статьи на сайте именно большие, масштабные с захватом смежных тематик. Прыгать по ссылкам в статьях менее удобно, чем получить все по теме в одном месте.

Ну ладно. Хотя меня еще смутило, что бекап сервера размещается на Яндекс-диске.

Не знаю, как в нем решен вопрос с НСД к заливаемым вашими данными, может и на должном уровне, тем не менее, в любом случае я бы постерегся размещать серверные данные (а там адреса, пароли, явки) размещать чужом ресурсе.

Так это уже по месту надо решать, что куда и как заливать. Как минимум, архивы можно шифровать и хранить где угодно. Это поддерживают почти все системы бэкапа.

Владимир не использовали в своей практике http://www.urbackup.org/ ? пару раз работал с этой системой бекапа но как бы в основном поиграться , интересует насколько сие готово для прода , учитывая что решение бесплатное

Я не то, что не пробовал, даже не слышал никогда о нем.

я пробовал urbackup ,но он не умеет с линукса снимать образ на живую

Вот такая ошибка встречается при попытке сделаю копию согласно статье.

Может быть сталкивались вы или читатели.

При этом свободного места на диске в самой ВМ и на datastore ESXI достаточно.

[error] Failed to create volume snap... 00:00:00 │

09:51:34 [error] Failed to take volume snapshot │

09:51:34 [error] Failed to perform backup │

09:51:34 [error] Child execution has failed. ... ▒

09:51:34 [error] Failed to load module [veeam... │

09:51:34 [error] Processing finished with err...

P.S.

Бэкап делаю в сетевую шару через Veeam backup and replication 9.5 проблем вообще ни каких. Я хотел попробовать метод через агента так как в упор не вижу где создается загрузочный ISO диск для переноса копии созданной через Veeam backup and replication 9.5 на другое железо.

Там в логах должны быть более информативные ошибки. Я что-то подобное видел. В ядре нет поддержки чего-то нужного для veeam. Вы какую систему бэкапите?

Интересная статья. Данный метод поможет перенести например с ESXI 6 - VM CentOS 7 с asterisk и восстановить на обычном голом железе не сервере и не в другом ESXI а именно на стороннее железо на компьютер уровня десктоп ?

Теоретически да. А практически надо проверять. Далеко не факт, что все получится легко и просто. Но в целом, перенос линукс сервера это дело техники. Он не сильно привязывается к железу и все можно поправить руками, даже если сразу не заработает. У меня ни разу не было, чтобы я не перенес куда нужно было, linux сервер.

Добрый день...

Подскажите пожалуйста, я правильно понимаю, что если у меня sda = 2 tb и на нем LVM, который своими томами занимает только 700 gb, у меня не получится такой бэкап развернуть на sda = 1 tb?

Просто нужно сделать копию машины, а ничего другого как в 1 тб диска выделить никак не могу :(

Думаю, можно. Надо пробовать. По крайней мере виндовый софт для бэкапа умеет восстанавливать на диски меньшего объема, если данные реально умещаются. Конкретно про veeam не скажу, но можно еще попробовать clonezilla. В любом случае, можно и руками перенести если что.

По этой инструкции при бэкапе одного сервера с Linux agent`ом на другой, удаленный, сервер где установлен VBR, столкнулся с багом NATa, из за чего

бэкап не начинался из за невозможности подключится к IP сервера (при всех проброшеных портах на удаленном сервер). Решается это подменой IP на сервере где установлен агент через iptables: iptables -t nat -A OUTPUT -d ip1 -j DNAT --to-destination ip2 И все успешно начинает работать

Подскажите как забэкапить виртуальную систему centos и хранить бэкапы на компьютере под управлением windows в локальной сети (в расшаренной папке). Veeam Agent for Linux такое умеет? Чтобы можно было развернуть резервную копию на Hyper-V.

Да, умеет. Можно указать расшаренную папку в качестве приемника бэкапов.

Наверное совсем глупый вопрос: NFS или SMB указывать? Места в папке tmp должно быть достаточно для резервной копии перед тем как она переместится в расшаренную папку или копия делается "на лету"?

Смотря что у вас настроено, то и указывайте. Насчет свободного места ничего не могу сказать, не тестировал. Места точно должно быть какое-то количество, но вот в полном объеме или частичном, не знаю.

Спасибо. Буду разбираться, планирую на WINDOWS 2012 r2 открыть NFS шару и складывать в неё бэкапы.

Как вы считаете, такой вариант бэкапа сервера например POSTFIX жизнеспособен? Например в случае порчи виртуальной машины, развернуть её заново в разумные сроки.

Думаю да, продукт вроде неплохой. Я его немного использовал, когда он только вышел, но там были баги. Пару раз у меня сервер зависал из-за него. Но это было давно. Думаю, эти ошибки исправили.

Сделайте бэкап и попробуйте развернуть. Если все получится, то используйте и разворачивайте время от времени для проверки.

Забэкапил postfix на hyper-v (система на разделе 50Gb+ примонтированный диск для почты) на NFS-ресурс. Почты около 40 Гб, на бэкап ушло не более 5 минут.

Перед восстановлением создал аналогичную виртуальную машину (раздел 50Гб + диск для почты), загрузился с Veeam Linux Recovery Media, указал какие диски куда восстанавливать, на восстановление так же: не более 5 минут.

Отключил сетевой интерфейс, стартовал систему, на первый взгляд всё в порядке. Работоспособность почтовых сервисов на восстановленной копии проверю на выходных, думаю всё должно быть в порядке.

Огромное спасибо за ваши инструкции и ответы!

Если система загрузилась нормально и в системном логе нет ошибок, то значит все в порядке.

Добрый день,

Делаю все по вашей инструкции. Запускаю бэкап своего сервера VPS Ubuntu 18.04 на disk.keyweb.de и поcлe пару секунд:

Latest backup sessions:

Job name State Started at Finished at

BackupJob1 Failed 2019-12-12 16:18:53 2019-12-12 16:18:55

Backup 0% Status: Failed

потом смотрю SHOW:

Summary Data

Duration: 00:00:02 Processed: ---

Processing rate: --- Read: ---

Bottleneck: --- Transferred: ---

Time Action Duration

16:18:53 Job BackupJob1 started at 2019-12-12 16:18:53 GMT

16:18:54 Preparing to backup

16:18:55 [error] Failed to perform backup

16:18:55 [error] No objects to backup

16:18:55 [error] Processing finished with errors at 2019-12-12 16:18:55 GMT

Вот ошибка:

No objects to backup

Вы не указали, что бэкапить.

я же выбрал весь диск

вот попробовал все папки выбрать, не дает. А вот выбрал одну папку /mybackup - пошло.

не всё бэкапит даже с папки одной.

Backup 100% Status: Warning

Summary Data

Duration: 02:18:18 Processed: 15.2 GB (100%)

Processing rate: 1.9 MB/s Read: 15.2 GB

Bottleneck: Target Transferred: 14.1 GB (1.1x)

Time Action Duration

18:43:56 [warn] Failed to backup [/files_backup/Systemback/.S00_2019-12-06,13.47.21... ↑

18:43:56 [warn] Failed to backup [/files_backup/Systemback/.S00_2019-12-06,13.47.21... │

18:43:56 [warn] Failed to backup [/files_backup/Systemback/.S00_2019-12-06,13.47.21... │

18:43:56 [warn] Failed to backup [/files_backup/Systemback/.S00_2019-12-06,13.47.21... │

18:54:55 Backing up summary.xml 00:00:01 │

18:55:12 Releasing snapshot 00:00:02 ▒

18:55:14 [warn] Processing finished with warnings at 2019-12-12 18:55:14 GMT ↓

Veeam Agent for Linux [ mail.svergun.net ]

Summary

────────────────────────────────────────────────────

Name │

Backup mode │ Job name: Backup_server

Destination │

Network │ Destination: disc.keyweb.de/kdXXXXXXXX

Advanced │ Backup: Entire computer

Schedule │ Schedule: Daily at 06:00

> Summary │

│ To start the job out of schedule execute:

│ veeamconfig job start --name "Backup_server"

│

│ [X] Start job now ────────────────────────────────────────────────────

[Prev] [Finish] [Cancel]

и потом все как в первом посту.....

Здравствуйте, Zerox!

В первую очередь, хотел бы вас поблагодарить за статью. У меня есть вопрос, Veeam предназначен только для резервного копирования виртуальных машин?

Не получится его средствами забекапить реальную систему (почтовый сервер) развернутую на десктопе или физ. сервере.

Получится забэкапить физический сервер. Принципиальных отличий с виртуальной машиной нет. Нюансы могут возникнуть при восстановлении, но все это решаемо. На будущее, рекомендую все настраивать в виртуальных машинах, а на железо ставить только гипервизоры. Это в разы облегчает обслуживание и сопровождение.

При бэкапе сервера столкнулся в проблемой, почтовик (iredmail сборка) прислал алерт мне в ящик:

mail is critical - disk space usage - disk_space._tmp__fbab37c9-0868-4615-92fe-b599d98f94da_

disk_space._tmp__fbab37c9-0868-4615-92fe-b599d98f94da_

CHART

disk space usage = 100%

current disk space usage

ALARM

Как следствие, veeam на 8% завершает работу с ошибками.

09:47:14 Starting full backup to Repository_1

09:47:54 [error] Backing up sdb 1.3 GB at 55.7 MB/s (8%)

09:49:33 [error] Failed to perform backup 09:49:33 [error] Input/output error

09:49:33 [error] POSIX: Failed to read data from the file [/dev/veeamimage0]

09:49:33 [error] Failed to upload disk

09:49:33 [error] Agent failed to process method {DataTransfer.SyncDisk}

09:49:33 [error] Exception from server: Input/output error

09:49:33 [error] POSIX: Failed to read data from the file [/dev/veeamimage0]

09:49:33 [error] Unable to retrieve next block transmission command. Number of already processed blocks: [1583] 09:49:33 [error] Failed to download disk

09:49:33 [error] Processing finished with errors at 2019-10-15 09:49:33

Перенос осуществлялся на такой же физический сервер по NFS. Какая-то часть записалась, на эти 8% ну и далее собственно всё.

Вы не сталкивались с подобной проблемой?

Тут четко написано, в чем проблема:

disk_space._tmp__fbab37c9-0868-4615-92fe-b599d98f94da_

CHART

disk space usage = 100%

current disk space usage

Veeam во время бэкапа использует раздел tmp для формирования образа. На этом разделе мало места. Решите как-то этот вопрос. Либо перенесите tmp, либо как-то нарастите место. Все зависит от разбивки дисков. Если на других разделах есть место, то просто перенесите туда /tmp и сделайте символьную ссылку.

Спасибо вам за ответ. Пойду решать этот вопрос.

Давно с никсами не пересекался, но тем не менее..

А что мешает использовать обычные инструменты типа cp bzip и т.п.? Так или иначе все дисковые устройства представлены в виде файлов, все папки и файлы подлежат копированию хоть посредством cp, хоть через тот же cat через pipe (|) в тот же bzip.

Иными словами делаем скрипт, в котором делаем копию нужного в архив, а после архив доступными средствами сливаем хоть по ftp, хоть по smb, хоть по nfs, хоть по почте отправляем.

Странный вопрос, зачем нужна готовая программа, если можно все самому наколхозить скриптами. Удобно как минимум тем, что тут не надо делать лишних движений, копируется сразу все - файлы, разметка диска, загрузчик и т.д. в удобном и понятном интерфейсе, с отчетами, статистикой, планировщиком. Потом загружаешься с boot cd и быстро восстанавливаешь сразу все. А так, в принципе, можно и программы самому писать, компилировать, а не брать готовые.

Ну просто в описанном вами варианте тоже хватает "плясок с бубном". При этом, на мой взгляд, любой админ, который так или иначе админит никсовые сервера, просто обязан понимать как и для чего делаются скрипты и быть в состоянии их наваять. Скрипт бэкапа, описанный мной, при написании занимает ну от силы минут 5 времени (с чтением манов).

восстановление из такого архива - процесс настолько "сложный", что современные пользователи регулярно его используют на своих рабочих станциях.

ну а загрузчик не всегда требуется восстанавливать, если только вы бэкапите вообще весь сервер. Но как по-мне проще сделать описанную у вас же быструю установку, а потом на неё раскатать архив. Ну или опять же полистать маны того же груба, грузиться с лайва и к команде на распаковку добавить команду установки загрузчика... ну может две-три команды (монтирование, смена рута, установка груба).

Это особенность никсов, тут для многих "непростых" для венды вещей есть вполне базовый набор команд, который не требует глубоких познаний в никсах.

С другой стороны если вы всего-лишь пользуетесь операционкой, а не админите её - тогда да, такого рода программы на вес золота ))

Исходя из того, сколько статей у вас тут посвящено администрированию - мне как-то странно видеть подобного рода утилку. А учитывая описанные в комментах проблемы с ней - странно вдвойне.

Если самому настраивать подобные бэкапы не трудно, то вот вам вопрос сходу. Как организовать хранение только последних 30 резервных копий файлов? Есть директория, куда складываются архивы. Ваша задача сделать так, чтобы там лежали только последние 30 версий, а более старые удалялись. В один день может быть создано более одного архива, так что простой поиск по дате и удаление версий старше 30-ти дней не подходит.

При запуске dracut initramfs он напишет что не может перезаписать текущий initram, поэтому команду надо запускать с ключом --force.

Почему может выдаваться ошибка о разницах ключей при установке?

https://cdn1.savepice.ru/uploads/2018/10/24/61b82c144465314641724c6a8bbef5e6-full.png

Дальше Update не идет.

Это уже вопрос к репозиториям и ключам в них. Надо разбираться. Я сейчас не использую нигде veeam. Словил несколько раз зависание сервера во время бэкапа. Решил, что мне такой инструмент не подходит.

Понятно, спасибо! Ну у себя вроде пока зависаний не ловил. А чем бекапы юзаете если не секрет ?

Нужно снять Центос+Астерикс образ на всякий случай

Образ виртуальной машины средствами гипервизора. Это актуально, если vm не очень большая. Если большая, то делаю отдельно системный размер, бэкаплю его опять же через гипервизор. А данные уже другими способами, в зависимости от ситуации (в основном rsync использую).

Да нет, отдельная физ железка. Можно конечно выключить и снять акронисом каким-нить, но хотелось бы без ежемесячных выключений. Понял, спасибо.

P.S. не находили что-нить новенькое по тайм менеджменту но уже более актуальное для наших реалий ?

Слушайте, а если вытащить диск из старого компа с настроенным Линуксом и переставить в новый комп, в новом компе Система заведется или нет?

То, что заведется без лишних телодвижений шансов не много. Нужно будет скорее всего fstab поправить, сеть. Может что-то еще. В целом это реально, но нужно разбираться в теме.

День добрый, я не совсем понял, можно ли использовать данный метод для переноса CentOs с Asterisk на другое железо, попробовал на виртуалке копировать машины, все заводится, но они голые, а вот с настроенными сервисами будет ли работать? И вопрос в момент копирования, машина на которой происходит копирование, живая, продолжает работать или в зависшем состоянии будет стоять пока процесс не закончится?

Тут нужно пробовать. Теоретически, можно перенести и машину с работающими сервисами. А практически как это получится - не известно. Лично я сам сталкивался с проблемами в переносе именно астериска. И тут на форуме или где-то в комментариях тоже кто-то высказывался на этот счет. Из-за разных процессоров на серверах, пришлось пересобирать заново астериск из исходников, после переноса. Но в целом все равно все заработало. Все настройки и все остальное. Именно пересобрать надо было на новом железе. Не факт, что вы с этим тоже столкнетесь.

В любом случае, нужно предварительно все проверить. Останавливать машину во время копирования не надо, все происходит на работающей системе. Но лично я несколько раз ловил зависания в момент работы veeam, поэтому не советую экспериментировать в рабочее время. На всякий случай, пробуйте в момент максимального простоя.

Доброго времени суток!

У Вас был опыт конвертации виртуалок из VirtualBox в Hyper-V?

Пробовал конвертировать виртуальный диск в VHD, но получил kernel panic.

ОС - Altlinux 6.0 Школьный сервер.

Из Virtualbox ни разу не переносил. И Altlinux никогда не использовал. В целом, перенос всегда возможен, линукс переносится между различным железом и платформами, но нужно по месту разбираться с ошибками. Где-то загрузчик исправить, где-то initramfs пересоздать, где-то fstab изменить и т.д. Вариантов много различных.

Очень успешно повторил описаный способ. Работает просто и удобно

https://lan-meister.blogspot.com/2018/07/blog-post_17.html#more

Ясно, спасибо за совет!

А вообще что то случилось с cifs. При попытке монтирования каталога где были бэкапы выдаёт ошибку:

mount error(127): Key has expired

Refer to the mount.cifs(8) manual page (e.g. man mount.cifs)

Непонятно только что за ключ?, срок действия которого истёк... Может в этом и вся проблема?

У меня 100% была такая ошибка. Но не помню, как решал. Может банально перезагрузка помогла. В англоязычном гугле полно тем на счет этой ошибки. Может время сильно разошлось, если сетевая папка на винде. Может там пароль юзера просрочился. В общем, много вариантов может быть, надо все проверять.

Направление понял, б/спасибо!. буду искать

Да, на самом деле причина оказалась в настройках пользователя на сервере куда шли бэкапы - стояла галка напротив "Требовать смены пароля при следующем входе в систему".

При попытке создания бэкапов на Centos7 появилась такая ошибка:

mount error(127): Key has expired

Refer to the mount.cifs(8) manual page (e.g. man mount.cifs)

Exit code: [32]

Failed to execute script command mount

Unable mount device[//192.168.0.8/backup-asterisk] to [/tmp/veeam/192.168.0.8backup-asterisk].

При открытии в окне программы неудавшейся бэкап-сессии выдаёт следующее:

06:30:01 Job BackupJob1 started at 2017-11-24 06:30:01 MSK

06:30:01 Retrying the job

06:30:01 [error] Failed to perform backup

06:30:01 [error] mount error(127): Key has expired

06:30:01 [error] Refer to the mount.cifs(8) manual page (e.g. man mount.cifs)

06:30:01 [error] Exit code: [32]

06:30:01 [error] Failed to execute script command mount

06:30:01 [error] Unable mount device[//192.168.0.8/backup-asterisk] to [/tmp/veeam/192.168.0.8backup-asterisk]

06:30:01 [error] Unable get share repository resource

06:30:01 [error] Unable create OnShareRepositoryEx

06:30:01 [error] Processing finished with errors at 2017-11-24 06:30:01 MSK

Что за ерунда такая случилась? Что за ключ, у которого закончился срок действия? Вплоть до 17го числа бэкапы создавались по расписанию как положено.

Вообще говоря, я отказался от этого продукта. Во время бэкапа у меня разок сервер жестко повис, помог только хард ресет. И большое количество ошибок тут в комментариях намекает на то, что продукт не готов к продакшену. Очень жаль :( Я возлагал на него большие надежды. Подожду пол годика, может быть допилят. В таком виде на боевых серверах я считаю его нельзя использовать.

Логи продукта и системные (в т.ч. "ядерные") сохранились? В саппорт ходили?

Не вот это ли у вас произошло?

https://forum.sys-adm.in/index.php?topic=5202.0

была ошибка, после обновления veeam, самоустранилась

Интересно, забекапить zimbra можно будет агентом под linux... Может кто уже пробовал?

Думаю да. Если в целом бэкап заработает, то и зимбра забэкапится. Она же на обычном линуксе работает. Тут пока сам не проверишь конкретно на своем сервере, не узнаешь наверняка.

Спасибо, будет время - попробую

приветствую. вылезла проблема

система CentOS Linux release 7.4.1708 (Core)

при запуске бэкапы вываливается с ошибкой

[error] Failed to create volume snapshot

[error] Failed to perform backup

[error] Child execution has failed. Exit code: [1]

[error] Failed to load module [veeamsnap] with parameters [zerosnapdata=1 debuglog...

в интернетиках пишут то может не совпадать версии, но у меня все совпадает

rpm -qa | grep veeamsnap

veeamsnap-1.0.1.364-1.noarch

uname -r

3.10.0-693.2.2.el7.x86_64

rpm -qa | grep kernel-headers

kernel-headers-3.10.0-693.2.2.el7.x86_64

есть мысли по решению?

Выше в комментариях человек написал, как решил такую же проблему.

выше таких же проблем как у меня не нашел

пришлось ковырять самому, набрел на тему на офф форуме

forums.veeam.com/veeam-agent-for-linux-f41/failed-to-load-module-with-parameters-zerosnapd-t40889.html

там советую проверить модуль veeamsnap

"Let me a little tediousness: veeamsnap is a DKMS module. DKMS modules have 4 states: not in a tree, added, built and installed. More info: http://www.linuxjournal.com/article/6896

In general, the said error message means that veeamsnap module hasn't been installed. You can check its status by running the following command

# dkms status

If the output looks like 'veeasnap added' this message means that module has been added, but hasn't been built and hasn't been installed. In the most cases, this status means that your OS doesn't have corresponding kernel-devel and kernel-headers for the current kernel. When you install them (missing packages) you can either re-install Veeam Agent for Linux in order to execute DKMS hooks which will rebuild and install veeamsnap or rebuild it manually by executing the following commands:

# dkms remove -m veeamsnap/1.0.0.944 --all

# dkms build -m veeamsnap -v 1.0.0.944

# dkms install -m veeamsnap -v 1.0.0.944

I hope my message is informative and helpful."

на шаге dkms build -m veeamsnap -v 1.0.1.364

возникает ошибка Your kernel headers for kernel 3.10.0-693.2.2.el7.x86_64 cannot be found at

/lib/modules/3.10.0-693.2.2.el7.x86_64/build or /lib/modules/3.10.0-693.2.2.el7.x86_64/source.

упорное гугление вывело на то что

"I suspect that at some point you did a yum update or similar, and that actually installed a new kernel, but you have not yet started running it. "

пробуем

yum install "kernel-devel-uname-r == $(uname -r)"

Loaded plugins: fastestmirror, replace

Loading mirror speeds from cached hostfile

* webtatic: uk.repo.webtatic.com

No package kernel-devel-uname-r == 3.10.0-693.2.2.el7.x86_64 available.

Error: Nothing to do

пришлось искать качать и ставить вручную

https://centos.pkgs.org/7/centos-updates-x86_64/kernel-devel-3.10.0-693.2.2.el7.x86_64.rpm.html

rpm -i kernel-devel-3.10.0-693.2.2.el7.x86_64.rpm

после этого уже можно делать

# dkms build -m veeamsnap -v 1.0.1.364

# dkms install -m veeamsnap -v 1.0.1.364

после этого бэкап успешно запустился

надеюсь будет полезно

Вот человек по сути то же самое сделал

https://serveradmin.ru/backup-i-perenos-linux-servera/#comment-2828

За комментарий с решением спасибо.

На работу asterisk как-то повлияли данные манипуляции ?

Да, Вы правы. Я сразу так и поступил (пересобрал aster), но думал, что может есть более короткое решение. Спасибо за ответ!

Делаю бэкап сервера на Centos 7 с астериском. Потом делаю восстановление из созданного бэкапа на другом железе. Всё хорошо разворачивается, за исключением: Нет конекта с asterisk`ом. Ошибка: Unable to connect to remote asterisk (does /var/run/asterisk/asterisk.ctl exist?). Файл asterisk.ctl в наличии. Пробую перезапускать asterisk - без результата. В чём может быть причина?, и что делать?

Я с этим сталкивался. По-моему даже писал об этом где-то на сайте. Если найду - сообщу. Если из исходников собирали, то надо пересобрать на новом железе.

Нашел, у меня вот такая ошибка была при переносе на другое железо:

https://serveradmin.ru/traps-asterisk-trap-invalid-opcode/

Помогла пересборка.

места много свободного есть на smb (где то в 1000 раз больше того, что нужно)

в любом случае, спасибо за участие, буду копать дальше

На самом сервере, который бэкапится, тоже должно быть свободное место.

/dev/md2 1,8T 620G 1,1T 37%

devtmpfs 24G 0 24G 0%

tmpfs 24G 0 24G 0%

tmpfs 24G 2,6G 21G 12%

tmpfs 24G 0 24G 0%

tmpfs 256M 207M 50M 81%

/dev/md1 488M 379M 84M 83%

tmpfs 4,8G 0 4,8G 0%

tmpfs 4,8G 0 4,8G 0%

tmpfs 4,8G 0 4,8G 0%

tmpfs 4,8G 0 4,8G 0%

tmpfs 512M 43M 470M 9%

tmpfs 256M 8,3M 248M 4%

tmpfs 4,8G 0 4,8G 0%

tmpfs 4,8G 0 4,8G 0%

tmpfs 768M 495M 274M 65%

tmpfs 4,8G 0 4,8G 0%

/dev/veeamimage1 1,8T 1,8T 0 100%

Причин может быть много, нужно смотреть что за ошибка в сессии бэкапа показана, отсюда плохо видно. Сходите для начала на форум их, а дальше по ситуации - либо ошибка известная и форума хватит, либо в саппорт отправят.

добрый день

при запуске первоначального бекапа на smb сервер залипла на 511,7 Мб

попытка снять с выполнения привела к тому, что статус поменялся на Stopping, но висит так же, ничего не меняется

подскажи, пож, Куда копать, что можно сделать ?

Службу veeamservice перезапустить:

# systemctl restart veeamservice

спасибо

после перезапуска службы "висеть" перестал, но и дальше тех же 511,7 Мб не двигается.

заканчивает бекапировать со стейт failed

Дальше логи надо смотреть в /var/log/veeam. Они достаточно подробные. Скорее всего там будет какая-то ошибка.

Изучаю логи, если честно, пока понять ничего не могу.

Наверное наглость с моей стороны, но если есть возможность - посмотрите пож ? http://transfiles.ru/fbynb

Ошибки же видно. Искать по слову "Failed". Надо разбираться подробно, в чем там дело. Я так не помогу. Может просто места на дисках нет свободного? Для бэкапа нужен какой-то свободный объем.

Welcome to SUSE Linux Enterprise Server 11 SP2 (x86_64) - Kernel \r (\l).

Судя по документации, версия эта поддерживается

https://www.veeam.com/veeam_agent_linux_1_0_user_guide_pg.pdf

Такая же ошибка уже была у одного пользователя выше. Не знаю, как он ее решил. Возможно, поможет запрос в техподдержку. Мне нечего посоветовать.

спасибо

скажи пожалуйста , а другими средствами можно перенести физ сервак на виртуалку hyper-v ?

Clonezilla, Acronis. Как минимум у них заявлен этот функционал, но сам я не пользовался ими, хотя знаю, что clonezilla нормально сервера переносит один в один. Главное, чтобы сама система завелась на новом железе. Возможно в ней самой нужно будет что-то редактировать (пересобирать ядро, править загрузчик, initramfs, fstab и т.д.) В общем, нюансов может быть много. Linux в принципе труднее переносить с железо на железо в автоматическом режиме, чем винду.

Это известный баг

https://forums.veeam.com/veeam-agent-for-linux-f41/unable-to-start-veeam-t45138.html

вам в саппорт нужно, они скажут что дальше делать

доброго дня, скажите пожалуйста после установке возникли вот такие ошибки

bis2:~ # veeam

Error: No such file or directory

Failed to connect: /tmp/veeam/socket/veeam.sock.

Failed to connect to local socket.

Система какая? На CentOS 7 у меня ни разу не было никаких проблем с установкой и запуском.

Linux bis2 3.0.13-0.27-default #1 SMP Wed Feb 15 13:33:49 UTC 2012 (d73692b) x86_64 x86_64 x86_64 GNU/Linux

Здесь только версия ядра. Не понятно, какой дистрибутив. Явно что-то очень старое.

Установил veeam на Centos7. При выборе C (configure) для настройки задания на backup выдаётся ошибка: LvmDriver: Failed to create LVM instance. В чём причина и как исправить?

Решение проблемы нашёл на сайте veeam: https://www.veeam.com/kb2334

Необходимо отредактировать файл /etc/lvm/lvm.conf

Секция Configuration section global, изменить units = "r" на "h"

Отлично, спасибо за информацию. Дополню статью.

Еще раз спасибо за информацию. Тоже словил эту ошибку после обновления centos. Оказывается бэкапы с этого времени не делались :(

окей, извиняюсь (( был не прав... (, тогда вопрос другой, как то можно удалить бэкап сессии ? А то уж больно глаза мазолят (

Боюсь что никак, разве что переустановить продукт или руками убрать /var/lib/veeam/veeam_db.sqlite

Спасибо !

Можно ли как то удалить Jobs'ы а то я насоздавал ради теста, удалить не могу (((

Можно. Там же в интерфейсе программы.

нет, нельзя, попробуйте, я целых два часа над этим парюсь

Все доброго времени суток.

Попробуйте вызвать из строки veeamconfig job delete --name %имяДжобы%

Пробовал, задания все равно остаются

Попробуйте сами, вдруг я где то ошибся, хотя наврятли ....

Я выполняю:

# veeamconfig job delete --name BackupJob1

и получаю:

Job has been deleted successfully.

Если вы под джобами имеете в виду то что видно на главном экране при старте меню, так то не джобы, а бэкап-сессии, т.е. хистори. убедиться что джоб не осталось сделайте

veeamconfig job list

На hetzner дешевле место арендовать и поддержка кучи протоколов и smb/cifs, sftp и т.д.

Можно ссылку на услугу?

Вот https://ru.hetzner.com/hosting/produktmatrix/storagebox-produktmatrix

Спасибо, на больших объемах получается очень выгодно, если только включенного трафика будет хватать. А как потом этот вопрос решать, если перерасход будет?

Пока что не знаю, не было пока есче такого

попробовал поставить Veeam на сервер астериска FreePBX

вот какая ошибка при запуске veeam

подскажите куда копать?

Error: No such file or directory

Failed to connect: /tmp/veeam/socket/veeam.sock.

Failed to connect to local socket.

Сервер перезагружали?

там телефония крутиться. в принципе можно попробовать

после перезагрузки тоже самое.

изначально не было даже папки /tmp/veeam/socket

создал папку

mkdir /tmp/veeam/socket

потом создал сокет

mkfifo /tmp/veeam/socket/veeam.sock

делаю права для veeam

chown -R veeam /tmp/veeam/socket

получаю в ответ:

chown: invalid user: `veeam'

Система какая? Или это готовый дистр от FreePBX?

готовый дистр Freepbx

x86

Тогда в этой системе могут быть нюансы. Я бы для начала на виртуальной машине развернул этот дистрибутив и потренировался на нем, а потом уже на боевом пробовал что-то делать.

да вроде тот же centos судя по всему. хех veeam такой удобный на других серверах. придеться что то другое ставить

Раз не работает, значит не тот же. Возможно в ядре что-то изменено или репы другие. Думаю, это решается.

veeam же я скачал и установил как то

при запуске команды yum install veeam выдает следующее:

Error: Package: veeamsnap-1.0.1.364-1.noarch (veeam)

Requires: dkms

Нужно попробовать вручную установить пакет dkms. Это на какой системе? Я на нескольких серверах с CentOS 7 ставил, всегда гладко проходила установка, без затыков и ошибок.

это на CentOS 7 с установленным сервером Zabbix. все по вашей статье делал.

[root@localhost ~]# yum install dkms

Loaded plugins: fastestmirror

Loading mirror speeds from cached hostfile

* base: http://ftp.nsc.ru

* extras: http://ftp.nsc.ru

* updates: http://ftp.nsc.ru

No package dkms available.

Error: Nothing to do

все разобрался ))

сначала yum -y install epel-release а потом уже сам dkms

Понятно, почему я не видел этой ошибки. Я всегда ставлю репозиторий epel сразу после установки сервера.

есть еще вариант исправления ошибки после переноса с kvm на hyper-v, который не требует установочного образа, выполняется из rescue mode:

• remove "rhgb" from the kernel command line in /etc/default/grub

• # systemctl daemon-reload

• generate a new /boot/grub2/grub.cfg:

grub2-mkconfig -o /boot/grub2/grub.cfg

• generate a new initramfs - varies based on your kernel!

mv /boot/initramfs-3.10.0-229.11.1.el7.x86_64.img /boot/initramfs-3.10.0-229.11.1.el7.x86_64.img.bak

dracut -v /boot/initramfs-3.10.0-229.11.1.el7.x86_64.img 3.10.0-229.11.1.el7.x86_64

Какая ошибка исправляется таким образом? Я не удалял модуль rhgb при переносе.

исправляет ошибки "Warning: dracut-initqueue timeout starting timeout scripts" и "a start job is running for dev-disk-by ......". как раз на этой неделе занимался миграцией centos7 и столкнулся с таким, выше приведенный способ исправляет их

а можно бекапнуть lxc контейнер в проксмок, а потом востановить обратно но на виртуалку KVM?

Не знаю, не пробовал. Не уверен, что это возможно. Контейнеры и виртуалки принципиально разные вещи.

На proxmox настроенный по мануалу https://serveradmin.ru/ustanovka-i-nastroyka-proxmox/

#uname -a

Linux proxmox 4.4.76-1-pve #1 SMP PVE 4.4.76-94 (Thu, 17 Aug 2017 14:21:30 +0200) x86_64 GNU/Linux

#lsb_release -a

Description: Debian GNU/Linux 8.9 (jessie)

Release: 8.9

Codename: jessie

бэкап пока не работает, пишет

Failed to load module [veeamsnap] with parameters [zerosnapdata=1 debuglogging=0]

возможно из-за нестандартного ядра т.к. по мануалам для veeam гарантируется работа только на стандартном ядре дистрибутива

https://helpcenter.veeam.com/docs/agentforlinux/userguide/system_requirements.html?ver=10

* As long as you use kernels supplied by your distribution.

А какой смысл сам гипервизор бэкапить? Достаточно только виртуалки. Я никогда гипервизоры не бекаплю. Их настроить с нуля быстрее, чем постоянно держать актуальный бэкап, а потом разворачивать его.

хм...про гипервизор этот момент не продумал, согласен.

Так а виртуалки есть ли смысл бэкапить другим инструментом, например в Proxmox есть бэкап виртуалок из коробки.

Надо смотреть по ситуации. Конечно, если гипервизор позволяет делать бэкапы, то пользоваться нужно именно этим средством, так проще и удобнее. Но, к примеру, proxmox делает только полные бэкапы, а veeam умеет инкрементные. Так что в отдельных ситуациях можно отдать предпочтение бесплатному veeam.

На debian 7.11 cразу не взлетело

#uname -a

Linux tower 3.16.0-0.bpo.4-amd64 #1 SMP Debian 3.16.39-1+deb8u1~bpo70+1 (2017-02-24) x86_64 GNU/Linux

#lsb_release -a

Description: Debian GNU/Linux 7.11 (wheezy)

Release: 7.11

при запуске процесса бэкапа ошибка:

Failed to load module [veeamsnap] with parameters [zerosnapdata=1 debuglogging=0]

После перезагрузки сервера, проблема ушла.

Привет! давече столкнулся с такой же проблемой. только на freepbx distro после обновлений(видимо не могут они нормально поднимать ядро), до этого все нормально работало)) Решилось созданием симлинка build в папке /usr/lib/modules/"ваша версия ядра" на /usr/src/kernels/"ваша версия ядра" и симлинка source в папке /usr/lib/modules/"ваша версия ядра" на (как не удивительно) build.

После выполняем команды

смотрим билд веамснап sudo dkms status

dkms remove -m veeamsnap -v "билд веамснап " --all

dkms build -m veeamsnap -v "билд веамснап "

dkms install -m veeamsnap -v "билдвеамснап "

Если все ок, то ошибок быть не должно, можно полностью снести и переустановить веам дабы спокойнее было))

В общем, надеюсь это поможет кому-нибудь во избежании потраченного времени и нервных клеток)

Да, о нём.

Добрый день!

Полезная статья, не знал о таком сервисе.

В закладки, однозначно!

О каком сервисе идет речь? О Veeam?