Существует большое количество бесплатных программ для бэкапа информации. В своём Telegram канале я делал небольшие обзоры на множество из них. Решил составить список из наиболее популярных и функциональных, чтобы было удобно выбрать подходящую. Все программы опробованы и прокомментированы лично мной. Со временем список пополнялся, так что теперь это уже не заявленные изначально 12 программ для бэкапа, а значительно больше.

На углубленном курсе "Архитектура современных компьютерных сетей" вы с нуля научитесь работать с Wireshark и «под микроскопом» изучите работу сетевых протоколов. На протяжении курса надо будет выполнить более пятидесяти лабораторных работ в Wireshark.

Реклама ИП Скоромнов Д.А. ИНН 331403723315

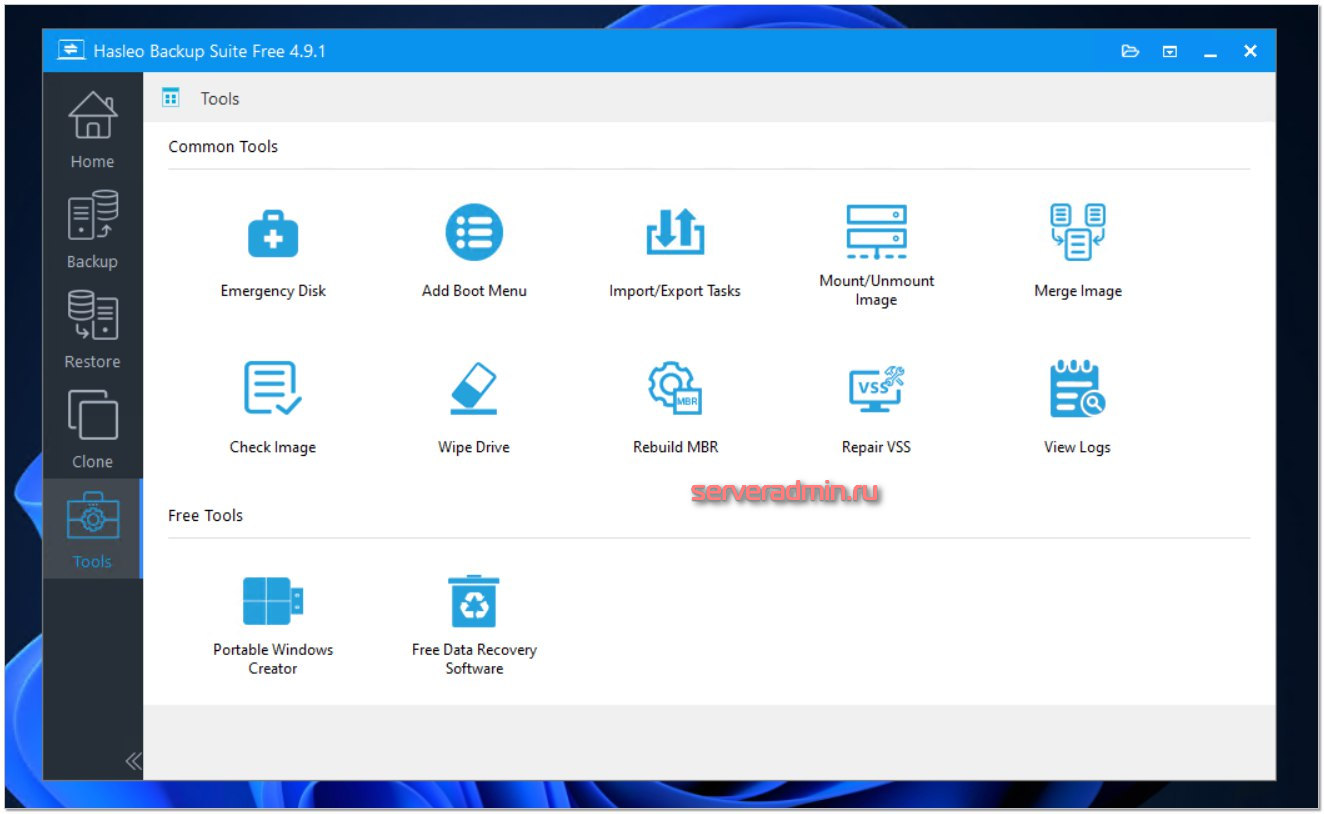

Hasleo Backup Suite Free

Сегодня будет заметка о неплохой бесплатной программе для бэкапа систем под управлением Windows, причём как обычных, так и серверных. Речь пойдёт про Hasleo Backup Suite Free. Я её установил и попробовал. Честно говоря, даже не понял, в чём тут подвох. Программа полностью бесплатна и при этом обладает очень неплохими возможностями. Кратко перечислю основные:

- Бэкап на уровне всей системы, диска, раздела или набора файлов и директорий.

- Клонирование системы, диска, разделов.

- Тип бэкапов: полный, инкрементный, дифференцированный.

- Поддержка расписания, политики хранения, очистки бэкапов.

- Универсальное восстановление системы на другое железо.

- Шифрование, проверка бэкапов.

- Создание загрузочного образа на базе WinPE.

- Логирование своей работы.

В этой системе есть всё, что ожидаешь от подобного продукта. Есть даже нормальный перевод на русский язык. Я на него посмотрел, явных ляпов не заметил, кроме разве что обозначения образа диска изображением. То есть монтировать не образ диска, а изображение диска. Она даже директории с бэкапами создаёт на русском языке: "Бэкап системы 20240903135711". В данном случае это скорее минус, чем плюс. Тут и русский язык, и пробелы. Лучше без этого обойтись и пользоваться английской версией.

Я проверил эту программу следующим образом:

- Установил на систему и сделал полный бэкап на сетевую папку.

- Через интерфейс программы создал загрузочный диск.

- Создал чистую виртуалку, загрузился с загрузочного диска.

- В загрузившейся системе назначил IP адрес, подключил сетевой диск.

- Восстановил из сетевого диска образ системы.

На удивление всё прошло гладко, быстро и просто. Загрузочный диск удобнее, быстрее грузится, нежели то же самое от Veeam Agent For Windows, которым я регулярно пользуюсь.

В общем и целом программа понравилась. Из бесплатных точно одна из лучших. В целом, я даже не придумал, что в ней не хватает. Есть всё, что нужно, без каких-то излишеств. Рекомендую 👍

⇨ 🌐 Сайт / Обсуждение

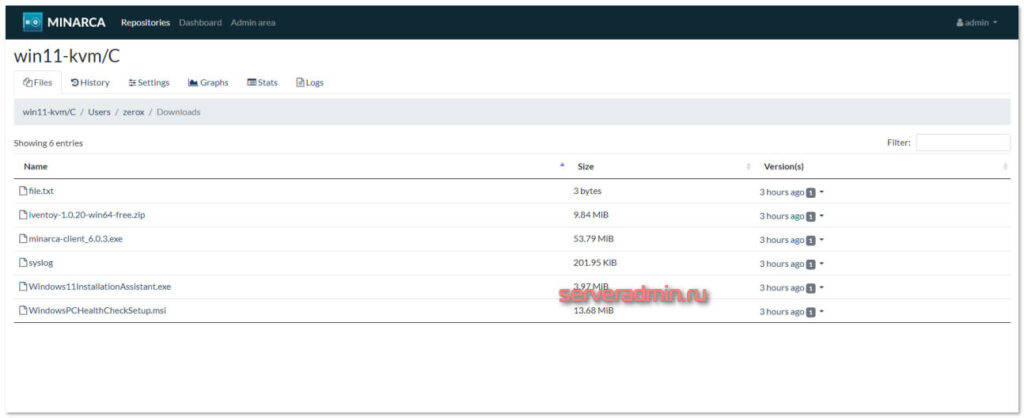

Minarca Backup

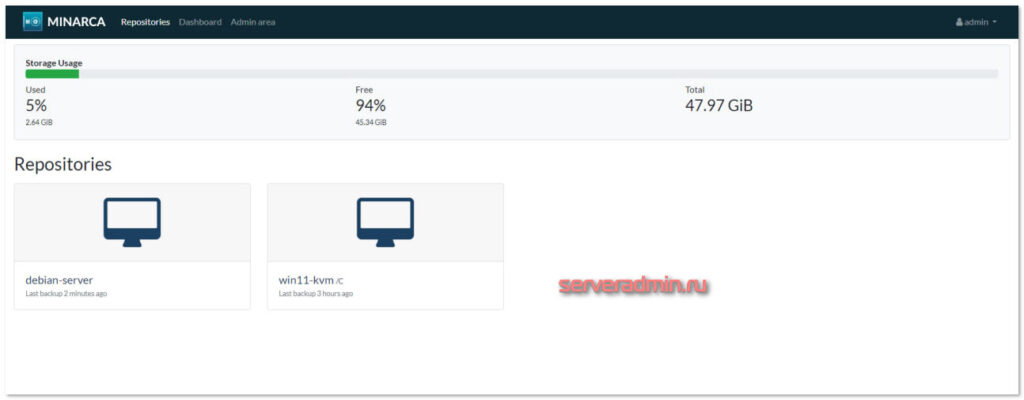

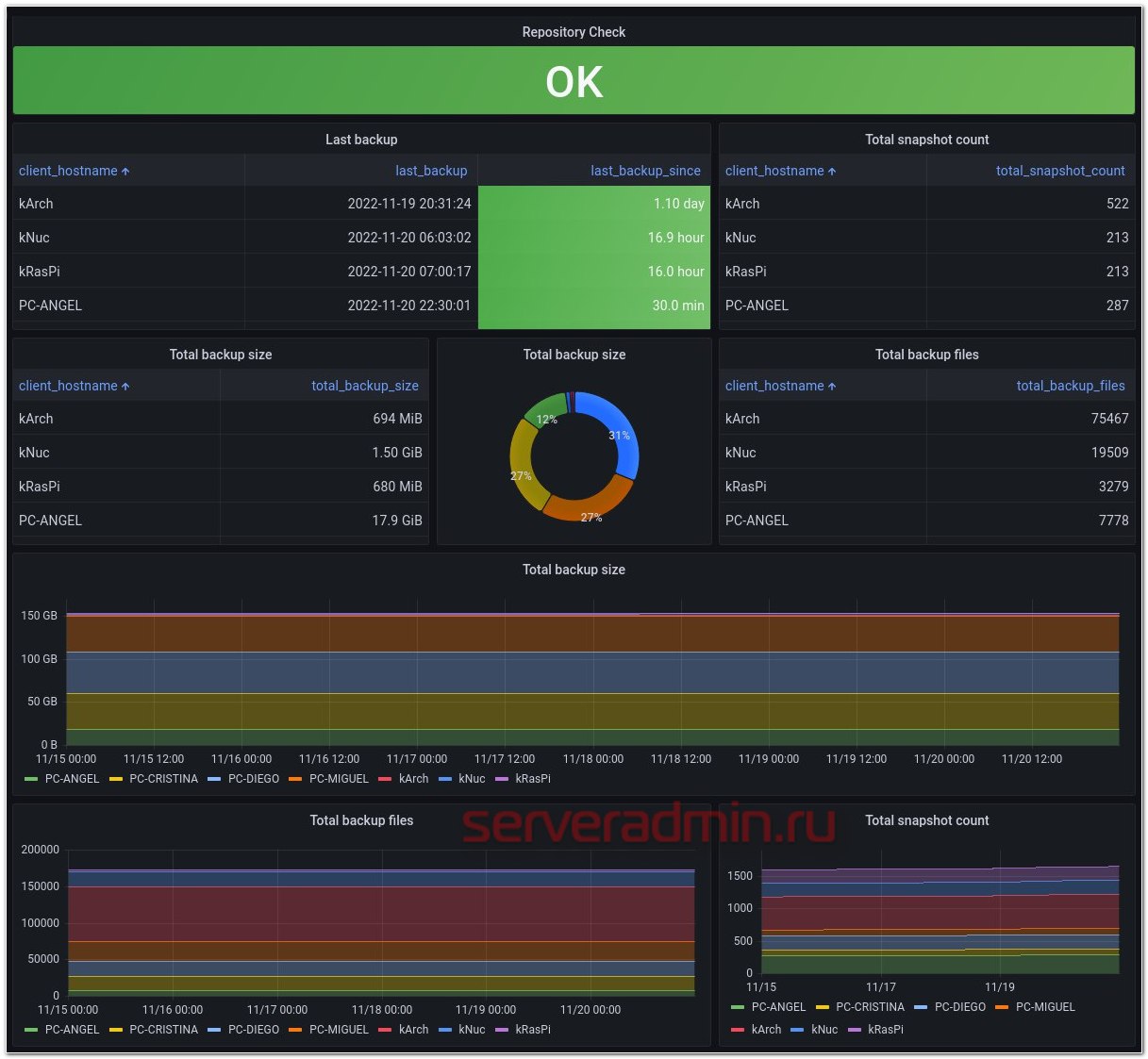

Недавно впервые услышал про новую для меня систему резервного копирования Minarca Backup. Беглый осмотр показал, что это что-то интересное, поэтому решил попробовать. Кратко скажу, что это open source клиент-серверная система с веб интерфейсом управления и локальными клиентами, которые нужно устанавливать на целевые машины, с которых снимается бэкап.

📌 Сделаю краткий акцент на основных моментах системы:

- сервер и клиенты можно установить на Liniux, Windows, MacOS;

- можно развернуть на своём железе;

- управление через cli или веб интерфейс;

- репозитории для хранения подключаются как локальные папки сервера;

- управлять доступом к бэкапам можно на уровне пользователей, поддерживается LDAP каталог для них, дисковые квоты;

- есть 2FA с отправкой кодов подтверждения на email;

- для установки сервера есть репозиторий с пакетами;

- данные от клиента на сервер передаются по протоколу HTTP с аутентификацией;

- бэкап выполняется на уровне файлов, нет возможности забэкапить всю систему разом или сделать образ диска;

- инициирует передачу данных на сервер сам клиент;

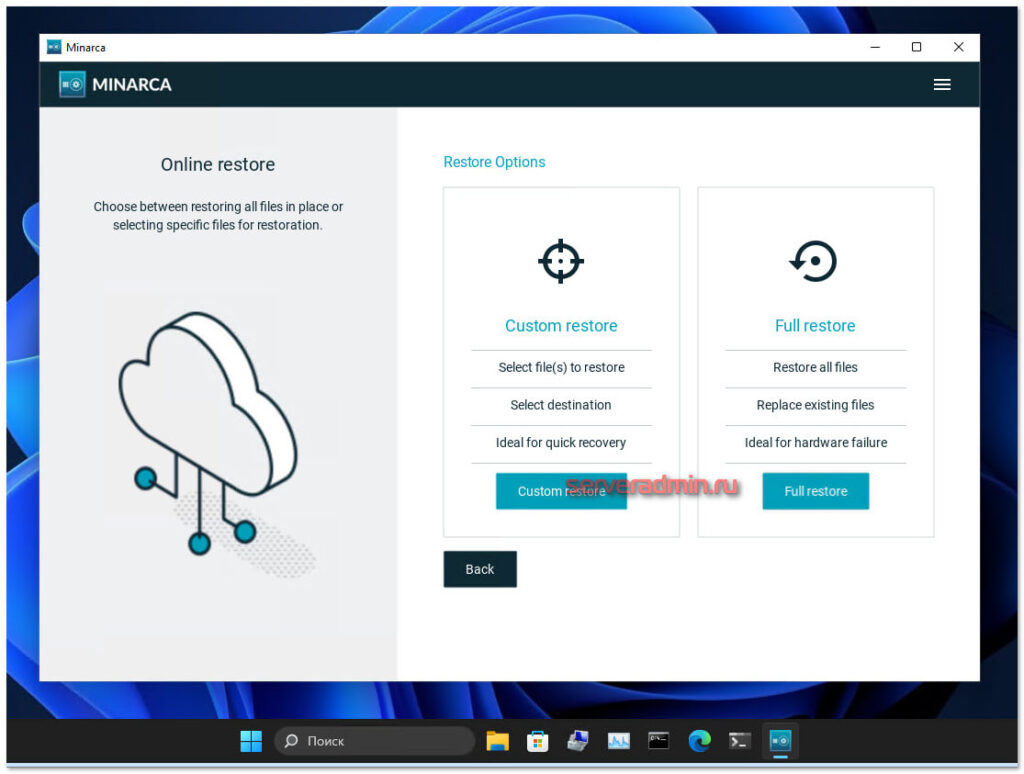

- клиент может самостоятельно инициировать восстановление своих файлов.

Установка сервера очень простая и типичная для готовых пакетов Debian:

# curl -L https://www.ikus-soft.com/archive/minarca/public.key | gpg --dearmor > /usr/share/keyrings/minarca-keyring.gpg # echo "deb [arch=amd64 signed-by=/usr/share/keyrings/minarca-keyring.gpg] https://nexus.ikus-soft.com/repository/apt-release-$(lsb_release -sc)/ $(lsb_release -sc) main" > /etc/apt/sources.list.d/minarca.list # apt update # apt install minarca-server

Судя по зависимостям серверной части, Minarca Backup построена на базе rdiff-backup. Который, в свою очередь, является python обёрткой вокруг rsync (используется библиотека librsync). Она наследует всю скорость и быстроту синхронизации сотен тысяч файлов, которую обеспечивает rsync. Это чтобы вы понимали, что там под капотом и чего стоит ждать от этой системы. Как по мне, так это плюс, что там rsync используется. Для бэкапа сырых файлов без дедупликации это хорошее, а может и лучшее решение.

Теперь идём по IP адресу на порт 8080 и используем учётную запись: admin / admin123. По умолчанию веб интерфейс открылся на русском языке.

После этого сходил на страницу загрузки, скачал и установил для теста клиентов на Linux и Windows. Можно всех клиентов подключать под одной учёткой, либо для каждого сделать свою. Это зависит от вашей схемы инфраструктуры. Если бэкапите пользователей, логично каждому из них сделать свою учётную запись, чтобы он имел доступ только к своим бэкапам.

Windows клиента настроил через GUI, а для Linux сервера использовал команду для подключения к серверу:

# minarca configure -r http://10.20.1.36:8080/ -u admin -p admin123 -n debian-server

Далее указал интервал для бэкапа и что бэкапим:

# minarca include /etc # minarca schedule --daily

Последняя команда создала запись в crontab для пользователя, под которым её запустил. Теперь можно выполнить принудительный бэкап:

# minarca backup --force

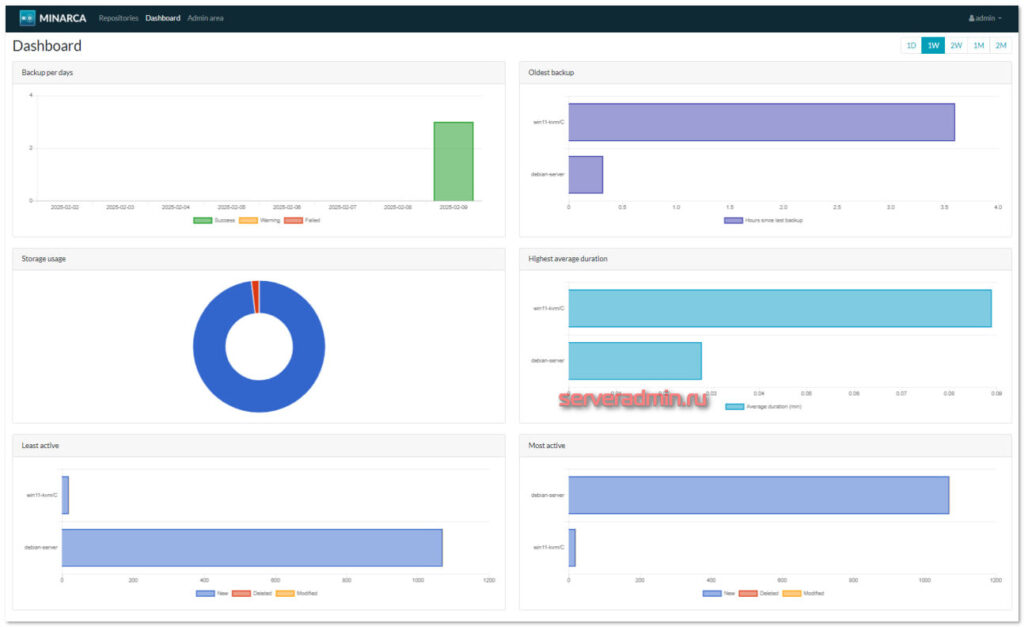

На сервере через веб интерфейс можно посмотреть забэкапленные файлы с обоих устройств.

Система относительно простая. Я практически сходу всё настроил и попробовал. Важно понимать, что она бэкапит только файлы, не системы целиком. Через клиент с GUI можно открыть календарь бэкапов, выбрать нужную дату, когда делался бэкап и восстановить файл.

Minarca Backup похожа частично на Kopia, но ещё больше на UrBackup, BackupPC и ElkarBackup. Причём я затрудняюсь сказать, какая из них лучше. На первый взгляд кажется, что они все примерно одного уровня, где-то одна лучше, где-то другая. Ну и нужно понимать, что сравнивать их с профессиональными платными системами от Veeam, Symantec и т.д. нет никакого смысла. Это разного уровня софт.

⇨ 🌐 Сайт / Исходники / Обзор / Обсуждение

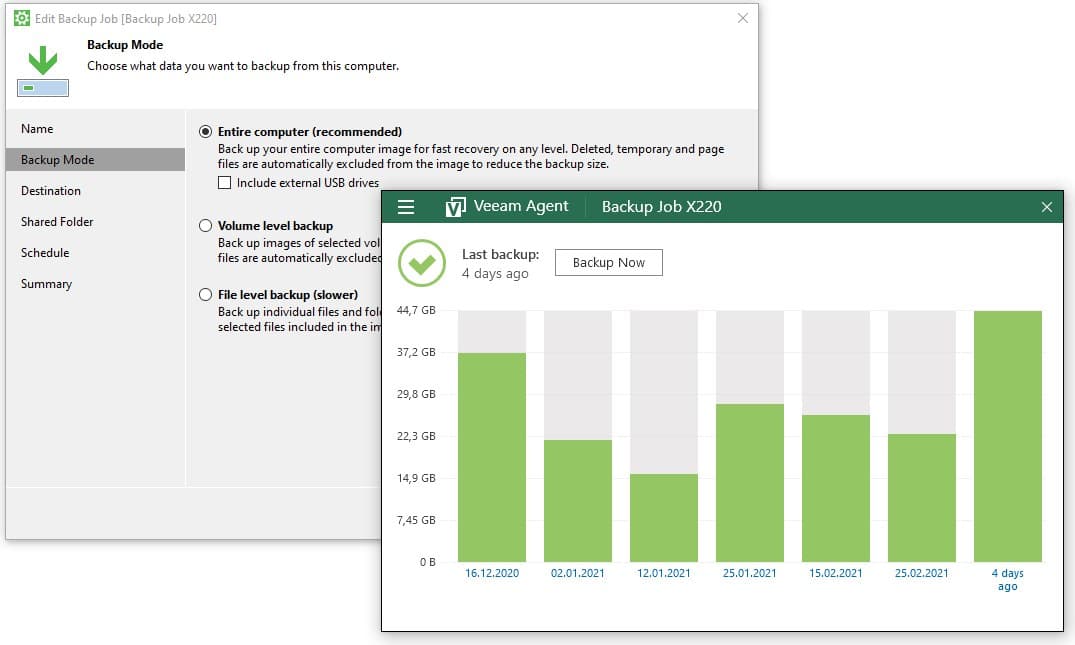

Veeam Agent for Windows or Linux Free

С его помощью можно бэкапить как целиком весь компьютер, так и отдельные диски и папки. После установки он создаст загрузочный диск, с помощью которого можно будет восстановить систему и залить бэкап, если совсем всё умрет. Поддерживает хранение бэкапов локально, на smb шарах, на usb устройствах. При подключении последнего может автоматом запускать бэкап.

Свой ноут лично я бэкаплю им же. Много раз уже выручал, так что рекомендую. Традиционно, софт от Veeam работает качественно и просто. Не надо долго разбираться с настройками. Так что добавить особо нечего. Берите и пробуйте. Работает как на Windows, так и Linux.

⇨ https://www.veeam.com/products/free/linux.html

⇨ https://www.veeam.com/products/free/microsoft-windows.html

Доступ по указанным ссылкам для IP адресов из РФ закрыт. Используйте обходные пути. На работе программ это никак не сказывается. Для установки и работы программе доступ в интернет не нужен.

У меня есть статья по работе с Veeam Agent for Linux:

⇨ Бэкап и перенос linux (centos, debian, ubuntu) сервера с помощью Veeam Agent for Linux

Она написана давно, поэтому я решил проверить, насколько актуален тот метод восстановления, что там описан. Забегая вперёд скажу, что актуален. Изменились некоторые детали, но в основном всё то же самое.

Я себе поставил задачу – перенести виртуальную машину от обычного хостера, где используется стандартная услуга VPS и больше ничего. То есть у вас система на одном жёстком диске заданного размера. Задача перенести её в исходном виде к себе на локальный гипервизор Proxmox. В итоге у меня всё получилось. Рассказываю по шагам, что делал.

1️⃣ Скачал с сайта Veeam файл с репозиторием для Debian veeam-release-deb_1.0.8_amd64.deb и загрузочный ISO для восстановления Veeam Linux Recovery Media. Для загрузки нужна регистрация.

2️⃣ Скопировал файл с репозиторием на целевой сервер и подключил его:

# dpkg -i veeam-release-deb_1.0.8_amd64.deb

3️⃣ Установил veeam и дополнительные пакеты:

# apt install blksnap veeam cifs-utils

4️⃣ К сожалению, понадобилась перезагрузка сервера. Без перезагрузки не создавался бэкап. Veeam ругался, что не загружен модуль для снепшота диска. У меня так и не получилось его загрузить вручную. Вроде всё делал, что надо, но не заработало. Пришлось перезагрузиться и проблема ушла.

5️⃣ Так как на сервере у нас только один диск, мы не можем на него же класть бэкап, когда будем делать образ всей системы. Я решил использовать сетевой smb диск с другой виртуальной машины, которая запущена на целевом Proxmox, куда буду переносить систему. Для этого на ней поднял и настроил ksmbd, затем с помощью ssh настроил VPN туннель между машинами. Всё делал прям по инструкциям из указанных заметок. Заняло буквально 5-10 минут.

6️⃣ Запустил на целевой машине veeam:

# veeam

И с помощью псевдографического интерфейса настроил задание для бэкапа в сетевую папку smb. Там всё просто. Немного затупил с правильностью указания настроек для smb, так как не сразу понял формат, в котором надо записать путь к серверу (на картинке снизу скриншот правильных настроек). Но быстро разобрался. И ещё важный момент. На smb шару у вас должны быть права на запись. Если их нет, получите неинформативную ошибку. Я с этим проковырялся немного, пока не догадался проверить. Оказалось, что забыл дать права на запись в директорию, которая монтировалась по smb.

7️⃣ Запустил задание бэкапа и убедился, что он прошёл без ошибок.

8️⃣ Сделал на Proxmox новую виртуальную машину с диском, у которого размер не меньше исходной машины, которую бэкапили. Это важно. Даже если на диске занято очень мало места, перераспределить его при восстановлении на меньший диск не получится. Veeam просто не умеет этого делать.

9️⃣ Загрузил новую виртуалку с Veeam Linux Recovery Media, подключил туда по smb тот же сетевой диск, куда делал бэкап и успешно выполнил восстановление. Всё прошло без сучка и задоринки. Виртуалка сразу же загрузилась с восстановленного диска и заработала без каких-то дополнительных действий.

Такой вот полезный инструмент. Если локально ещё есть разные варианты, чем забэкапить машину, то с арендованными VPS всё не так просто. Veeam Agent for Linux позволяет из без проблем бэкапить и в случае необходимости восстанавливать локально.

Kopia

Примерно 3 года назад я рассказывал про хороший инструмент для бэкапа - Kopia. Это бесплатная кросс-платформенная система для бэкапов с управлением через веб интерфейс. С тех пор вышло много обновлений, продукт активно развивается и обрастает возможностями. Решил написать о нём ещё раз, чтобы напомнить и рассказать тем, кто не знаком с ним.

📌 Кратко перечислю основные возможности Kopia:

- Кросс-платформенная система как на уровне агентов, так и сервера. Вы можете развернуть сервер с веб интерфейсом как на Linux, так и Windows или macOS. И бэкапить туда все поддерживаемые системы.

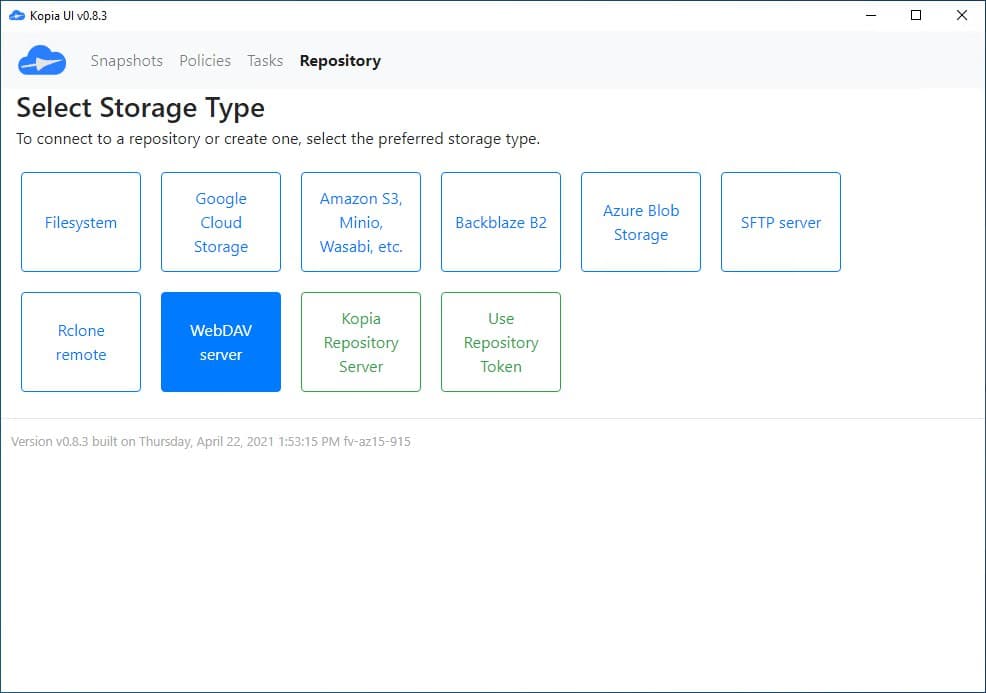

- Поддержка различных бэкендов для организации архива с бэкапами. Даже если чего-то не хватает, то в качестве транспорта может выступать rclone, который поддерживает вообще всё, что только можно.

- Есть в том числе поддержка CLI (консольного интерфейса), что позволяет очень гибко с помощью ключей задавать преднастройки для процесса архивирования.

- Очень гибкая система хранения и управления бэкапами с помощью политик.

- Веб интерфейс для настройки бэкапов и доступа к данным. При желании, можно всё делать через него. В консоль ходить не обязательно. Но при этом все настройки, сделанные в веб интерфейсе можно экспортировать в json конфиги и консольные ключи.

- Поддержка инкрементных бэкапов, дедупликации, сжатия.

- Есть возможность проводить регулярные проверки бэкапов на целостность.

- В последний релиз завезли поддержку Volume Shadow Copy Service (VSS) под Windows.

- Всё это написано на GO и работает быстро.

❗️Сразу отмечу, что Kopia делает бэкапы только на уровне файлов и каталогов. Сделать образ диска или бэкап всей системы разом с ней не получится.

У Kopia немного необычная архитектура и принцип работы. Сейчас кратко расскажу, как там всё устроено. Клиент и сервер по сути одно и то же. Это всё один бинарник. Поставить в Debian можно так:

# curl -s https://kopia.io/signing-key | gpg --dearmor -o /etc/apt/keyrings/kopia-keyring.gpg # echo "deb [signed-by=/etc/apt/keyrings/kopia-keyring.gpg] \ http://packages.kopia.io/apt/ stable main" | tee /etc/apt/sources.list.d/kopia.list # apt update # apt install kopia

Далее вы можете все конфиги подготовить заранее и запустить бинарник с нужными параметрами. Но так как мы используем этот продукт впервые, то запустим веб интерфейс и всё настроим там. А потом уже заберём готовые конфиги для других серверов.

# kopia server start --insecure --address="http://10.20.1.36:51515" --server-username="kopia" --server-password=kopia

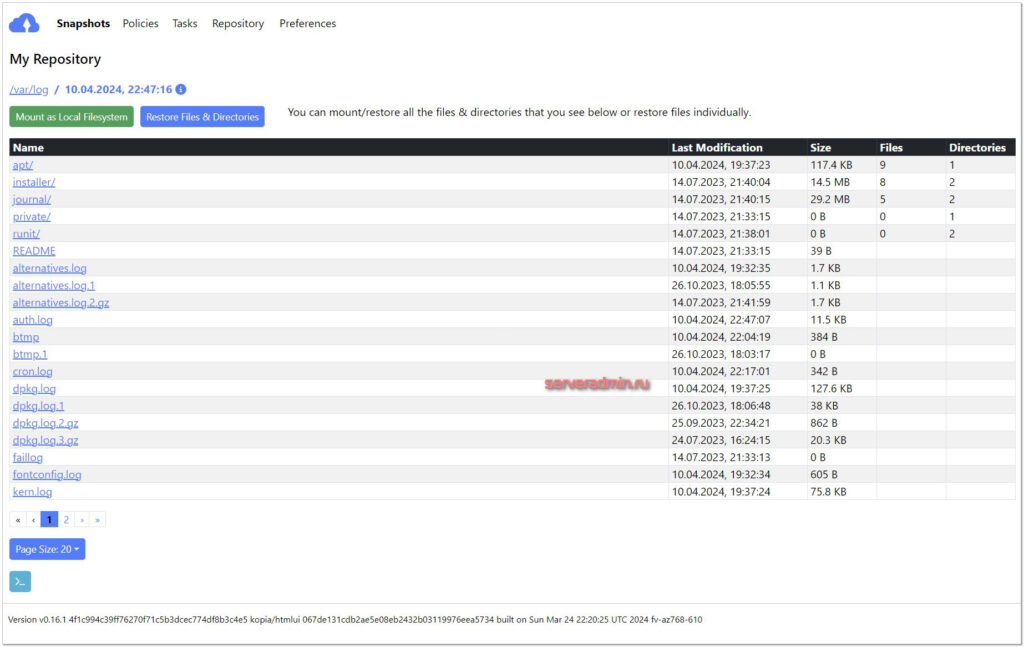

Запустили kopia в режиме веб интерфейса. Идём на http://10.20.1.36:51515 и логинимся под указанной учёткой. Сразу добавляем репозиторий для хранения бэкапов. Например, локальную директорию /mnt/backup. После этого в разделе Snapshots мы можем добавить любой локальный каталог в качестве источника бэкапа. И там же через веб интерфейс настроить параметры бэкапа и политики хранения. Они сохранятся в репозитории.

После того, как мы настроили репозиторий и параметры бэкапа, его конфиг сохранился в /root/.config/kopia/repository.config. Теперь мы можем просто запускать команду для бэкапа в консоли. Примерно так для директории /var/log:

# kopia snapshot create /var/log

Будет создан очередной снэпшот директории. Посмотреть его можно будет в том числе через веб интерфейс.

Теперь мы можем установить kopia на любую другую машину. Если мы захотим складывать её бэкапы на тот же сервер, где мы ранее настроили репозиторий, то на него они будут попадать уже по sftp. Для этого можно так же запустить на новой машине веб интерфейс и добавить репозиторий уже не локальный, а sftp и указать параметры подключения по ssh. И далее так же делать снепшоты либо через веб интерфейс, либо локальной командой, которую можно запускать через cron или systemd.

При описанной схеме, все клиенты имеют полный доступ к репозиторию с бэкапами. Это самая простая настройка. Чтобы доступ ограничивать через acl, можно поднять Repository Server и подключаться через него.

⇨ 🌐 Сайт / Обсуждение

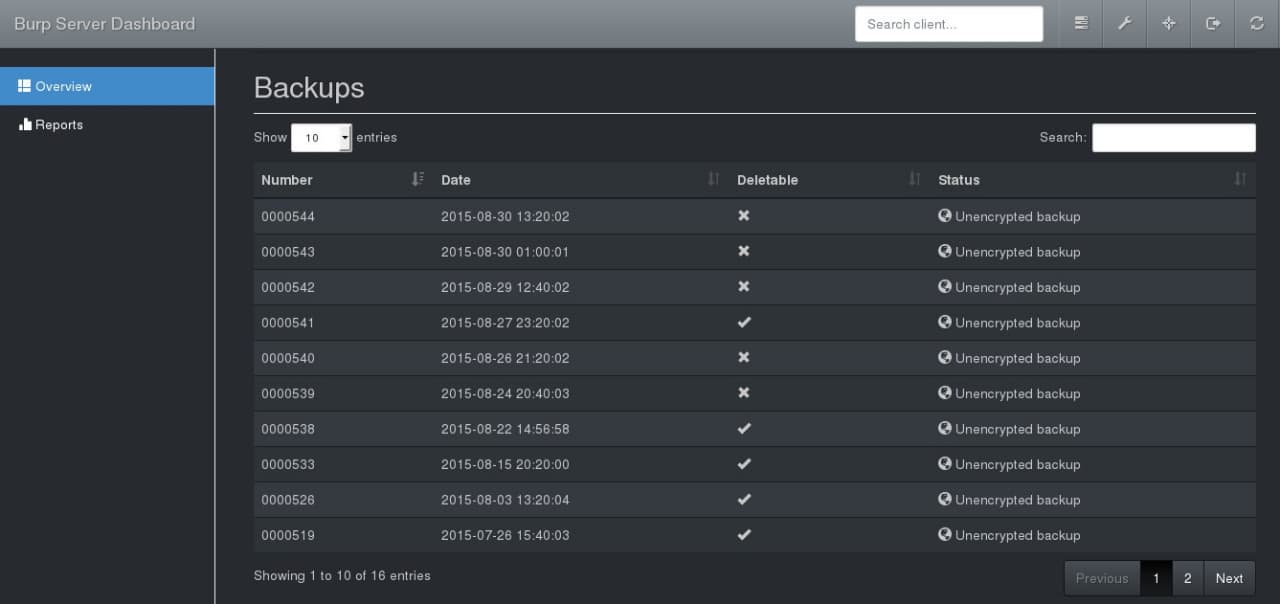

Burp

Автор на своём сайте целый раздел написал на тему того, зачем он начал разрабатывать Burp, если есть такая замечательная Bacula, которой он сам пользовался. Если кратко - Бакула слишком сложная для простых задач. Он решил написать что-то похожее, но значительно проще.

Burp написан на языке C с использованием librsync (значит синхронизирует файлы быстро) и имеет клиент-серверную архитектуру. Сервер ставится на linux, клиенты есть под linux, windows, mac. Разрабатывается активно уже в течении более чем 10-ти лет.

Burp поддерживает создание репозиториев для бэкапа, дедупликацию, шифрование, сжатие, планирование, оповещения и т.д. В общем, полноценная система бэкапа. Умеет выдавать свой статус в json, можно разворачивать с помощью ansible, есть готовые роли. Так что с молодёжностью все в порядке, несмотря на то, что проект достаточно старый.

Отдельный персонаж написал веб интерфейс для Burp. Живет тут - https://git.ziirish.me/ziirish/burp-ui.

Любопытная система бэкапа. Мне приглянулась в первую очередь тем, что она на базе rsync сделана, плюс файлы хранятся в открытом виде. По бэкапам можно тем же find лазить при желании, если они не зашифрованы.

⇨ 🌐 Сайт / Обсуждение

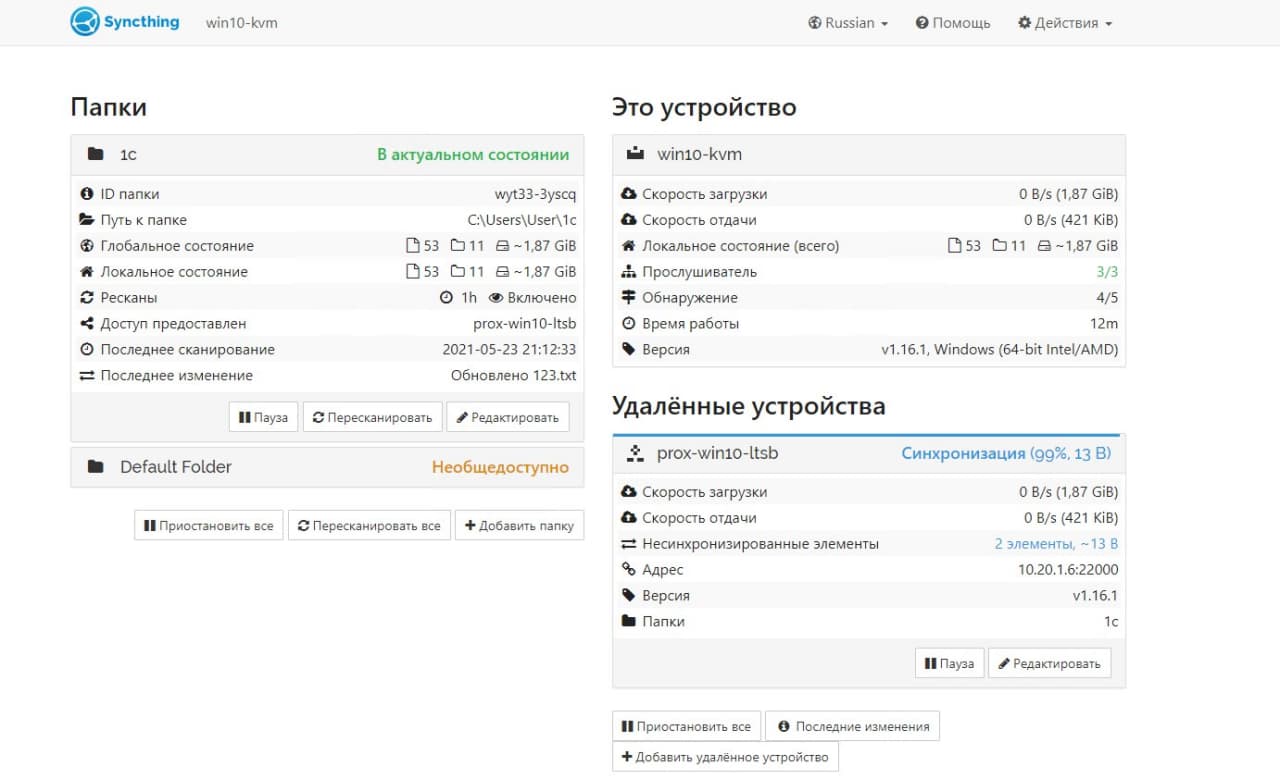

Syncthing

Syncthing работает по принципу торрент клиентов. В режиме реального времени синхронизируются данные всех клиентов, которые пожелали синхронизировать какую-то директорию. Клиенты есть под все популярные системы, в том числе на смартфонах.

Работает примерно так. Ставите клиент на какую-то систему и добавляете туда папку для синхронизации. Клиент автоматически связывается с публичными централизованными релеями или серверами-анонсерами. Их можно поднимать свои. Клиенту назначается уникальный id.

Далее такой же клиент ставится на другую систему. Он так же регистрируется в общей сети и получает свой id. Дальше на первом клиенте вы добавляете по id в доверенные системы второй и расшариваете для него папку. На втором клиенте вы видите, что вас добавили и добавляете это устройство в доверенные к себе. А так же принимаете от первого клиента директорию для синхронизации.

И всё! После этого начинается двухсторонняя синхронизация этой директории. Сюда же можно добавить еще несколько систем. Таким образом все они будут синхронизировать одну и ту же директорию. Если вы не хотите соединяться через публичные релеи, можете поднять свой. Любо просто настраивать подключения по ip.

Система мне понравилась, ставил на винду. Настроил и разобрался быстро. Интересный принцип синхронизации. Не знаю, насколько надежно и быстро будет работать. Подозреваю, что при большом количестве файлов могут быть проблемы, как и у всех программ подобного рода. Тысяч 500 файлов загрузить и все повиснет или будет куча конфликтов. Но для не сильно больших объемов и количества файлов по идее должно работать нормально. Можно так свои файлы между устройствами шарить.

⇨ 🌐 Сайт / Обсуждение

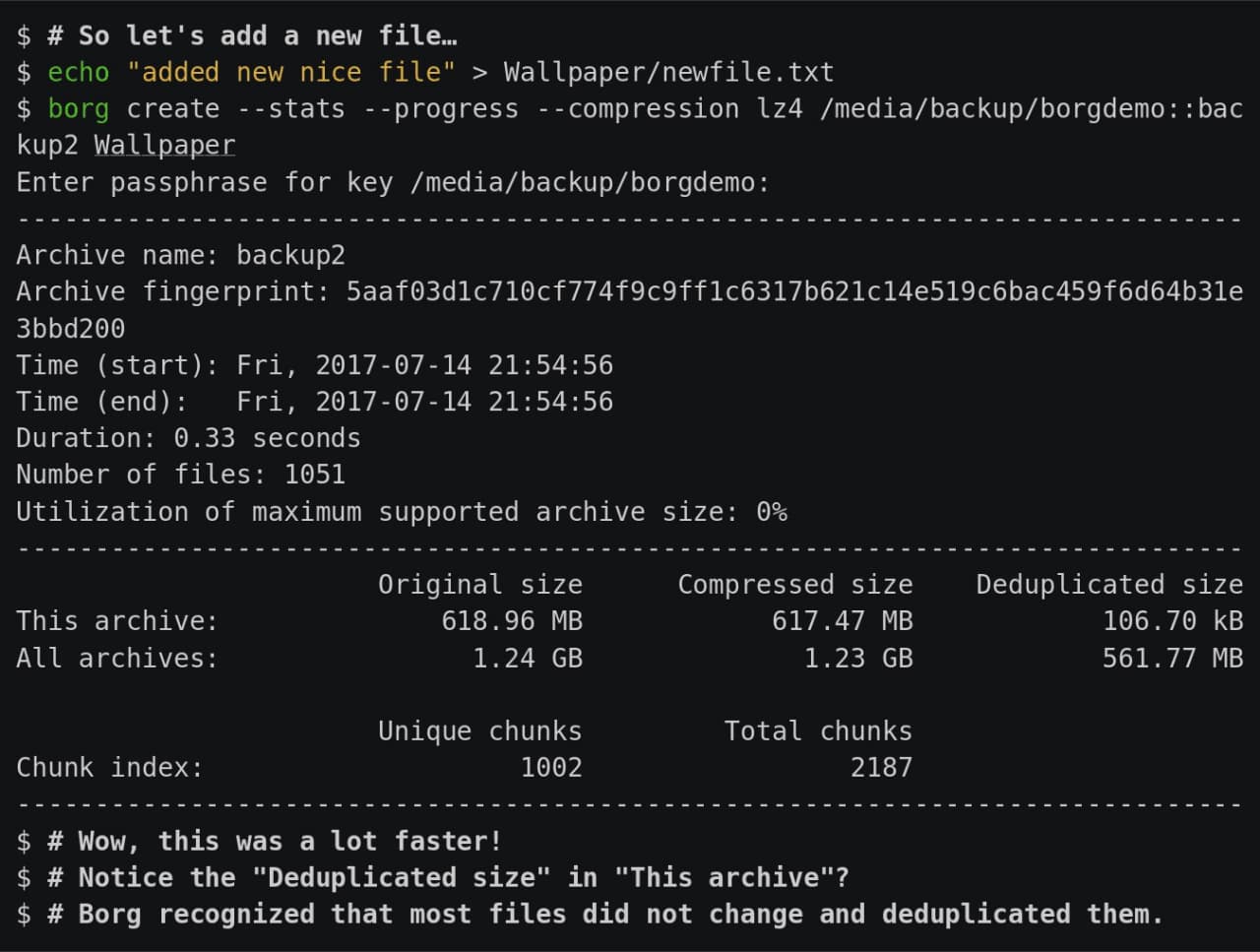

Borgbackup или Borg

Чем привлек конкретно Borg и почему обратил на него внимание:

- Простая установка и настройка. По сути это просто один бинарник. Ничего дополнительно, типа базы данных, ставить не надо. Работает на всех системах Linux, MacOS. Поддержки винды нет.

- Эффективная и честная дедупликация, ну и сжатие до кучи разными алгоритмами.

- Работает по ssh. Соответственно, не надо ничего настраивать на хостах, ставить агент и т.д. Ssh чаще всего есть везде.

- Гибкий в плане автоматизации с помощью скриптов. Отлично подходит для любителей костылей и велосипедов, как я.

Сам я по-прежнему бэкаплю все с помощью rsync и самописной обвязки в виде bash. Реализовано, все, что мне обычно требуется - полные, инкрементные бэкапы, мониторинг.

Хочется избавиться от своих велосипедов, но найти что-то, что на 100% меня устроило, не получается. Я внимательно посмотрел на Borg, попробовал. В целом, все круто и удобно. Дедупликация отлично работает, diff бэкапы делаются очень быстро.

Но всплывает одна особенность всех бинарных бэкапов с дедупликацией, типа borg. Допустим, у вас есть большой архив данных, ну скажем на 1-2 Тб с 500 000 файлов. Чтобы просто сделать листинг файлов в таком бэкапе уйдет очень много времени. Если же у меня обычный бэкап данных через rsync, я делаю это практически мгновенно.

И еще один минус конкретно Borg. Он сохраняет права файлов, когда вы делаете полный бэкап. Но потом, если вы восстановите отдельный файл, его права не будут восстановлены, так как они хранятся условно в полном бэкапе. Чтобы восстановить и права файлов, надо сделать полное восстановление. Где-то не не принципиально, а где-то создаст много неудобств.

Моё резюме такое. Borg отличный консольный инструмент для бэкапов с честной дедупликацией и сжатием. Очень хорошо экономит место на дисках. Но имеет описанные выше минусы. Если вам они не критичны, можно пользоваться. Я для себя в итоге решил не использовать его. Пока останусь с rsync.

Если вас реально заинтересовал Borg, то посмотреть, как он работает, можно тут - https://www.borgbackup.org/demo.html Сразу получите практически полное представление о его работе. Я начал с того, что посмотрел все 4 demo ролика.

⇨ 🌐 Сайт / Обсуждение

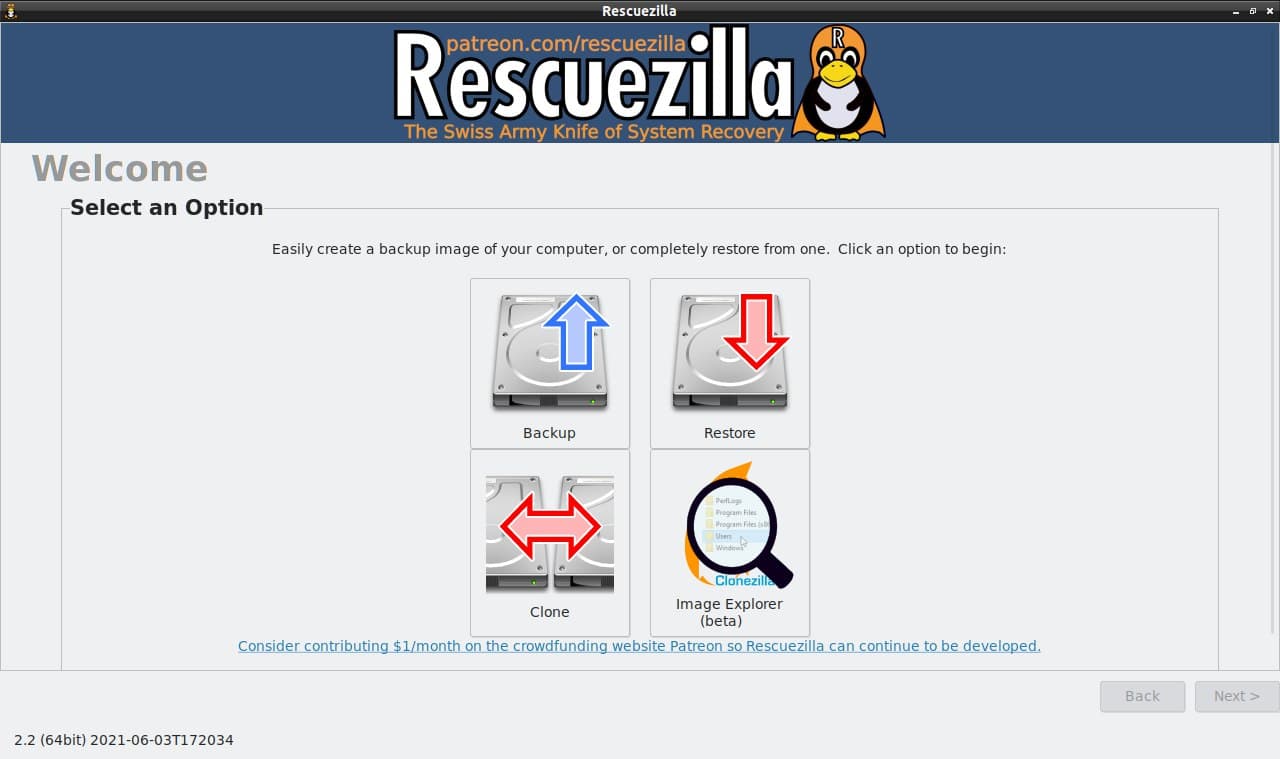

Clonezilla и Rescuezilla

Clonezilla это аналог коммерческих продуктов для снятия образов дисков и систем для бэкапа или переноса на другое железо, таких как Acronis True Image, Norton Ghost и т.д.

Она имеет консольный интерфейс для тру линуксоидов и любителей генту с арчем, а Rescuezilla более человеческий GUI для тех, кто привык тыкать мышкой.

Я сам неоднократно использовал Clonezilla для переноса системы с железа в виртуалку или между разными гипервизорами. Продукт хороший и известный, рекомендую, если еще не знакомы с ним.

Думаю, что в следующий раз, когда понадобится, предпочту GUI консоли. Так же одной из фишек Rescuezilla является то, что она может очень легко монтировать файлы резервных копий Clonezilla и получать к ним доступ.

⇨ https://rescuezilla.com

⇨ https://clonezilla.org

⇨ 🌐 Обсуждение / rescuezilla.com / clonezilla.org

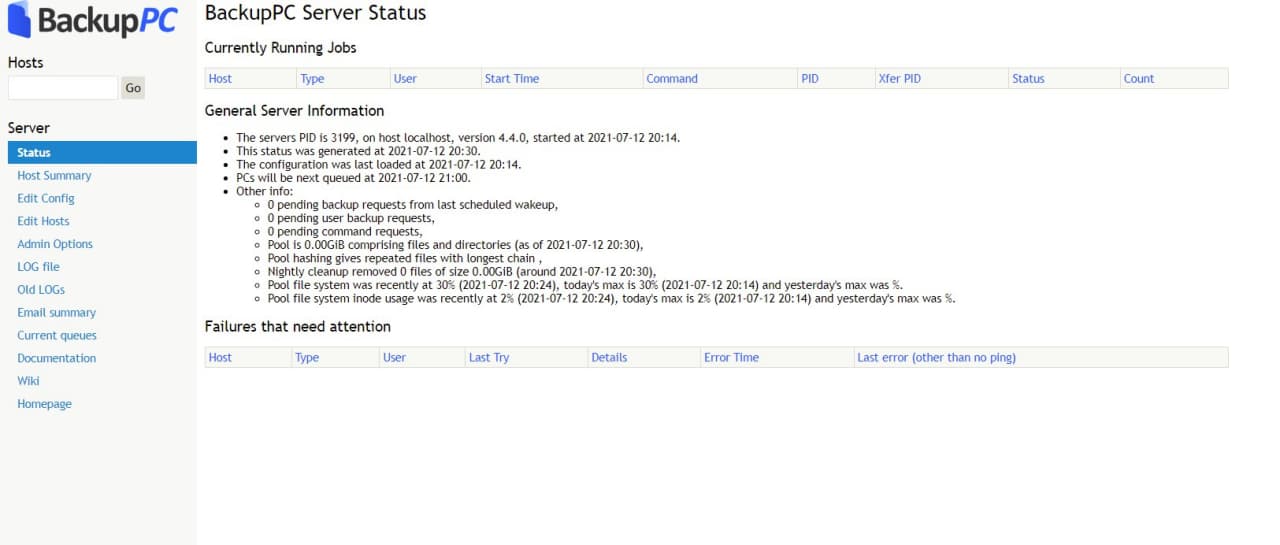

BackupPC

Основные особенности BackupPC следующие:

- Управление через встроенный веб интерфейс.

- Кроссплатформенный, написан на perl.

- Поддержка дедупликации и сжатия.

- Работает поверх ssh, в том числе с помощью rsync, агенты ставить не надо.

- Умеет сам работать по smb.

- В работе использует механизм жестких ссылок (hardlinks).

Поставить на Centos и попробовать можно из epel:

# dnf install epel-release # dnf config-manager --set-enabled powertools # dnf install backuppc

Вместе с backuppc прилетит apache с готовым конфигом. Надо будет только юзера добавить для авторизации. Подробная инструкция по установке есть тут. Я по ней поставил. А дальше полез в документацию и немного прифигел. Думал это небольшая утилитка, но по факту BackupPC достаточно крупная и зрелая система бэкапа, с которой надо разбираться.

Не сказать, что там что-то сложное. Плюс, всё делается через веб интерфейс. Вам надо раскидать по хостам ssh ключ, по которому BackupPC будет ходить по клиентам. Потом добавить хосты в систему, настроить задачи для бэкапа и потом поставить их в планировщик.

В целом, выглядит всё очень любопытно и полезно. Плюс, под капотом достаточно известные линуксовые утилиты. То есть никакой внутренней магии. Как я понял, эта система подойдет тем, кто не хочет связываться с Bacula/Bareos, но при этом уже вырос из самописных скриптов и нужна централизация и автоматизация.

⇨ 🌐 Исходники / Обсуждение

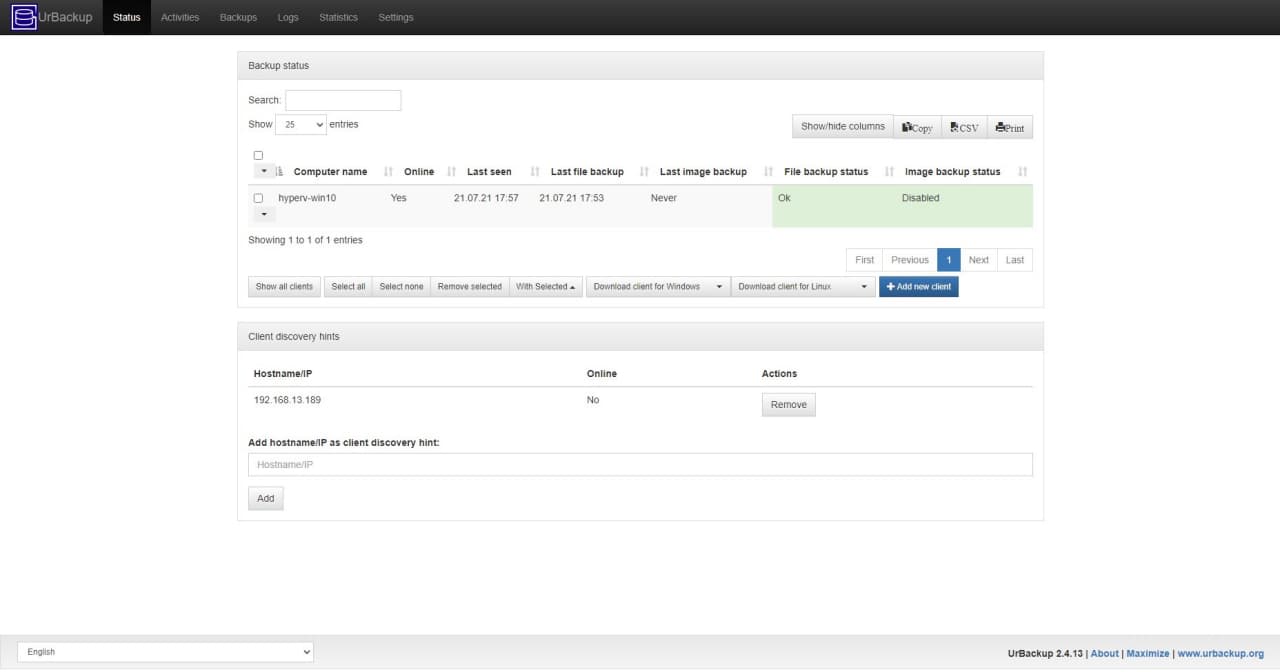

UrBackup

UrBackup - кроссплатформенная система бэкапа с управлением через встроенный веб интерфейс. Причем, что клиенты, что сервер могут быть подняты на разных системах, в том числе Windows и Linux.

Я для теста сервер поднял в Docker на Centos 8, а забэкапил с помощью клиента Windows систему. UrBackup позволяет делать резервные копии как системы целиком, так и отдельных директорий и файлов.

Это полноценная система резервного копирования. Она умеет разграничивать доступ по пользователям и интегрироваться с LDAP, рассылать оповещения о задачах, делать полные и инкрементные копии, поддерживает расписание и многое другое. То есть закрывает все базовые вопросы по бэкапу.

Попробовать систему проще простого. Как я уже сказал, запустил сервер в докере и сразу же зашёл через веб интерфейс. Команда на запуск:

# docker run -d --name urbackup-server-1 -v /mnt/backups:/backups -v /mnt/database:/var/urbackup -p 55413-55415:55413-55415 -p 35623:35623/udp uroni/urbackup-server

Интерфейс управления по адресу http://10.20.1.16:55414. Далее ставите на Windows клиента с помощью простого установщика и быстро там же настраиваете, что бэкапить. Потом возвращаетесь в веб интерфейс сервера и добавляете по ip адресу комп, куда клиент поставили.

И всё, сразу начинается бэкап с дефолтными настройками сервера. Можете заранее их посмотреть и поменять. Настраивается частота бэкапа, политика хранения и создания полных и инкрементных бэкапов и многое другое.

Есть русский язык как в клиенте, так и в сервере. По смыслу всё нормально переведено, но кое-где интерфейс кривоват: пробелов не хватает или разъезжается текст. В английской версии аккуратнее смотрится.

Система очень понравилась в первую очередь функционалом и простотой настройки. Особо красноглазить в консоли не надо. Все базовые потребности можно закрыть веб интерфейсом. По надежности и скорости работы ничего сказать не могу. Но судя по тому, как часто UrBackup рекомендуют, у него с этим всё в порядке.

Больше всего похоже на Kopia и BackupPC. Но на первый взгляд по функционалу, удобству и простоте превосходит их. Так что рекомендую.

⇨ 🌐 Сайт / Обсуждение

Butterfly Backup

Butterfly Backup - небольшая консольная обёртка над rsync, написанная на python. Идея её в том, что она использует основное преимущество rsync - скорость сравнения и копирования информации. А так же добавляет некоторую гибкость, которой изначально в rsync нет. То есть расширяет его функционал.

Butterfly Backup избавляет от необходимости писать собственную bash обвязку вокруг rsync для организации инкрементных или разностных бэкапов. Так же упрощает восстановление и просмотр содержимого бэкапов. Для удобства можно подготовить готовый конфиг.

Основные возможности:

- Поддерживаемые бэкапы: Full, Incremental, Differential, Mirror.

- Использование центрального сервера для хранения бэкапов разных клиентов.

- Детальный просмотр содержимого отдельных бэкапов.

- Бэкап всей системы, а так же ее восстановление на другое железо или VM.

- Принцип снятия данных agent-less, по протоколу rsync или ssh.

Для работы BB нужен Python3. Далее достаточно скопировать репозиторий и запустить скрипт установки:

# git clone https://github.com/MatteoGuadrini/Butterfly-Backup.git # cd Butterfly-Backup # sudo python3 setup.py

После этого копируем rsa ключи, которые предварительно создали, на удаленный host, чтобы иметь к нему доступ:

# bb config --deploy host1

Дальше запускаем простой бэкап:

# bb backup --computer host1 --destination /mnt/backup --data System --type Unix

У bb есть преднастройки для типовых бэкапов трёх типов систем - Unix, Windows, MacOS. Если указать после ключа data тип данных и далее тип системы, то будет забэкаплено всё, что относится к этому типу. В моем примере это системные директории.

В документации можно посмотреть все основные возможности и ключи для бэкапа и восстановления.

⇨ Сайт / Обсуждение

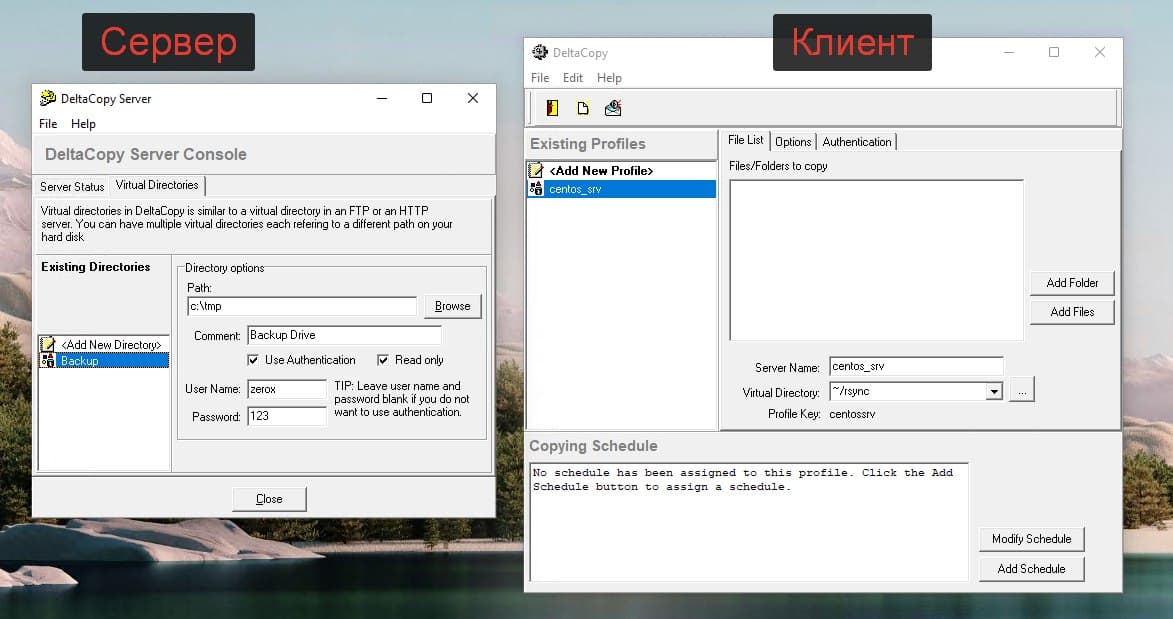

DeltaCopy

Если вы любите rsync так же, как и я, и при этом хотите с его помощью бэкапить windows машины, то помочь вам в этом может программа DeltaCopy. Эта программа стала для меня настоящим открытием. Раньше я уже писал про rsync под windows. Там я описывал старую программу, о которой практически не осталось упоминаний в интернете. Нет сайта программы, нет обновлений. На текущий момент она брошена.

DeltaCopy вполне себе живая. Есть сайт, где можно скачать последнюю версию дистрибутива, есть исходники. Да и в целом мне эта программа понравилась за свою простоту и функциональность. Она состоит из двух независимых частей - клиента и сервера.

Клиент вам нужен будет, если вы хотите забирать по расписанию данные с другого Rsync сервера. Мне обычно это не нужно. Сервера чаще всего под Linux и именно с них хочется забирать данные Windows машин. Для этого используется серверная часть. У неё минимум настроек и все через интерфейс программы.

Для того, чтобы начать забирать данные с Windows через Rsync надо в серверной части настроить директорию с источником файлов. Если нужна встроенная авторизация, добавить пользователя и пароль. DeltaCopy сформирует простейший конфиг rsync:

use chroot = false strict modes = false [Backup] path = /cygdrive/c/tmp comment = Backup Drive read only = true auth users = zerox secrets file = /cygdrive/c/DeltaCopy/secrets/Backup.secret

Далее запускаем DeltaCopy как службу и не забываем настроить фаерволл. Надо открыть стандартный порт rsync - tcp 873. Перемещаемся на Linux сервер и забираем оттуда данные:

# rsync -avz zerox@10.20.1.57::Backup /mnt/backup

И всё. Работает четко и просто. Я попробовал, буду теперь использовать DeltaCopy для rsync на Windows.

⇨ 🌐 Сайт / Обсуждение

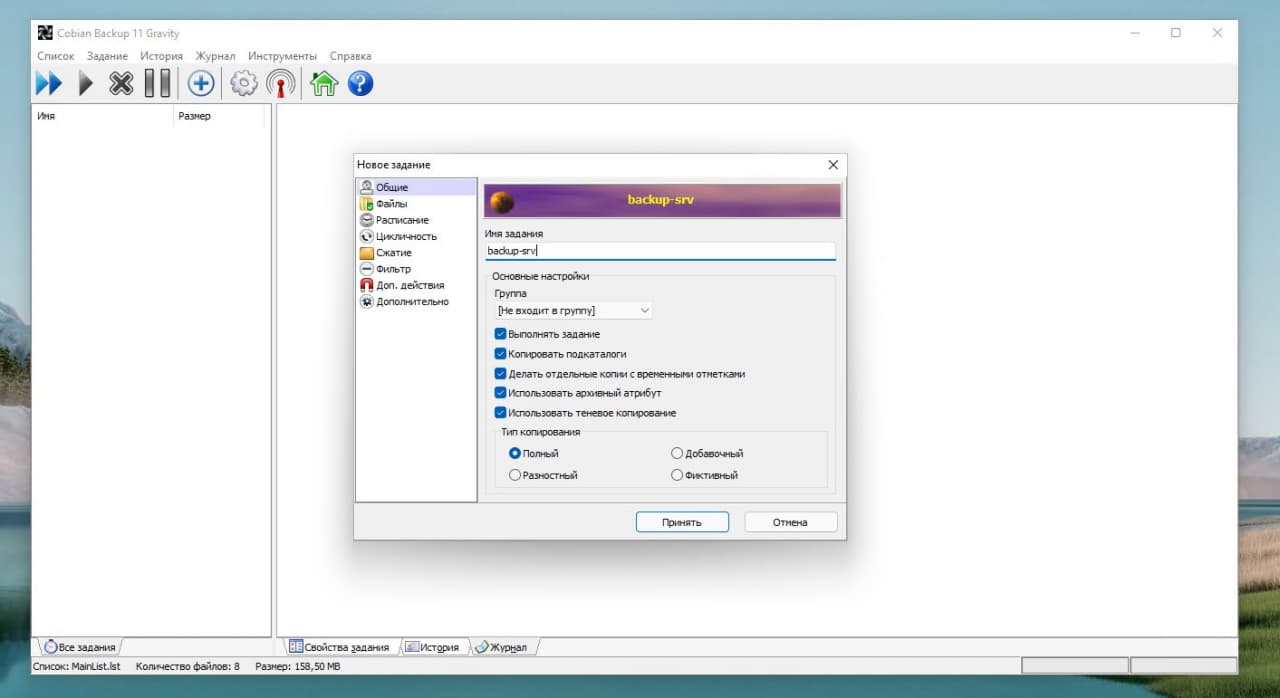

Cobian Backup

Существует очень старая и известная программа для бэкапа систем под управлением Windows - Cobian Backup. Она полностью бесплатна и весьма функциональна для нулевой стоимости. Я проверил её работу на Windows 11. Несмотря на то, что программа старая, нормально работает даже на самой последней версии винды. Надо только .Net Framework 3.5 поставить.

Основные возможности программы:

- Умеет работать как служба, использует расписание.

- Использует shadow copy для создания бэкапов.

- Поддерживает различные схемы бэкапа: полный, инкрементный, разностный.

- Умеет сжимать архивы с помощью zip или 7zip, а также шифровать их.

- Может запускать скрипты перед или после бэкапа.

- Поддерживает управление через командную строку.

- Нормальный русский язык в интерфейсе.

- Подробный лог выполнения задач.

В общем, для бесплатной программы она очень удобна и функциональна. Бэкапить может только локально, либо на сетевые диски. А также на ftp. Не знаю, кто еще ftp использует в наши дни. Тем не менее, возможность есть. Если сравнивать с тем же бесплатным Veeam Agent for Microsoft Windows FREE, то Cobian Backup более функциональна.

Настройки программы простые и тривиальные. Разбираться много не придётся, тем более читать какую-то документацию (кто её вообще читает?). После установки сразу настроите бэкап и запустите.

⇨ 🌐 Сайт / Обсуждение

❗️Использовать на свой страх и риск, так как на странице с программой после 2022 года присутствуют странные призывы.

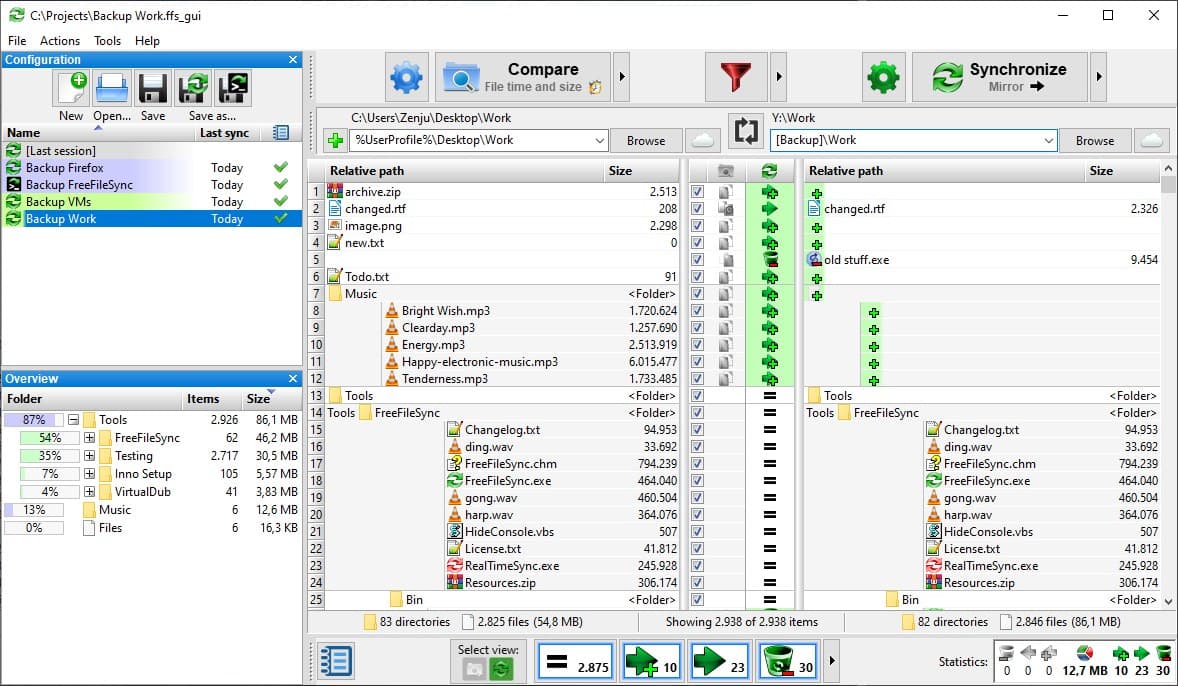

FreeFileSync

Хочу порекомендовать вам очень удобную и функциональную программу для синхронизации файлов - FreeFileSync. По сути это аналог известной платной программы GoodSync, которую многие знают, но она платная. Работает FreeFileSync примерно так же, только полностью бесплатна, исходный код открыт.

Принцип работы FreeFileSync следующий. Выбираете в левой части окна программы одну директорию, в правой части другую и синхронизируете их. Можно настроить правила синхронизации и интервал. В качестве одной из сторон синхронизации может выступать не только локальная или сетевая директория, а облачный сервис google drive, sftp и ftp. То есть можно с Windows серверов лить данные на Linux по sftp.

Программа поддерживает консольный режим работы, исключения, работу в качестве службы, автозапуск по расписанию и многое другое. Это полноценный, многофункциональный продукт с регулярными обновлениями. Работает под Windows, Linux, MacOS.

⇨ 🌐 Сайт / Обсуждение / Видеообзор

Rclone

Rclone — программа старая, удобная, популярная. Она есть под все известные ОС: Windows, macOS, Linux, FreeBSD, NetBSD, OpenBSD, Plan9, Solaris.

Я использую её исключительно в консоли Linux. Она есть в базовых репозиториях, так что ставится стандартно:

# apt install rclone # dnf install rclone

Самую свежую версию можно поставить вот так:

# curl https://rclone.org/install.sh | bash

Далее рисуем простой конфиг в файле ~/.config/rclone/rclone.conf:

[selectel] type = swift user = 79167_username key = uO6GdPZ97 auth = https://api.selcdn.ru/v3 tenant = 79167_username auth_version = 3 endpoint_type = public

Это пример для S3 хранилища от Selectel. Все учётные данные получите в ЛК. Я давно им пользуюсь. Когда выбирал, он был самым дешёвым. Сейчас не знаю как, не сравнивал. Для объёмов до 100 Гб там цены небольшие. За этот объём заплатите рублей 300 примерно (стандартное хранилище, холодное ещё дешевле), так что не критично. Рекомендую дублировать бэкапы сайтов, магазинов в S3. У меня это всегда второе, холодное хранилище, куда уезжают полные архивы с определённой периодичностью.

Бэкап директории /mnt/backup/day делается следующим образом:

# /usr/bin/rclone copy /mnt/backup/day selectel:websrv-day

Я обычно делаю 3 контейнера: day, week, month с настройкой хранения копий 7, 30 дней и бессрочно. Контейнер с месячными архивами чищу вручную время от времени, либо вообще не чищу. А первые два очищаются самостоятельно в соответствии со своими настройками. Следить самому за этим не надо. Если у вас это будет единственное хранилище, то очистку лучше настроить не по времени, а по количеству файлов в контейнере. Иначе если не уследите за бэкапами и они по какой-то причине не будут выполняться, через какое-то время все старые будут удалены, а новые не приедут.

В S3 от Selectel данные заходят очень быстро. Скорость до Гигабита в секунду. Скачивать редко приходится, так что не знаю, какая там реальная скорость, но проблем никогда не было. Думаю тоже что-то в районе гигабита, обычно сам интернет медленнее, куда грузить будете. Можно через панель управления зайти и открыть веб доступ к какому-нибудь файлу, сделать одноразовую ссылку. Также доступ к файлам есть через личный кабинет напрямую в браузере, либо по FTP. Я для визуального контроля и загрузки файлов обычно по FTP захожу.

⇨ 🌐 Сайт / Обсуждение

Bup

Я узнал и попробовал программу bup, про которую раньше не слышал. Она мне понравилась и показалась очень полезной, поэтому решил написать и поделиться с вами. Bup использует тот же алгоритм, что и rsync для деления файлов на фрагменты и проверки контрольных сумм, так что производительность у него на хорошем уровне.

Особенность bup в том, что она использует гитовский формат хранения данных в репозиториях. При этом не возникает проблем с огромным числом файлов и большим объёмом. Плюс такого хранения в том, что легко создаются инкрементные копии, причём данные могут быть совсем разные с разных хостов. Но если они одинаковые, то станут частью инкрементной копии. Это хорошо экономит дисковое пространство.

Bup умеет делать как локальные бэкапы, так и ходить за ними на удалённые серверы по SSH. Есть простенький встроенный веб интерфейс. Всё управление через консоль. Это в первую очередь консольный инструмент для самостоятельного велосипедостроения. Показываю, как его установить на Debian.

# git clone https://github.com/bup/bup # cd bup # git checkout 0.33 # apt-get build-dep bup # apt install python3-pip # pip install tornado # make # make install

Теперь надо выполнить инициализацию репозитория. По умолчанию, он будет в ~/.bup. Задать его можно через переменную окружения BUP_DIR. Добавим её сразу в .bashrc и применим изменения:

export BUP_DIR=/mnt/backup

# source ~./bashrc

Инициализируем репозиторий:

# bup init

Создаём индекс бэкапа. Для примера возьму директорию /etc на сервере:

# bup index /etc

Делаем бэкап, назвав его etc с помощью параметра -n:

# bup save -n local-etc /etc

Посмотреть список репозиториев, файлов или бэкапов можно вот так:

# bup ls # bup ls local-etc # bup ls local-etc/2023-01-31-190941

Бэкап удалённой машины делается примерно так:

# bup index /etc # bup save -r SERVER -n backupname /etc

Доступ к серверу надо настроить по ключам.

Восстановление данных:

# bup restore -C ./dest local-etc/latest/etc

Восстановили директорию /etc с ветки latest бэкапа local-etc в директорию /.dest. Соответственно, выбирая разные ветки, вы восстанавливаете данные с того или иного инкрементного бэкапа.

Очень необычная для бэкапов, но при этом весьма удобная схема хранения и работы с данными, точно так же, как с обычными git репозиториями.

У bup есть простенький веб интерфейс, через который можно посмотреть и скачать файлы. По умолчанию он запускается на localhost, поэтому явно указываю интерфейс и порт:

# bup web 172.25.84.75:8080

Если кто-то пользуется bup, поделитесь впечатлением. Программа старая и известная, но я про неё ранее не слышал и не пользовался.

⇨ 🌐 Сайт / Обсуждение

ReaR

ReaR (Relax and Recover) есть в стандартных репозиториях популярных дистрибутивов, в том числе Debian. Ставится с некоторыми зависимостями, которые понадобятся по ходу дела:

# apt install rear genisoimage syslinux nfs-common

С помощью ReaR можно сделать бэкап как железного сервера, так и виртуальной машины. Во время бэкапа создаётся загрузочный ISO диск и общий tar архив с данными. Для восстановления достаточно загрузиться с ISO образа и подцепить архив с данными.

Подобных программ немало, но принцип действия у них может быть разный. ReaR не только создаёт полную копию данных, но и учитывает многие нюансы при восстановлении. Я решил сразу же проверить его в реальной работе для переноса виртуальной машины с Proxmox на HyperV. Здесь полная копия системы не всегда поднимется без дополнительных действий.

Для хранения архива я выбрал NFS шару. Можно использовать SMB, RSYNC или локальное хранение на внешнем USB устройстве (диск, флешка). Нарисовал простенький конфиг /etc/rear/local.conf:

OUTPUT=ISO

OUTPUT_URL=nfs://192.168.13.50/volume2/NonRaid

BACKUP=NETFS

BACKUP_URL=nfs://192.168.13.50/volume2/NonRaid

BACKUP_PROG_EXCLUDE=("${BACKUP_PROG_EXCLUDE[@]}" '/media' '/var/crash')

Запустил бэкап:

# rear -v -d mkbackup

Дождался его окончания и проверил, что получилось на выходе:

# ls -h backup.log backup.tar.gz README rear-debian11-vm.iso rear-debian11-vm.log VERSION

Забрал rear-debian11-vm.iso и скопировал на HyperV. Создал там виртулаку, подключил ISO, загрузился с него, выбрал восстановление. Убедился заранее, что на NFS сервер есть доступ с этого гипервизора.

Дождался загрузки временной системы, запустил там:

# rear -v -d recover

Пошёл процесс автоматического восстановления. Я наблюдал за консолью, чтобы понять, как происходит восстановление. Программа восстанавливает разбивку дисков, создаёт LVM тома, файловые системы. То есть это не посекторное бездумное восстановление. После создания файловых систем пошла распаковка архива, затем генерация initramfs и в завершении установка GRUB.

Когда всё завершилось, перезагрузил систему и загрузился с жёсткого диска. Система загрузилась без ошибок и каких-либо действий с моей стороны. Хотя из-за разности гипервизоров, некоторые вещи были другими. Например, на Proxmox сетевой интерфейс был ens18, а на HyperV — eth0. Во время восстановления это было учтено, сетевые настройки были перенесены.

ReaR очень удобная программа. Раньше для переноса системы я рекомендовал либо Clonezilla, либо Veeam agent for Linux FREE. Но у них есть существенные минусы. Для первого нужно останавливать машину и делать полный клон системы. Если она большая, то это занимает много времени. Для Veeam надо перезагружать ОС после установки. Он там довольно сильно в систему врезается со своим драйвером или модулем ядра. Не помню уже точно, как он работает.

С ReaR ничего этого делать не надо. Можно железный сервер забэкапить и перенести без остановки и установки каких-то дополнительных компонентов. Достаточно поставить сам пакет с rear, nfs клиент, если нужен для бэкапа, и пару пакетов для создания iso образа: genisoimage syslinux, которые часто уже есть в базовой системе. Перезагрузки системы не нужны.

Берите на вооружение, расслабляйтесь (relax) и восстанавливайте (recover) системы. Данный инструмент используют OpenStack и Red Hat OpenStack Platform для встроенного бэкапа и восстановления систем.

⇨ 🌐 Сайт / Обсуждение

Restic

В поле моего зрения попала полезная консольная утилита restic, решил её посмотреть и поделиться информацией с вами, так как она показалась мне заслуживающей внимание.

В первую очередь это open source проект и весьма популярный. Для установки достаточно скачать бинарник из репозитория. Он написан на Go. На каких-то системах, например Debian, он есть в базовых репах. Основные возможности:

- все данные шифруются AES256, сам ключ шифруется паролем;

- нет деления на типы бэкапов: полные, инкрементные, дифференциальные, вместо этого используются снепшоты, соответственно работает дедупликация;

- различные хранилища для архивируемых данных: локальная директория, sftp, S3, HTTP REST server, OpenStack Swift, BackBlaze B2, Microsoft Azure Blob Storage, Google Cloud Storage;

- помимо прямого подключения к хранилищам, есть поддержка rclone;

- встроенная проверка целостности данных.

Restic режет данные на блоки настраиваемой длины, блоки собираются в паки. Паки хранят в себе файлы и метаданные, либо ссылки на другие блоки. Всё это выстраивается в деревья. Таким образом работают снепшоты и экономится место под бэкапы.

Покажу пример, как с помощью restic делаются бэкапы. Сначала инициализируется локальный репозиторий:

# restic init -r /mnt/backup

В этот момент будет сгенерирован ключ для шифрования и создана структура каталогов репозитория. Пример для инициализации репозитория по sftp:

restic init -r sftp:user@host:/mnt/backup

Бэкапим:

restic -r sftp:user@host:/mnt/backup backup /data

Смотрим список внепшотов в репозитории:

restic -r sftp:user@host:/mnt/backup snaphots

Смотрим список файлов в снепшоте:

restic -r sftp:user@host:/mnt/backup ls -l latest

Восстанавливаем файлы:

restic -r sftp:user@host:/mnt/backup restore latest --target=/restore/

Для всех операций поддерживаются списки include или exclude. Есть команды для быстрого сравнения снепшотов.

Думаю, вы получили представление, как всё это работает. Утилита консольная и хорошо подойдёт для скриптов. Авторы говорят, что Restic очень быстро работает. Я тестов не проводил. Из неудобств отметил то, что Restic надо ставить на сам хост, где лежат данные. Из документации я не понял, как с одного сервера с Restic забирать данные по ssh с других серверов.

Мне Restic сильно напомнил Borg. Подозреваю, что проблемы у него будут те же. Например, как будет выглядеть листинг снепшота, где хранится 500 тысяч файлов? Но в целом выглядит интересно. Основная фишка - снепшоты и дедупликация из коробки и бесплатно. Есть хорошая документация с практическими примерами.

Утилита подойдёт как для разовых бэкапов небольшой инфраструктуры, так и для централизованного хранения архивных копий за счёт того, что легко интегрируется, распространяется и мониторится. Про мониторинг как раз хотел дополнить.

Для Prometheus есть готовый экспортёр метрик — restic-exporter. Указываете репозиторий, пароль к нему и получаете на выходе полезные метрики: статус проверок, количество снэпшотов, время последнего бэкапа, кол-во файлов в бэкапе, их размер и т.д. А бонусом идёт дашборд для Grafana.

Zabbix тоже имеет готовый шаблон для мониторинга за бэкапами, сделанными Restic. Его написали не разработчики, так как он в отдельном репозитории community-templates, но, тем не менее, они за ним следят и актуализируют к свежим версиям. Мониторинг работает через прокладку resticprofile, которая формирует конфигурационные файлы для бэкапов и умеет сохранять результаты работы в json файл.

Есть ещё один вариант для Zabbix — шаблон, который анализирует стандартный вывод от команды на бэкап или проверку архива. Для этого вывод нужно сохранять в лог файл, а потом скриптом его анализировать и отправлять результат через zabbix_sender. В указанном репозитории есть все примеры — шаблон и скрипты.

Вообще, решение с Prometheus выглядит более целостным, простым и удобным. Если бы мне сейчас нужно было мониторить бэкапы Restic, я бы взял именно его. А если всё же нужен Zabbix, то распарсил бы промовский экспортер. Там буквально, запускаем контейнер с restic-exporter и смотрим метрики:

# docker run -d \ --name=restic-exporter \ -v /mnt/backup:/data -e TZ=Europe/Moscow \ -e RESTIC_REPO_URL=/data \ -e RESTIC_REPO_PASSWORD=123 \ -e REFRESH_INTERVAL=60 \ -p 8001:8001 \ --restart unless-stopped \ ngosang/restic-exporter

# curl http://localhost:8001

Очень просто и удобно.

⇨ 🌐 Сайт / Обсуждение

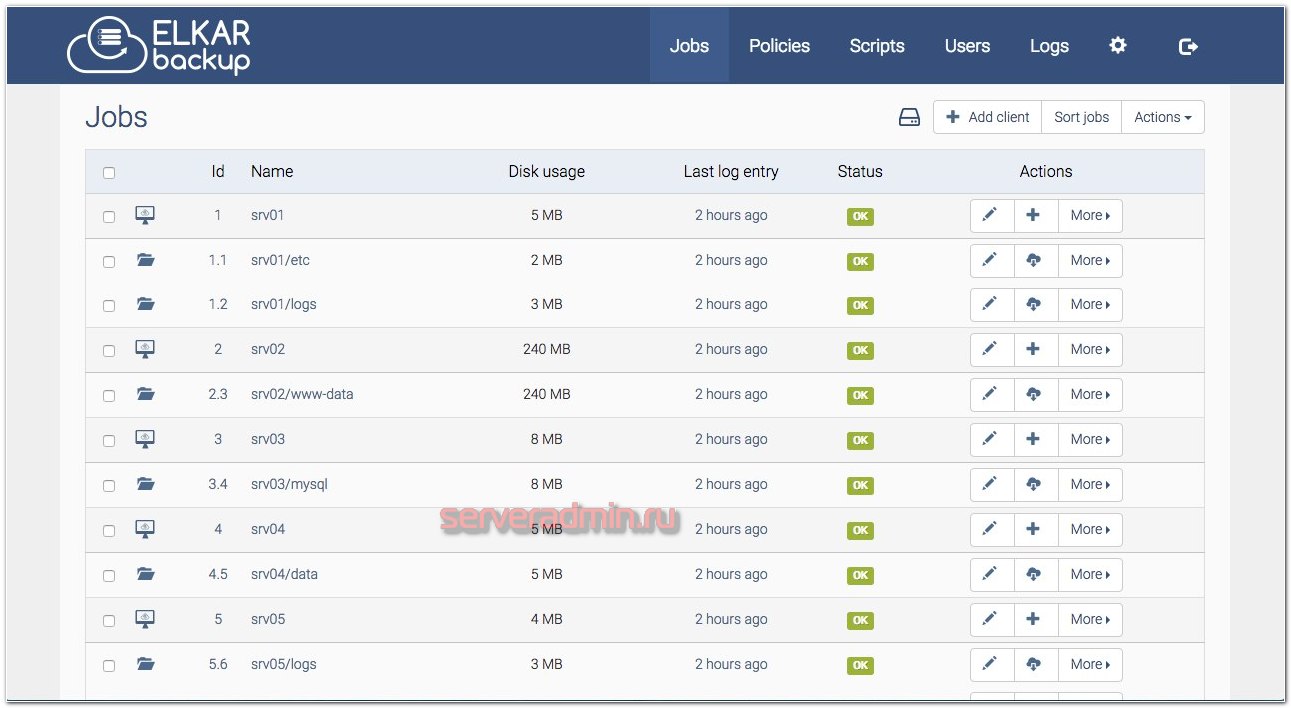

ElkarBackup

Потестировал очень любопытную программу для бэкапов - ElkarBackup.

Под капотом там RSnapshot, Rsync, Symfony на PHP. То есть это Web приложение на базе Симфонии и Rsync. По сути это просто веб интерфейс к rsync, которым удобно пользоваться. С его помощью можно добавлять хосты, создавать для них задания, планировать их выполнение, смотреть логи.

Я запустил всё это дело в докере. На хабе представлен готовый docker-compose.yml, но у меня с ним не завелось. Немного подредактировал. Вот рабочий вариант:

version: '3.9' services: elkarbackup: image: elkarbackup/elkarbackup:latest volumes: - backups:/app/backups - uploads:/app/uploads - sshkeys:/app/.ssh environment: SYMFONY__DATABASE__PASSWORD: "your-password-here" EB_CRON: "enabled" ports: - 8000:80 db: image: mysql:5.7.22 volumes: - db:/var/lib/mysql environment: MYSQL_ROOT_PASSWORD: "your-password-here" volumes: db: backups: uploads: sshkeys:

Volumes не вынесены из контейнеров, так что это установка чисто для теста. В прод я бы ставил из пакетов, благо они есть под все популярные системы и настраивается всё очень просто по документации. Контейнеры тут только для теста нужны.

После запуска можно идти в веб интерфейс http://192.168.13.123:8000/ и добавлять нового клиента. В качестве URL укажите подключение по SSH, типа такого: root@192.168.13.177

Для клиента создаёте задание, указывая директорию, которую будете бэкапить. Тут же можно расписание настроить, уведомления включить и т.д. После этого надо забрать с сервера публичный ключ для подключения по ssh. Проще всего его скопировать по ссылке: http://192.168.13.123:8000/config/publickey/get

Публичный ключ надо добавить на целевой сервер, которого добавили как клиента. После этого можно запускать задание с бэкапом. Посмотреть результат работы можно в логах. Если всё в порядке, то файлы приедут на сервер в директорию контейнера /app/backups. Доступ к ним можно получить через веб интерфейс.

Работает всё просто и удобно. Мне понравилось. Рекомендую попробовать, если ищите что-то похожее. Интерфейс простой и лакончиный, работает быстро. Не заметил каких-то проблем или глюков. Насчёт того, как эта штуковина переваривает десятки и сотни тысяч файлов, не знаю. Подозреваю, что могут быть проблемы. Но в такие архивы лазить через веб интерфейс не стоит, достаточно заданиями управлять.

⇨ 🌐 Сайт / Обсуждение

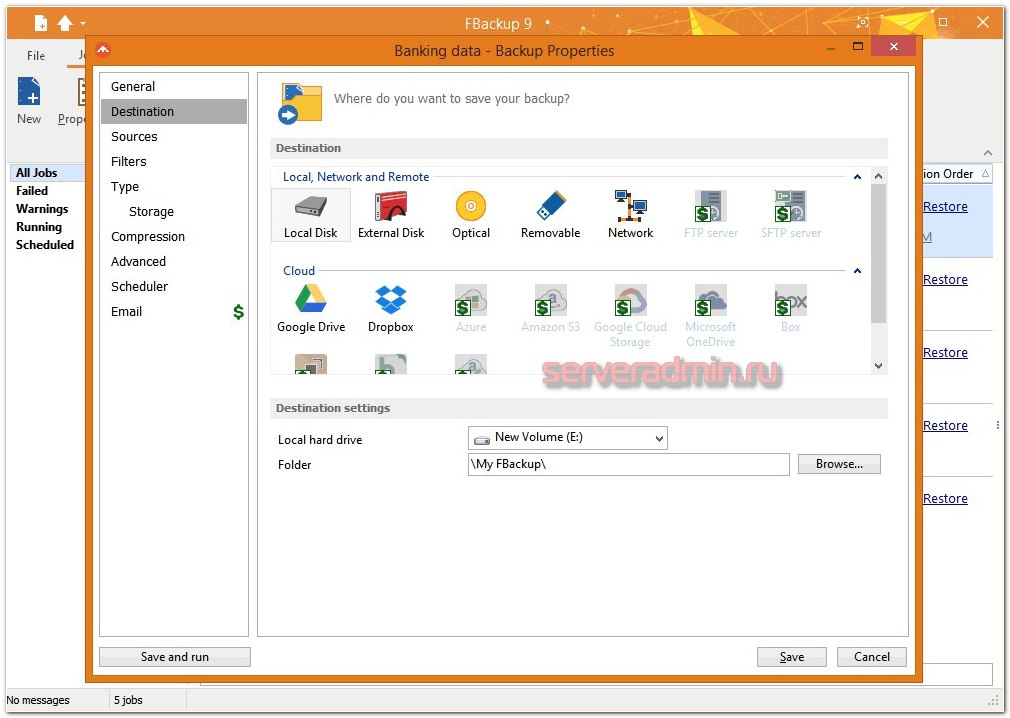

FBackup

FBackup - бесплатная программа для резервного копирования. Это достаточно известная старая программа для резервного копирования под Windows. У нее простой и дружелюбный интерфейс. Чтобы быстро настроить бэкап, не придется сильно заморачиваться. При этом она бесплатна в том числе и для коммерческого использования.

На выходе в бэкапе получаются сырые файлы, либо запакованные в zip архив. То есть никакого отдельного формата и лишних проблем во время восстановления. Просто берете свои файлы в исходном виде.

Если сравнивать с тем же Veeam Agent for Microsoft Windows FREE в рамках бэкапа не всей системы а отдельных каталогов, то FBackup будет более функционален, плюс файлы в сыром виде. Это как плюс, так и минус (меньше возможностей инкрементных копий). В общем, все зависит от того, что вам нужно на выходе.

⇨ 🌐 Сайт / Обсуждение

AOMEI Backupper Standard

Расскажу про одну старую и известную бесплатную программу для бэкапов под Windows – AOMEI Backupper Standard. Давно у меня в закладках лежит. Регулярно вижу про неё упоминания в комментариях и некоторых чатах. Это Freeware версия коммерческой программы. При этом у неё даже в бесплатной редакции хорошие возможности, которых для многих будет достаточно.

📌 Основные возможности Freeware версии AOMEI Backupper Standard:

- Бэкап на уровне файлов, разделов, дисков, всей системы.

- Типы бэкапов: полный, инкрементный, посекторный.

- Умеет бэкапить на локальный или внешний USB диск, сетевую папку (только по SMB)

- Синхронизация каталогов.

- Восстановление системы с использованием загрузочного ISO на базе WinPE или Linux. Причём Linux версия работает без UEFI, на обычном BIOS.

- Клонирование разделов и дисков, в том числе посекторное.

- Уведомления по email.

- Работа только на десктопных версиях Windows, серверные не поддерживаются.

Я установил и попробовал эту программу. В целом всё работает очень просто. Сделал бэкап на сетевую папку, создал загрузочный диск, закинул его на гипервизор, загрузился с него и сделал восстановление с сетевого диска. Попробовал диск и на WinPE, и на Linux. Последний образ весит всего 45 МБ.

Но могу сразу сказать, что у неё есть очень похожий бесплатный аналог – Hasleo Backup Suite Free, который лично мне понравился больше. В первую очередь тем, что там в интерфейсе нет опций с пометкой Pro, за которые надо платить.

При этом стоит отметить, что у AOMEI Backupper чуть больше возможностей. Из тех, что заметил я, это:

- Выбор загрузочного диска на базе Linux или WinPE.

- Возможность интегрировать в загрузочный диск на базе WinPE необходимые драйвера.

- Функциональность по синхронизации каталогов, в том числе по расписанию.

Последняя возможность довольно полезная и может быть актуальна. Эта же функциональность есть у бесплатной программы FreeFileSync, но очевидно, что в рамках одной программы иметь всю необходимую функциональность удобнее.

⇨ 🌐 Сайт

Proxmox Backup Client

До появления Proxmox Backup Server я часто отдавал предпочтение при выборе гипервизора Hyper-V из-за того, что для Proxmox VE не было функционального инструмента для бэкапов VM, кроме его встроенного средства, которое делало только полные бэкапы.

С выходом PBS этот вопрос был закрыт, причём бескомпромиссно. Предложенное решение было лучше, чем любое другое бесплатное. Так что связка Proxmox VE + PBS аналогов сейчас не имеет по удобству, простоте настройки и эксплуатации.

Отдельно отметить и рассказать более подробно я хочу про Proxmox Backup Client. Это консольная утилита для Linux, которая позволяет делать бэкап на уровне файлов из виртуальной машины в PBS, даже если система находится на другом гипервизоре. То есть это полностью отвязанный от инфраструктуры Proxmox клиент, который позволяет складывать резервные копии в PBS. Таким образом этот сервер бэкапов может объединять в себе разнородную инфраструктуру.

Сразу перечислю основные ограничения этого клиента:

- бэкап только на уровне файлов или образов дисков, не системы целиком;

- официальная поддержка только deb дистрибутивов, для rpm люди сами собирают пакеты, так как исходники открыты;

- нет поддержки windows, вариант бэкапа данных оттуда только один - монтирование диска по smb к linux машине и бэкап этого примонтированного диска.

Использовать proxmox-backup-client очень просто. Я не буду подробно описывать его возможности, так как в оригинальной документации представлена исчерпывающая информация. Если хочется на русском, то можно обратиться к документации от altlinux. Кратко покажу пример установки и бэкапа.

Ставим Proxmox Backup Client на Debian:

# wget https://enterprise.proxmox.com/debian/proxmox-release-bookworm.gpg -O /etc/apt/trusted.gpg.d/proxmox-release-bookworm.gpg # mcedit /etc/apt/sources.list.d/pbs-client.list

Вставляем туда для Debian 12

deb http://download.proxmox.com/debian/pbs-client bookworm main

Для Debian 11:

deb http://download.proxmox.com/debian/pbs-client bullseye main

Для Debian 10:

deb http://download.proxmox.com/debian/pbs-client buster main

Ставим клиента:

# apt update && apt install proxmox-backup-client

Теперь бэкапим корень сервера без примонтированных дисков. То есть делаем бэкап системы:

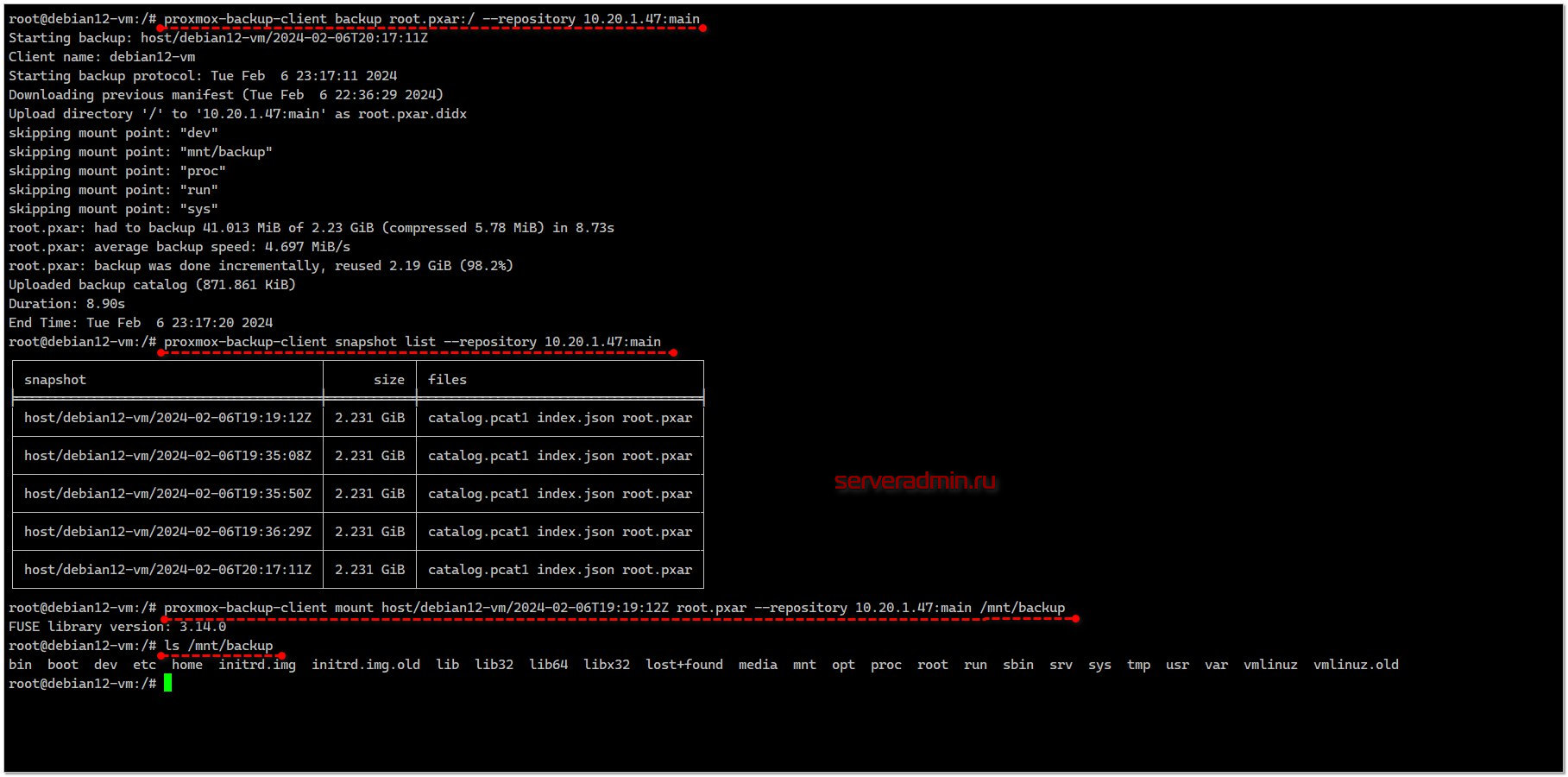

# proxmox-backup-client backup root.pxar:/ --repository 10.20.1.47:main

Здесь мы указали:

◽️root.pxar - имя архива в формате pbs

◽️/ - бэкапим корень системы

◽️10.20.1.47 - адрес pbs сервера

◽️main - имя datastore

По умолчанию используется учётная запись root@pam, то есть дефолтный админ. Разумеется, на проде так делать не надо, потому что у него полные права, в том числе на удаление архивов. Делайте отдельные учётки для разных систем с ограниченными правами. В PBS это организовано удобно и просто, так что разобраться не трудно. Для указания имени пользователя, нужно использовать такой вид репозитория: user01@pbs@10.20.1.47. То есть мы указали созданного вручную пользователя user01@pbs.

Для того, чтобы не вводить пароль пользователя вручную, можно задать его через переменную окружения PBS_PASSWORD.

Смотреть содержимое бэкапов можно как через веб интерфейс, так и тут локально. Причём бэкап можно примонтировать через fuse. Сморим снэпшоты и выбираем любой для монтирования:

# proxmox-backup-client snapshot list --repository 10.20.1.47:main # proxmox-backup-client mount host/debian12-vm/2024-02-06T19:19:12Z root.pxar --repository 10.20.1.47:main /mnt/backup

Очень быстро и удобно. При желании бэкапы можно шифровать.

⇨ 🌐 Обсуждение

Rdiff-backup

Недавно один человек у меня попросил совета по поводу программы для бэкапов в Linux на базе rsync, но только чтобы была полноценная поддержка инкрементных архивов, чтобы можно было вернуться назад на заданный день. Я знаю, что базовыми возможностями rsync без костылей и скриптов такое не сделать, поэтому сразу вспомнил про программу rdiff-backup. Хотел скинуть ссылку на свою заметку, но с удивлением обнаружил, что я вообще ни разу про неё не писал, хотя сам лично использовал.

Rdiff-backup по своей сути является python обёрткой вокруг rsync (используется библиотека librsync). Она наследует всю скорость и быстроту синхронизации сотен тысяч файлов, которую обеспечивает rsync. Если нужны бэкапы сырых файлов, без упаковки в архивы, дедупликации, сжатия и т.д., то я всегда предпочитаю использовать именно rsync. С ним быстрее и проще всего получить точную пофайловую копию какого-то файлового хранилища, которое регулярно синхронизируется. Это идеальный инструмент для организации горячего резерва файлового архива. В случае выхода из строя основного сервера или хранилища с файлами, можно очень быстро подмонтировать или организовать подключение копии, создаваемой с помощью rsync.

Особенно это актуально для почтовых серверов с форматом хранения maildir. Там каждое письмо это отдельный файл. В итоге файловое хранилище превращается в сотни тысяч мелких файлов, которые один раз скопировать может и не проблема, но каждый день актуализировать копию уже не так просто, так как надо сравнить источник и приёмник, где с каждой стороны огромное количество файлов и они меняются. По моему опыту, rsync это делает быстрее всех. Я даже на Windows сервера ставлю rsync и бэкаплю большие файловые хранилища с его помощью.

Возвращаюсь к Rdiff-backup. Он расширяет возможности rsync, позволяя очень быстро организовать полноценные инкрементные бэкапы, используя технологию hard link. Установить программу можно из стандартного репозитория Debian:

# apt install rdiff-backup

Если надо просто сделать копию каких-то данных, то не нужны никакие настройки и ключи. Просто копируем:

# rdiff-backup /var/www/site.ru/ /backup/site.ru/

Удалённое резервное копирование по SSH с сервера hostname на локальный бэкап-сервер:

# rdiff-backup user@hostname::/remote-dir local-dir

Добавляя ключи -v5 и --print-statistics вы можете получать подробную информацию о процессе бэкапа, которую потом удобно парсить, отправлять на хранение, мониторить.

Если между первым и вторым запуском бэкапа набор файлов менялся, то в локальной директории local-dir будет лежать самая последняя копия файлов. А кроме этого в ней же будет находиться директория rdiff-backup-data, которая будет содержать информацию и логи о проводимых бэкапах, а также инкременты, необходимые для отката на любой прошлый выполненный бэкап. Посмотреть инкременты можно вот так:

# rdiff-backup -l local-dir

Вы увидите наборы инкрементов и даты, когда они были созданы. С этими инкрементами можно некоторым образом работать. Например, можно посмотреть, какие файлы изменились за последние 5 дней:

# rdiff-backup list files --changed-since 5D local-dir

Или посмотреть список файлов, которые присутствовали в архиве 5 дней назад. Если список большой, то сразу выводите его в файл и там просматривайте, ищите нужный файл:

# rdiff-backup list files --at 5D local-dir

Ну и так далее. Подробное описание с примерами есть в документации. Главное, идея понятна. Все изменения от инкремента к инкременту хранятся и их можно анализировать.

Восстановление по сути представляет из себя обычное копирование файлов из актуальной копии. Это если вам нужно взять свежие данные от последней синхронизации. Если же вам нужно восстановиться из какого-то инкремента, то укажите его явно: # rdiff-backup restore local-dir/rdiff-backup-data/increments.2023-10-29T21:03:37+03:00.dir /tmp/restore

Программа простая и функциональная. Рекомендую 👍.

⇨ Сайт / Обсуждение

NXS-backup

Существует много консольных инструментов для настройки бэкапов. Наиболее популярные и функциональные restic и borg. Сегодня я расскажу про ещё один, который я недавно внедрил на один веб сервер, так что в конце приведу полные конфиги для полноценного использования.

Речь пойдёт про старый и относительно известный инструмент nxs-backup от компании Nixys. Я знаю его давно. Если не ошибаюсь, то сначала это был просто bash скрипт, потом его упаковали в пакеты. А где-то год назад его полностью переписали и теперь это бинарник на Go.

📌 Основные возможности nxs-backup:

🔹Полные и инкрементные бэкапы на уровне файлов.

🔹Бэкапы СУБД MySQL/PostgreSQL как дампом, так и бинарные.

🔹Бэкапы MongoDB и Redis.

🔹В качестве бэкенда для передачи и хранения может использоваться: S3, SSH (SFTP), FTP, CIFS (SMB), NFS, WebDAV.

🔹Уведомления по email, Telegram, Slack или любой webhook.

Теперь отдельно расскажу, что хорошего и полезного есть конкретно в этой программе, так как список возможностей типичный для подобных программ.

➕Простые конфиги в формате yaml для заданий + одиночный бинарник. Удобно масштабировать и использовать одни и те же настройки на различных проектах. Работает одинаково без зависимостей и пересборки практически на всех Linux.

➕Из предыдущего пункта вытекает удобство использования в контейнерах. В конфиги можно передавать переменные, что упрощает настройку и позволяет не хранить секреты в конфигах. Бонусом будет очень маленький образ с самим nxs-backup, если он будет запускаться отдельно.

➕Возможность гибкой настройки логов и уведомлений. Я сделал хранение полного лога в текстовом файле локально, который легко анализировать и куда-то в общее хранилище передавать. А оповещения об ошибках и предупреждениях отдельно отправляю в Telegram.

➕Бэкап на уровне файлов делается простым tar. На базе его же возможностей организованы инкрементные бэкапы. То есть файлы хранятся в исходном виде, а восстановление возможно самостоятельно без использования nxs-backup. Кому-то это покажется минусом, но лично я больше люблю хранение в таком виде. Да, нет дедупликации, но меньше шансов получить поврежденные данные в случае каких-то проблем.

➕В едином формате конфигов описываются задания для бэкапа файлов и баз. Закрываются базовые потребности одной программой. Не надо дампить или делать бинарные бэкапы каким-то отдельным инструментом.

➕Удобно настроить одновременно локальное хранение бэкапов и отправку в S3. Я обычно это сам костылю скриптами.

➕Есть Helm чарт для использования в Kubernetes.

☝️ Сразу отмечу явные минусы:

➖Нет встроенного шифрования.

➖Не очень удобно мониторить. По сути есть только логи и уведомления.

➖Документация так себе. Пришлось поковыряться, хоть в итоге всё и получилось, как задумал.

В целом, получилось неплохо. Я потратил время и создал для себя универсальные конфиги, которые буду использовать. Для интегратора или аутсорсера, кто занимается поддержкой серверов, это удобное решение. Собственно, оно для этих целей и писалось, чтобы закрыть внутренние потребности.

Установка:

# curl -L https://github.com/nixys/nxs-backup/releases/latest/download/nxs-backup-amd64.tar.gz -o /tmp/nxs-backup.tar.gz # tar xf /tmp/nxs-backup.tar.gz -C /tmp # sudo mv /tmp/nxs-backup /usr/sbin/nxs-backup

Подготовка основного конфига в /etc/nxs-backup/nxs-backup.conf:

Конфиг с заданием для бэкапа файлов /etc/nxs-backup/conf.d/site01-files.conf:

Конфиг с заданием для бэкапа БД /etc/nxs-backup/conf.d/site01-mysql.conf:

Проверяем конфигурацию:

# nxs-backup -t

Если есть ошибки, увидите их. Если нет, то запускаем бэкап:

# nxs-backup start all

У меня успешно создаётся локальный бэкап и одновременно с ним отправляется в S3 Селектела. Соответственно, политика хранения бэкапов указана. Nxs-backup будет автоматически складывать по указанной структуре бэкапы и удалять старые.

Продукт интересный. Кто занимается подобными вещами, рекомендую обратить внимание.

⇨ 🌐 Сайт / Обсуждение

Виртуальные машины

Veeam Backup & Replication Community Edition

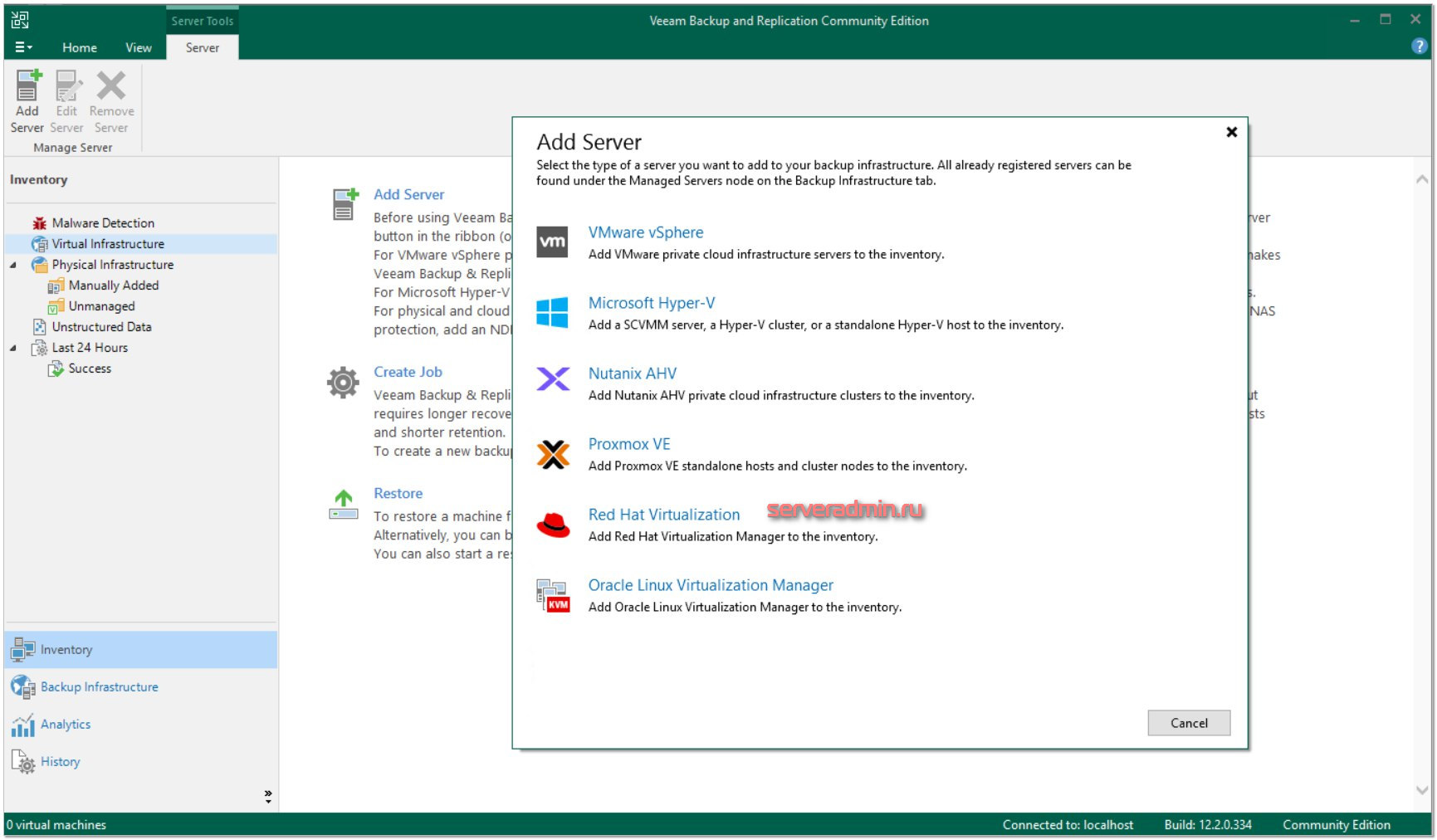

До меня докатилась новость о недавнем обновлении основного продукта Veeam - Veeam Backup & Replication. У них коммерческий продукт сейчас называется Veeam Data Platform, а бесплатная community версия так и осталась Veeam Backup & Replication Community Edition. Я перестал следить за их новостями с тех пор, как перешёл почти полностью на Proxmox и его продукт для бэкапа Proxmox Backup Server. Он закрывает базовые потребности малых и средних компаний. А Veeam Proxmox не поддерживал, поэтому и интереса не было.

Veeam решил повернуться в сторону KVM и в последнем релизе объявил поддержку систем виртуализации Nutanix и Proxmox VE. Из нового, там ещё отдельно поддержка MongoDB заявлена. На сегодняшний день это лидер рынка систем архивации данных, который поддерживает всё, что только можно: и облака, и гипервизоры, и СУБД, и отдельные системы. Он покрывает все популярные системы виртуализации: VMware, Microsoft Hyper‑V, Proxmox, Nutanix.

Решил посмотреть на бесплатную версию. У неё заявлены следующие ограничения:

This free gift from Veeam can protect up to 10 workloads: VMware, Hyper-V, Windows & Linux servers, laptops, NAS and more!

Насколько я понял, имеется ввиду 10 любых объектов для бэкапа. В принципе, средненькие ограничения, которые могут быть вполне функциональны для каких-то небольших или личных инфраструктур.

Для загрузки установщика нужна регистрация. Доступ с адресов РФ закрыт, качать через VPN. Объём установщика солидный - 12 ГБ. Устанавливать нужно на систему Windows, в качестве СУБД будет установлена PostgreSQL. В 12-й версии есть возможность отказаться от MS SQL. В 13-й версии вангую отказ от Windows и переход на веб панель управления, как в Vinchin.

Интерфейс обновлённой 12-й версии привычен. Он вообще мало меняется от релиза к релизу. Как и логика работы. Сразу попробовал бэкап Proxmox VE. Для добавления сервера в консоль управления достаточно указать IP адрес и рутовый доступ по SSH. Далее было предложено создать служебную виртуалку на гипервизоре, которую Veeam будет поднимать через Cloud-Init во время бэкапа.

Дальше всё как обычно. Выполняется бэкап, восстановление возможно как на уровне всей системы, так и файлов на ней. В комментариях видел, кто-то писал, что восстановление на уровне файлов не работает. Я проверил, такая возможность есть, но реализована она следующим образом. Нужен какой-то промежуточный Linux хост, куда бэкап будет примонтирован для доступа к файлам. Туда ставится служба veeamagent и монтируется бэкап через fuse.

Я добавил для теста гипервизор Proxmox и Hyper-V. Забэкапил по паре виртуальных машин оттуда, ушло 4 лицензии.

Добавить про Veeam особо больше нечего. Продукт известный, лидер своей ниши. Мне лично он нравится за то, что можно забэкапить виртуалки, добавить в систему какой-нибудь старый сервер и настроить на него восстановление этих виртуалок с оповещением на почту. В итоге ты и бэкапы проверяешь и всегда имеешь под рукой актуальную копию виртуалки для различных задач.

С учётом нарастающего объёма блокировок и санкций, использовать Veeam не очень хочется, но лучше ничего нет. Так что решайте сами для себя, нужен он вам или нет. По возможностям даже бесплатной версии всё выглядит очень привлекательно. Позволяет объединить всю инфраструктуру в одном продукте. К примеру, несколько виртуалок и сетевой диск. Ну и на торрентах традиционно полные версии есть.

⇨ 🌐 Сайт / Обсуждение

Proxmox Backup Server

Централизованный сервер для бэкапов виртуальных машин и данных, собранных с помощью установленных агентов на обычных Linux системах от авторов гипервизора Proxmox VE. Соответственно, только его он и поддерживает.

Основные возможности:

- Инкрементные копии и дедупликация.

- Бэкап на уровне виртуальной машины, виртуальных дисков или отдельных файлов с помощью Proxmox Backup Client.

- Репликация бэкапов на внешнее независимое хранилище.

- Автоматическая очистка устаревших бэкапов, защита определённых бэкапов от политик очистки.

- Различные репозитории с ограничением доступа на уровне пользователей и ролей.

- RESTful API с доступом по токенам.

- Шифрование и проверка целостности файлов на основе контрольных сумм.

- Управление через WEB интерфейс или CLI.

⇨ 🌐 Сайт

Vinchin Backup & Recovery

Я давно знаю и работаю с программой для бэкапа виртуальных сред Veeam Backup & Replication. Как всем известно, этот бренд ушёл из России, заблокировал доступ к своим ресурсам, не осуществляет продажи и не оказывает тех. поддержку. Полноценных аналогов с такой же функциональностью не так много. Я даже затрудняюсь назвать их, хотя наверняка есть, но мне не знакомы. То есть не работал с ними. Отечественные решения, насколько я знаю, по возможностям пока не дотягивают до Veeam.

Есть китайский аналог Vinchin Backup & Recovery. Я года два назад про него узнал, когда начались всевозможные санкции. Были пару обзоров от наших интеграторов КРОК и ГК ЛАНИТ. Причём отзывы вполне нормальные. В то же время на меня выходили сами разработчики и хотели какой-то кооперации: статьи, заметок в telegram, анонсов вебинаров и т.д. Был необычный опыт, так как общаться приходилось явно с не русскоязычным человеком, но мы понимали друг друга. Но всё как-то не срасталось по срокам и форматам.

Чтобы как-то предметно общаться, я решил всё же своими глазами посмотреть и попробовать этот продукт. К тому же на сайте есть русскоязычная версия с описанием, а список возможностей выглядит очень привлекательно. Можно объединить в единой системе бэкап вообще всей информации. Плюс поддержка отечественных ОС и систем виртуализации.

Есть полностью бесплатная версия для бэкапа трёх виртуальных машин. Не густо, конечно, но хоть что-то.

📌 Vinchin Backup & Recovery умеет бэкапить:

- Виртуальные машины на различных гипервизорах и системах виртуализации. Список там очень внушительный, перечислю наиболее популярные и актуальные: zVirt, ROSA Virtualization, RED Virtualization, Hyper-V, Proxmox, VMware, Citrix, XCP-ng, oVirt, OpenStack

- Базы данных популярных СУБД: MS SQL, MySQL, Oracle, PostgreSQL, MariaDB

- Файлы в операционных системах Windows и Linux с помощью установленных агентов. Есть поддержка Astra Linux и RED OS.

- Целиком операционные системы Windows и Linux, либо отдельные диски в них.

- Сетевые диски, подключаемые по протоколам CIFS и NFS.

- Microsoft Exchange как локальной установки, так и облачной.

- Виртуальные машины облачного провайдера AWS EC2

Получается, он покрывает все варианты информации. Тут и виртуальные машины, и сервера через агентов, и сетевые диски, и СУБД.

Я развернул у себя эту систему. Ставится автоматически из готового ISO образа. Всё управление через веб интерфейс. Попробовал забэкапить и восстановить виртуальные машины на Hyper-V и Proxmox, а также сетевой диск.

Всё получилось практически сходу. Система простая, функциональная и удобная. Мне прям она вообще понравилась. Оформил всё в простой обзор с картинками, чтобы наглядно показать, как всё это выглядит на практике:

⇨ Обзор Vinchin Backup & Recovery

Если выбираете себе подобный продукт, то посмотрите Vinchin. Честно говоря, я с некоторым скепсисом её разворачивал, ожидая увидеть какие-то нелогичности, мелкие баги как интерфейса, так и самой работы, возможно ещё какие-то проблемы. Но на удивление, всё прошло гладко и ровно. Никаких ошибок я не заметил.

За скобками остался вопрос стоимости. Так как на сайте в открытом доступе цен нет, сказать мне об этом нечего. Все цены только по запросу. В лучших традициях, так сказать. Ну и ещё раз напомню, что есть бесплатная версия для бэкапа трёх виртуальных машин.

⇨ 🌐 Сайт / Обсуждение

Заключение

Если считаете, что я пропустил какую-то полезную бесплатную программу для бэкапа, а она достойна войти в ТОП, делитесь в комментариях. Сразу скажу, что про Bacula и Bareos писать смысла нет. Я знаю про них, но не использую. Мне лично не нравятся. Настраивал и пользовался ими.

На углубленном курсе "Архитектура современных компьютерных сетей" вы с нуля научитесь работать с Wireshark и «под микроскопом» изучите работу сетевых протоколов. На протяжении курса надо будет выполнить более пятидесяти лабораторных работ в Wireshark.

Реклама ИП Скоромнов Д.А. ИНН 331403723315

Server Admin Авторский блог системного администратора

Server Admin Авторский блог системного администратора

Странно, но в списке я не обнаружил APBackUp. А между тем весьма достойный продукт.

В Hasleo Backup Suite не хватает функции восстановления загрузчика системы. Бывают моменты, когда после восстановления системы загрузчик слетает, и восстановить его трудно, или учеловека нет совершенно опыта, и времени на изучение данной темы. А так нажал бы кнопочку, программа показала бы какие системы нашла на носителях и предложила бы выбор, загрузчик какой системы создать на том или ином носителе. Минимум действий. Нажать на Восстановить Загрузку Системы, Выбрать систему, нажать Восстановить. Все.

Данная функция имеется в Macrium Reflect в BootCD образе. Это крайне удобно.

Небольшая заметка по UrBackup.

Разворачивал в тестовых целях. Использовал docker версию, т.к. для Ubuntu 24 версии пока нет.

Проверял работу только для файлового резервного копирования из под Windows. Обнаружил некоторые особенности. При создании резервной копии списки контроля доступа (ACL) не сохраняются. В случае длинных имен файлов, происходит "обрезание" имени файлов, с потерей его расширения. При восстановлении файла из резервного хранилища, сбрасываются все временные метки, даты создания, изменения и открытия сбрасываются на момент восстановления файла.

FreeSync использую на фирме для копирования по сети уже заархивированых локально архивов

дома настроил срабатывание синхронизации по собыимю подключения внешнего usb HDD с определенной папкой на пк (холодное хранилище)

потом смотрю журнал что все ок и отключаю внешний винт - удобно, во фрисинке создал задачу синхронизации, запускает зараннее сконфигурированную задачу через Планировщик Винды на это событие и запускает задачу фрисинк

Добрый день.

Ситуация следующая. В организации файловое хранилище построено на основе windows server. Объём был 15 Tb. Для резервного копирования использовался windows server backup. В связи с необходимостью увеличения объёма были закуплены HDD по 20 Tb (10шт.). На основе 4-х HDD создан RAID10 на proxmox. Виртуальная машина Windows server 2022. Объём диска с данными 39 Tb, занято 14 Tb. По сети подключен iscsi-диск, созданный на windows server 2022, на 39 Tb (RAID10 также созданный из 4-х HDD по 20 Tb). При попытке настроить расписание резервного копирования в windows server backup, в самом конце, когда форматирует предложенный для backup-а iscsi-диск пишет "Тома объёмом более 16 777 216 МБ невозможно защитить". Как я понимаю, проблема в том, что при настройке резервного копирования windows backup форматирует диск, который будет использоваться для их хранения, в ntfs, а у ntfs есть ограничение на максимальный размер файла - примерно 16 TB. А т.к. копия хранится в одном файле vhdx-диска, отсюда и возникает это ограничение.

1. Можно ли как-то обойти это ограничение, чтобы и дальше продолжать использовать windows server backup?

2. Если это ограничение обойти невозможно, то подскажите, пожалуйста, какие программы могли бы заменить windows server backup? Требования:

- резервное копирование без блокировки виртуальном машины или файлов (я так понимаю, что должна быть поддержка VSS)

- настраиваемое добавочное и инкрементное копирование;

- сохранение прав на папки и файлы при восстановлении;

- быстрая работа с такими объёмами;

- возможность восстанавливать отдельные папки и файлы;

в общем все те возможности которые предлагала windows server backup + работа с большими объёмами.

Касательно DeltaCopy. Как то смотрел её и столкнулся с проблемой кодировки. Все имена файлов на кирилице портились. Для rsync есть ключ --iconv на случай проблем с кодировкой но при --iconv=windows-1251,utf-8 вылезала ошибка The server is configured to refuse --iconv в итоге так и не понял что нужно.

Не работает KopiaUI на Win8. Завершается с ошибкой Точка входа в процедуру DiscardVirtualMemory не найдена. Хоть бы требования какие были обозначены :(

ты еще на Win8? Пора уже переходить на Win95

есть еще Minarca github - ikus060/minarca

Спасибо, посмотрю. Не слышал о ней.

Здравствуйте, подскажите, пожалуйста, как из программ лучше подойдёт для малого офиса. Хочу бекапить рабочие машины по локальной сети на Xpenology NAS. Интересуют: сжатие резервных копий, инкрементное резервное копирование, резервное копирование по расписанию с автоматическим удалением, возможность создания диска восстановления. Аналог AOMEI Backupper, только бесплатный.

Что значит бэкапить рабочие машины? Делать образы дисков, чтобы можно было восстановить всю систему? Или речь идёт о конкретных данных на этих машинах?

Сразу всю систему. В ПК стоят 120гб ssd. Данные все хранятся на nas.

Для этого лучше всего подойдёт Veeam Agent for Windows Free. Постоянно его использую. Простое и надёжное средство.

Благодарю вас, попробую!

Возможно, FOG project подойдёт. Мне он понравился, бесплатный, по сети можно образы разворачивать, массово при чем.

кстати в 2022 вышел продолжатель дела Cobian Backup - Cobian Reflector, обещают то-же, но заново переписанное

А почему Handy Backup не рассмотрели?

У неё нет бесплатной версии.

Что то используете для бэкапа ВМ на бесплатной платформе ESXi 6.5?

Не пользуюсь бесплатной ESXi, потому что не знаю, чем её бэкапить.

Iperius Backup

Cobian Backup глючно работает, старые бэкапы автоматически не удаляет, на сервер глючно бэкапит. Притом начинает глючить в процессе работы, сначала работает хорошо. Или сбоит на самом бэкапе папок или на их архивировании.

Пытался работать с ней на Вин7, вин8.1, Вин10.

в UrBackup есть одна неудобная вещь - место для бэкапа можно выбрать только одно, т.е если у вас разные диски, например, под baremetal и под файлы, так не получится. Тока 1 путь. ( эх жалко

В Kopia отключить шифрование нельзя? И как она сравнивает файлы? По времени создания или по хешу?

Syncthing не для бэкапов https://docs.syncthing.net/users/faq.html#is-syncthing-my-ideal-backup-application

Это всё условности. Конечно, для горячих данных Syncthing не подходит. А вот для хранения трех копий холодных данных в разных местах вполне подходит. И запускать Syncthing можно по расписанию, а не постоянно.

Доброго!

Работаю с Syncthing с нулевых версий 2016 года, знаю его изнутри и тащу специальный порт для устаревших систем XP/2003 на go1.11.13 windows/386 (TLS 1.3). Это действительно не инструмент бекапа, а отличный сихронизатор контента. Любого контента, холодного/горячего – непринципиально, в том числе и между совершенно разными системами, он над данными и над системами бекапа.

- go дает возможность ему работать даже на кофейнике, а единый бандл упрощает администрирование и обновление уже развернутых систем;

- периодический скан контента, скан по запросу, подписка на события в каталогах;

- корзина объектов, внутренняя реализация версионности и подключение сторонних систем контроля версий;

- веб-интерфейс, командная строка, сторонние утилиты;

- понятный релизный план выпусков новых версий.

В продакшене на системах терабайты в синхронизации и размером она с Кемеровскую область - Кузбасс всего лишь, а меня даже на карте фактически не видно:

https://data.syncthing.net/

У меня сейчас в синхронизации потолок на хостах 2.5Tb, а у людей в ней петабайты. Просто размазываю данные по области, т.к. у меня нет возможности по каналам забирать разом всю область в центр, для этого работают отдельные узлы на направлениях (зову их «плечи», территориально распределены и на разных провайдерах).

В общем моя любовь к Syncthing скоро уже пойдет в школу :) по вопросам синка могу пообщаться тут или в почте/телеге.

Павел

Визуально (графическая часть) понравилась Burp, но как-то замысловата установка...

Не планируется разбор какой-либо Linux системы для резервного копирования?

Не совсем понял, какого рода разбор имеется ввиду?

По поводу DeltaCopy, использую её в качестве сервера rsync на Windows машинах.

Обнаружил после установки, что очень медленная скорость копирования удаленного клиента rsync по каналу 1Гбит/сек.

Скорость копирования составляла ~15МБайт/сек.

Какие только настройки не перепробовал на сервере и клиенте, ничего не помогает.

Нашел решение, обновив компоненты DeltaCopy из архива:

https://sourceforge.net/projects/backuppc/files/cygwin-rsyncd/3.1.2.1/cygwin-rsyncd-3.1.2.1_source.zip/download

Из архива из каталога "bin" скопировать с заменой все файлы с расширением *.dll и *.exe в каталог установки DeltaCopy

После обновления компонентов скорость копирования стала ~90МБайт/сек (~720Мбит/сек)

К сожалению не нашел в статье: Вы могли бы подсказать, какой софт проверяет целостность итогового файла? к примеру, по хеш-сумме.

Не видели Вы UrBackup в действии и "правильно его готовить не умеете".

UrBackup по умолчанию плодит линки. После 10К+ файлов всё надёжно вешается. Для нормальной работы ему надо btrfs (работает из контейнера) или zfs (из родного контейнера не запускается). Тогда он вместо линков использует снапшоты и cow, и его можно перевести в режим "вечного инкремента", что на объёмах в 1Т+ весьма полезно. На zfs не умеет работать с субклиентами из коробки, но можно уговорить (source code доступны на github). Файлы хранит как файлы, образы в VHD.

И директорию для резервного копирование на хосте ему надо называть так же, как в контейнере (по умолчанию /backups), а то все линки "съедут" и без контейнера будет очень грустно.