Большие информационные системы генерируют огромное количество служебной информации, которую нужно где-то хранить. Я расскажу о том, как настроить хранилище для логов на базе Elasticsearch, Logstash и Kibana, которое называют ELK Stack. В это хранилище можно настроить отправку практически любых логов в разных форматах и большого объема.

Научиться настраивать MikroTik с нуля или систематизировать уже имеющиеся знания можно на углубленном онлайн-курcе по администрированию MikroTik. Автор курcа – сертифицированный тренер MikroTik Дмитрий Скоромнов. Более 40 лабораторных работ по которым дается обратная связь. В три раза больше информации, чем в MTCNA.

Реклама ИП Скоромнов Д.А. ИНН 331403723315

Введение

Я буду настраивать одиночный хост. В данной статье будут самые азы - как сделать быструю установку и базовую настройку, чтобы можно было собирать логи в Elasticsearch и смотреть их в Kibana. Для примера, настрою сбор логов как с linux, так и windows серверов. Инструкция по установке будет полностью основана на официальной документации. Если вы хорошо читаете английские тексты, то можете использовать ее. Неудобство будет в том, что вся информация разрозненно располагается в разных статьях. Если вы первый раз настраиваете ELK Stack, то будет трудно сразу во всем разобраться. В своей статье я собрал в одном месте необходимый минимум для запуска Elasticsearch, Logstash, Kibana и агентов Filebeat и Winlogbeat для отправки логов с серверов.

Что такое ELK Stack

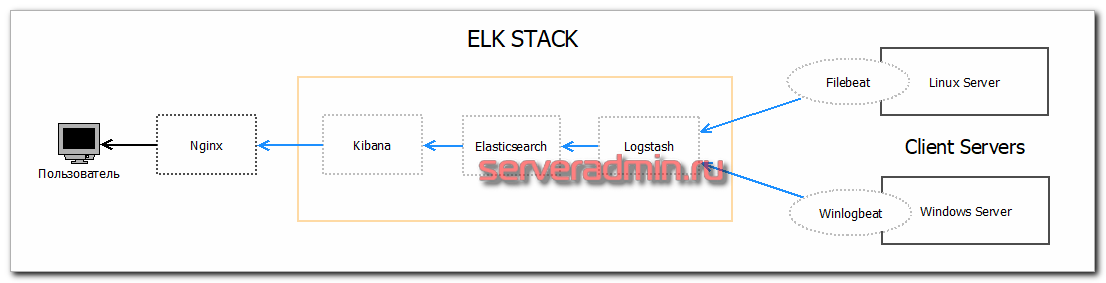

Расскажу своими словами о том, что мы будем настраивать. Ранее на своем сайте я уже рассказывал о централизованном сборе логов с помощью syslog-ng. Это вполне рабочее решение, хотя очевидно, что когда у тебя становится много логов, хранить их в текстовых файлах неудобно. Надо как-то обрабатывать и выводить в удобном виде для просмотра. Именно эти проблемы и решает представленный стек программ:

- Elasticsearch используется для хранения, анализа, поиска по логам.

- Kibana представляет удобную и красивую web панель для работы с логами.

- Logstash сервис для сбора логов и отправки их в Elasticsearch. В самой простой конфигурации можно обойтись без него и отправлять логи напрямую в еластик. Но с logstash это делать удобнее.

- Beats - агенты для отправки логов в Logstash или Elasticsearch. Они бывают разные. Я буду использовать Filebeat для отправки данных из текстовых логов linux и Winlogbeat для отправки логов из журналов Windows систем.

К этой связке еще добавляется Nginx, который проксирует соединения в Kibana. В самом простом случае он не нужен, но с ним удобнее. Можно, к примеру, добавить авторизацию или ssl сертификат, в nginx удобно управлять именем домена. В случае большой нагрузки, разные службы разносятся по разным серверам или кластерам. В своем примере я все установлю на один сервер. Схематично работу данной системы можно изобразить вот так:  Начнем по этапам устанавливать и настраивать все компоненты нашей будущей системы хранения и обработки логов различных информационных систем.

Начнем по этапам устанавливать и настраивать все компоненты нашей будущей системы хранения и обработки логов различных информационных систем.

Если у вас еще нет своего сервера с CentOS 8, то рекомендую мои материалы на эту тему:

Если у вас еще не настроен сервер с Debian, рекомендую мои материалы на эту тему:

Раньше для установки всех перечисленных компонентов необходимо было отдельно устанавливать Java на сервер. Сейчас в этом нет необходимости, так как Java уже включена в пакеты устанавливаемого ПО.

Системные требования

Для установки одиночного инстанса с полным набором компонентов ELK необходимы следующие системные ресурсы.

| минимальные | рекомендуемые | |

| CPU | 2 | 4+ |

| Memory | 6 Gb | 8+ Gb |

| Disk | 10 Gb | 10+ Gb |

Некоторое время назад для тестовой установки ELK Stack достаточно было 4 Gb оперативной памяти. На текущий момент с версией 8.17.0 у меня не получилось запустить одновременно Elasticsearch, Logstash и Kibana на одной виртуальной машине с четырьмя гигабайтами памяти. После того, как увеличил до 6, весь стек запустился. Но для комфортной работы с ним нужно иметь не менее 8 Gb и 4 CPU. Если меньше, то виртуальная машина начинает тормозить, очень долго перезапускаются службы. Работать некомфортно. Можно ограничить потребление оперативной памяти в настройках elasticsearch, чтобы он запустился с меньшей доступной памятью. Ниже я покажу как это сделать. Тем не менее, для нормальной работы с нагрузкой ему нужно 6+ Gb.

В системных требованиях для ELK я указал диск в 10 Gb. Этого действительно хватит для запуска стека и тестирования его работы на небольшом объеме данных. В дальнейшем, понятное дело, необходимо ориентироваться на реальный объем данных, которые будут храниться в системе.

Установка Elasticsearch

Устанавливаем ядро системы по сбору логов - Elasticsearch. Его установка очень проста за счет готовых пакетов под все популярные платформы.

Ubuntu / Debian

Копируем себе публичный ключ репозитория:

# wget -qO - https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo apt-key add -

Если у вас нет пакета apt-transport-https, то надо установить:

# apt install apt-transport-https

Добавляем репозиторий Elasticsearch в систему:

echo "deb https://artifacts.elastic.co/packages/8.x/apt stable main" | tee -a /etc/apt/sources.list.d/elastic-8.x.list

Если у вас нет доступа к репозиторию, то можете воспользоваться моим. Я создал копию репозитория elastic для Debian 11 и 12. Под все остальные системы можно через браузер скачать нужный пакет и установить вручную. Подключаем к Debian 11:

# echo "deb http://elasticrepo.serveradmin.ru bullseye main" | tee /etc/apt/sources.list.d/elasticrepo.list

# wget -qO - http://elasticrepo.serveradmin.ru/elastic.asc | apt-key add -

Подключаем к Debian 12:

# echo "deb http://elasticrepo.serveradmin.ru bookworm main" | tee /etc/apt/sources.list.d/elasticrepo.list

# wget -qO - http://elasticrepo.serveradmin.ru/elastic.asc | apt-key add -

Устанавливаем Elasticsearch на Debian или Ubuntu:

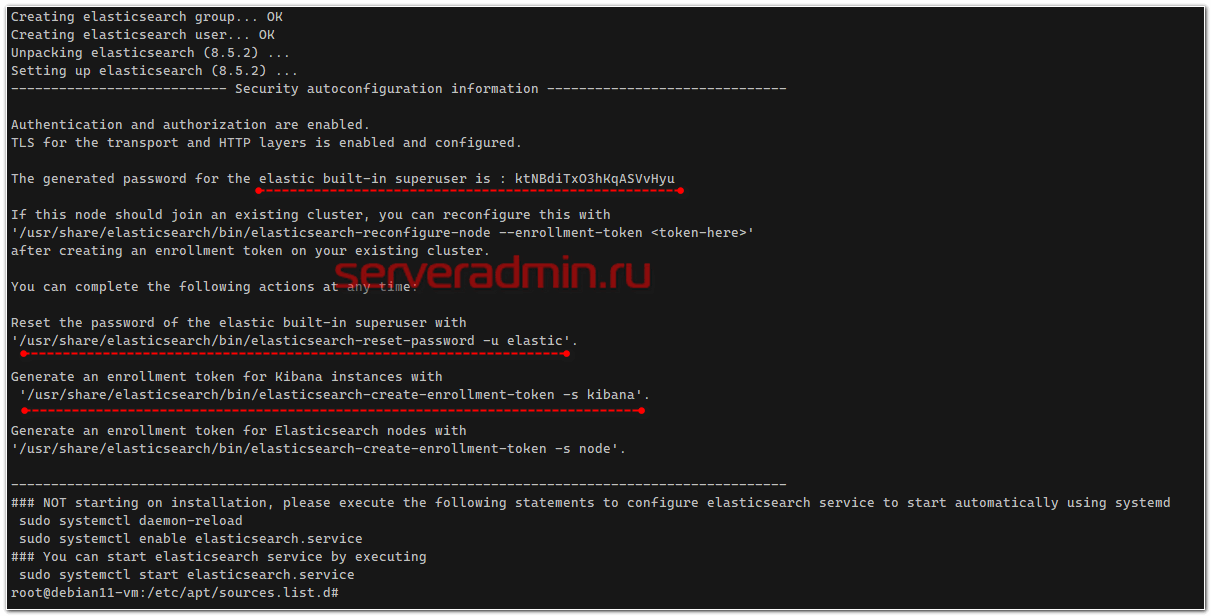

# apt update && apt install elasticsearch

В консоли вы увидите некоторую полезную информацию, которую имеет смысл сохранить.

- Пароль встроенной учётной записи elastic с полными правами.

- Команда на сброс пароля для elastic.

- Команда для генерации токена доступа для Kibana.

После установки добавляем elasticsearch в автозагрузку и запускаем.

# systemctl daemon-reload # systemctl enable elasticsearch.service # systemctl start elasticsearch.service

Проверяем, запустился ли он:

# systemctl status elasticsearch.service

Проверим теперь, что elasticsearch действительно нормально работает. Выполним к нему простой запрос об его статусе. Здесь нам уже пригодится учётная запись с правами доступа к кластеру. Неавторизованные запросы, а также запросы по HTTP в 8-й версии elasticsearch не принимаются.

# # curl -k --user elastic:'ktNBdiTxO3hKqASVvHyu' https://127.0.0.1:9200

{

"name" : "debian11-vm",

"cluster_name" : "elasticsearch",

"cluster_uuid" : "vuinIS6tRACwasu9nG2kdw",

"version" : {

"number" : "8.5.2",

"build_flavor" : "default",

"build_type" : "deb",

"build_hash" : "a846182fa16b4ebfcc89aa3c11a11fd5adf3de04",

"build_date" : "2022-11-17T18:56:17.538630285Z",

"build_snapshot" : false,

"lucene_version" : "9.4.1",

"minimum_wire_compatibility_version" : "7.17.0",

"minimum_index_compatibility_version" : "7.0.0"

},

"tagline" : "You Know, for Search"

}

В случае запроса по HTTP, а не HTTPS, в логе Elasticsearch будет ошибка:

received plaintext http traffic on an https channel, closing connection Netty4HttpChannel{localAddress=/127.0.0.1:9200, remoteAddress=/127.0.0.1:39964

Если у вас всё в порядке, то переходим к настройке Elasticsearch.

Centos Stream, Rocky Linux, Almalinux, Oracle Linux

Установка Elasticsearch на rpm операционные системы (Centos, Rocky Linux, Almalinux, Oracle Linux) ничем не отличается от deb систем. Копируем публичный ключ репозитория:

# rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

Подключаем репозиторий Elasticsearch:

# mcedit /etc/yum.repos.d/elasticsearch.repo

[elastic-8.x] name=Elastic repository for 8.x packages baseurl=https://artifacts.elastic.co/packages/8.x/yum gpgcheck=1 gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch enabled=1 autorefresh=1 type=rpm-md

Приступаем к установке еластика:

# yum install --enablerepo=elasticsearch elasticsearch

Если скачали пакет вручную с любого компьютера, скопировали на сервер, то установить можно следующим образом:

# rpm -ivh elasticsearch-8.5.2-x86_64.rpm

В консоли вы увидите некоторую полезную информацию, которую имеет смысл сохранить.

- Пароль встроенной учётной записи elastic с полными правами.

- Команда на сброс пароля для elastic.

- Команда для генерации токена доступа для Kibana.

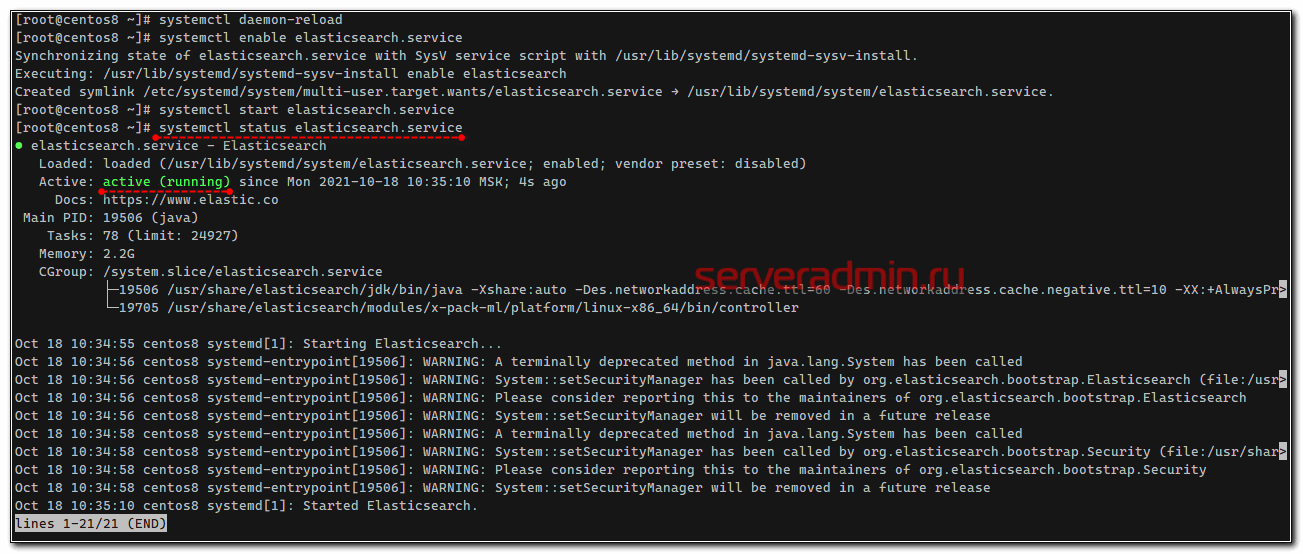

В в завершении установки добавим elasticsearch в автозагрузку и запустим его с дефолтными настройками:

# systemctl daemon-reload # systemctl enable elasticsearch.service # systemctl start elasticsearch.service

Проверяем, запустилась ли служба:

# systemctl status elasticsearch.service

Проверим теперь, что elasticsearch действительно нормально работает. Выполним к нему простой запрос о его статусе, не забывая об аутентификации.

# curl -k --user elastic:'ktNBdiTxO3hKqASVvHyu' https://127.0.0.1:9200

{

"name" : "rockylinux8",

"cluster_name" : "elasticsearch",

"cluster_uuid" : "vuinIS6tRACwasu9nG2kdw",

"version" : {

"number" : "8.5.2",

"build_flavor" : "default",

"build_type" : "rpm",

"build_hash" : "a846182fa16b4ebfcc89aa3c11a11fd5adf3de04",

"build_date" : "2022-11-17T18:56:17.538630285Z",

"build_snapshot" : false,

"lucene_version" : "9.4.1",

"minimum_wire_compatibility_version" : "7.17.0",

"minimum_index_compatibility_version" : "7.0.0"

},

"tagline" : "You Know, for Search"

}

Все в порядке, сервис реально запущен и отвечает на запросы.

Настройка Elasticsearch

Настройки Elasticsearch находятся в файле /etc/elasticsearch/elasticsearch.yml. На начальном этапе нас будут интересовать следующие параметры:

path.data: /var/lib/elasticsearch # директория для хранения данных network.host: 127.0.0.1 # слушаем только локальный интерфейс

http.host: 127.0.0.1 # слушаем только локальный интерфейс

По умолчанию Elasticsearch слушает localhost. Нам это и нужно, так как данные в него будет передавать logstash, который будет установлен локально. Обращаю отдельное внимание на параметр для директории с данными. Чаще всего они будут занимать значительное место, иначе зачем нам Elasticsearch. Подумайте заранее, где вы будете хранить логи. Все остальные настройки я оставляю дефолтными. После изменения настроек, надо перезапустить службу:

# systemctl restart elasticsearch.service

Смотрим, что получилось:

# ss -tulnp | grep 9200

tcp LISTEN 0 4096 [::ffff:127.0.0.1]:9200 *:* users:(("java",pid=26654,fd=540))

Elasticsearch повис на локальном интерфейсе. Причем я вижу, что он слушает ipv6, а про ipv4 ни слова. Но его он тоже слушает, так что все в порядке. Если вы хотите, чтобы elasticsearch слушал все сетевые интерфейсы, настройте параметр:

network.host: 0.0.0.0

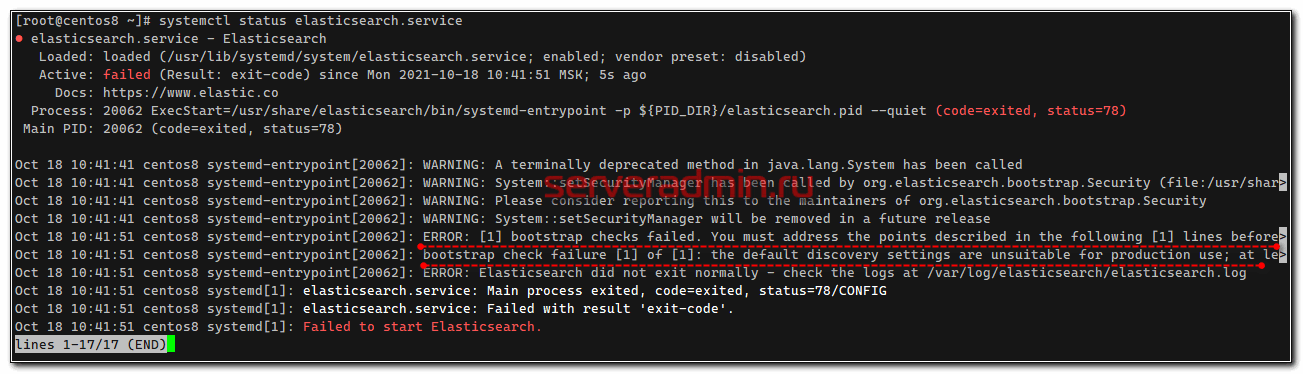

Только не спешите сразу же запускать службу. Если запустите, получите ошибку:

[2021-10-18T10:41:51,062][ERROR][o.e.b.Bootstrap ] [centos8] node validation exception [1] bootstrap checks failed. You must address the points described in the following [1] lines before starting Elasticsearch. bootstrap check failure [1] of [1]: the default discovery settings are unsuitable for production use; at least one of [discovery.seed_hosts, discovery.seed_providers, cluster.initial_master_nodes] must be configured

Чтобы ее избежать, дополнительно надо добавить еще один параметр:

discovery.seed_hosts: ["127.0.0.1", "[::1]"]

Этим мы указываем, что хосты кластера следует искать только локально.

По умолчанию в настройках виртуальной машины Java для Elasticsearch указано, что он автоматически выбирает объём использования оперативной памяти в зависимости от того, что есть из доступного в системе. Если вы хотите вручную ограничить его в этом, то отредактируйте соответствующие параметры в файле /etc/elasticsearch/jvm.options, а лучше создайте отдельный корректирующий файл с настройками в папке /etc/elasticsearch/jvm.options.d/mem.options, где укажите параметры:

-Xms2g

-Xmx2g

В данном примере я указал использовать не более двух гигабайт оперативной памяти. Это подойдёт для тестовых установок. Для постоянной работы лучше оставить настройки по умолчанию или указать не менее 4-х гигабайт. После изменения этих настроек, службу надо перезапустить, как мы это делали ранее.

Переходим к установке Kibana.

Установка Kibana

Дальше устанавливаем web панель Kibana для визуализации данных, полученных из Elasticsearch. Тут тоже ничего сложного, репозиторий и готовые пакеты есть под все популярные платформы. Репозитории и публичный ключ для установки Kibana будут такими же, как в установке Elasticsearch. Но я еще раз все повторю для тех, кто будет устанавливать только Kibana, без всего остального. Это продукт законченный и используется не только в связке с Elasticsearch.

Centos Stream, Rocky Linux, Almalinux, Oracle Linux

Импортируем ключ репозитория:

# rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

Добавляем конфиг репозитория:

# mcedit /etc/yum.repos.d/kibana.repo

[elastic-8.x] name=Elastic repository for 8.x packages baseurl=https://artifacts.elastic.co/packages/8.x/yum gpgcheck=1 gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch enabled=1 autorefresh=1 type=rpm-md

Запускаем установку Kibana:

# yum install kibana

Если репозиторий заблокирован, то качаем и копируем файл вручную, запускаем установку:

# rpm -ivh kibana-8.5.2-amd64.deb

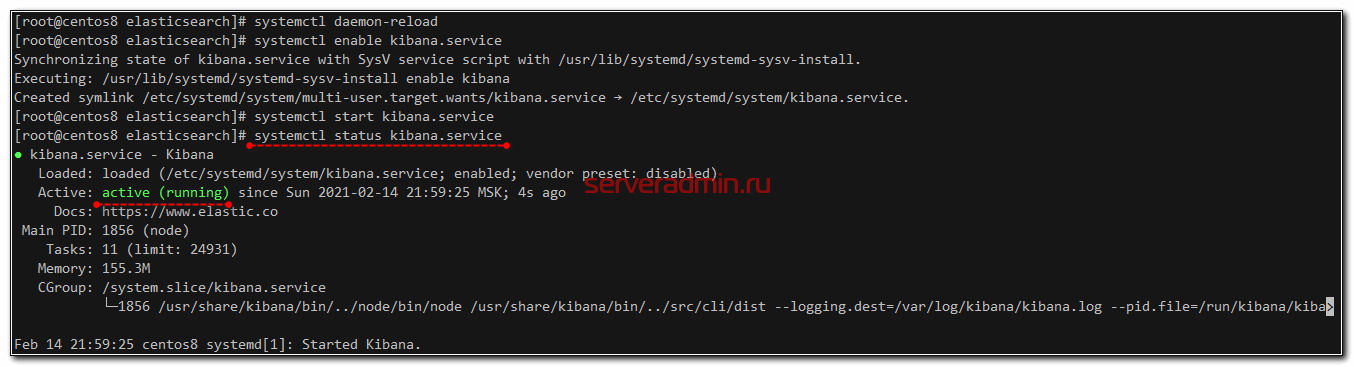

Добавляем Кибана в автозагрузку и запускаем:

# systemctl daemon-reload # systemctl enable kibana.service # systemctl start kibana.service

Проверяем состояние запущенного сервиса:

# systemctl status kibana.service

По умолчанию, Kibana слушает порт 5601. Только не спешите его проверять после запуска. Кибана стартует долго. Подождите примерно минуту и проверяйте.

# netstat -tulnp | grep 5601 tcp 0 0 127.0.0.1:5601 0.0.0.0:* LISTEN 20746/node

Ubuntu, Debian

Установка Kibana на Debian или Ubuntu такая же, как и на центос - подключаем репозиторий и ставим из deb пакета. Добавляем публичный ключ:

# wget -qO - https://artifacts.elastic.co/GPG-KEY-elasticsearch | apt-key add -

Добавляем репозиторий Kibana:

# echo "deb https://artifacts.elastic.co/packages/8.x/apt stable main" | tee -a /etc/apt/sources.list.d/elastic-8.x.list

Или мой репозиторий:

# echo "deb http://elasticrepo.serveradmin.ru bullseye main" | tee /etc/apt/sources.list.d/elasticrepo.list

# wget -qO - http://elasticrepo.serveradmin.ru/elastic.asc | apt-key add -

Запускаем установку Kibana:

# apt update && apt install kibana

Добавляем Кибана в автозагрузку и запускаем:

# systemctl daemon-reload # systemctl enable kibana.service # systemctl start kibana.service

Проверяем состояние запущенного сервиса:

# systemctl status kibana.service

По умолчанию, Kibana слушает порт 5601. Только не спешите его проверять после запуска. Кибана стартует долго. Подождите примерно минуту и проверяйте.

# ss -tulnp | grep 5601

tcp LISTEN 0 511 127.0.0.1:5601 0.0.0.0:* users:(("node",pid=27166,fd=20))

Настройка Kibana

Файл с настройками Кибана располагается по пути - /etc/kibana/kibana.yml. На начальном этапе нам нужно корректно настроить подключение к серверу elasticsearch. По умолчанию Kibana слушает только localhost и не позволяет подключаться удаленно. Это нормальная ситуация, если у вас будет на этом же сервере установлен nginx в качестве reverse proxy, который будет принимать подключения и проксировать их в Кибана. Так и нужно делать в production, когда системой будут пользоваться разные люди из разных мест. С помощью nginx можно будет разграничивать доступ, использовать сертификат, настраивать нормальное доменное имя и т.д. Если же у вас это тестовая установка, то можно обойтись без nginx. Для этого надо разрешить Кибана слушать внешний интерфейс и принимать подключения. Измените параметр server.host, указав ip адрес сервера, например вот так:

server.host: "10.20.1.56"

Если хотите, чтобы она слушала все интерфейсы, укажите в качестве адреса 0.0.0.0.

Далее нам нужно настроить аутентификацию в elasticsearch. Для этого создадим пароль для встроенного пользователя kibana_system:

# /usr/share/elasticsearch/bin/elasticsearch-reset-password -u kibana_system

Сохраняем пароль и добавляем учётку в конфигурацию kibana:

elasticsearch.username: "kibana_system"

elasticsearch.password: "mtbg5rIwh*E*eWuBCECG"

Теперь нам нужно указать сертификат от центра сертификации, который использовал elasticsearch для генерации tls сертификатов. Напомню, что обращения он принимает только по HTTPS. Так как мы не устанавливали подтверждённый сертификат, будем использовать самоподписанный, который был сгенерирован автоматически во время установки elasticsearch. Все созданные сертификаты находятся в директории /etc/elasticsearch/certs. Скопируем их в /etc/kibana и настроим доступ со стороны веб панели:

# cp -R /etc/elasticsearch/certs /etc/kibana

# chown -R root:kibana /etc/kibana/certs

Добавим этот CA в конфигурацию Кибаны:

elasticsearch.ssl.certificateAuthorities: [ "/etc/kibana/certs/http_ca.crt" ]

И последний момент - указываем подключение к elasticsearch по HTTPS:

elasticsearch.hosts: ["https://localhost:9200"]

Теперь Kibana можно перезапустить:

# systemctl restart kibana.service

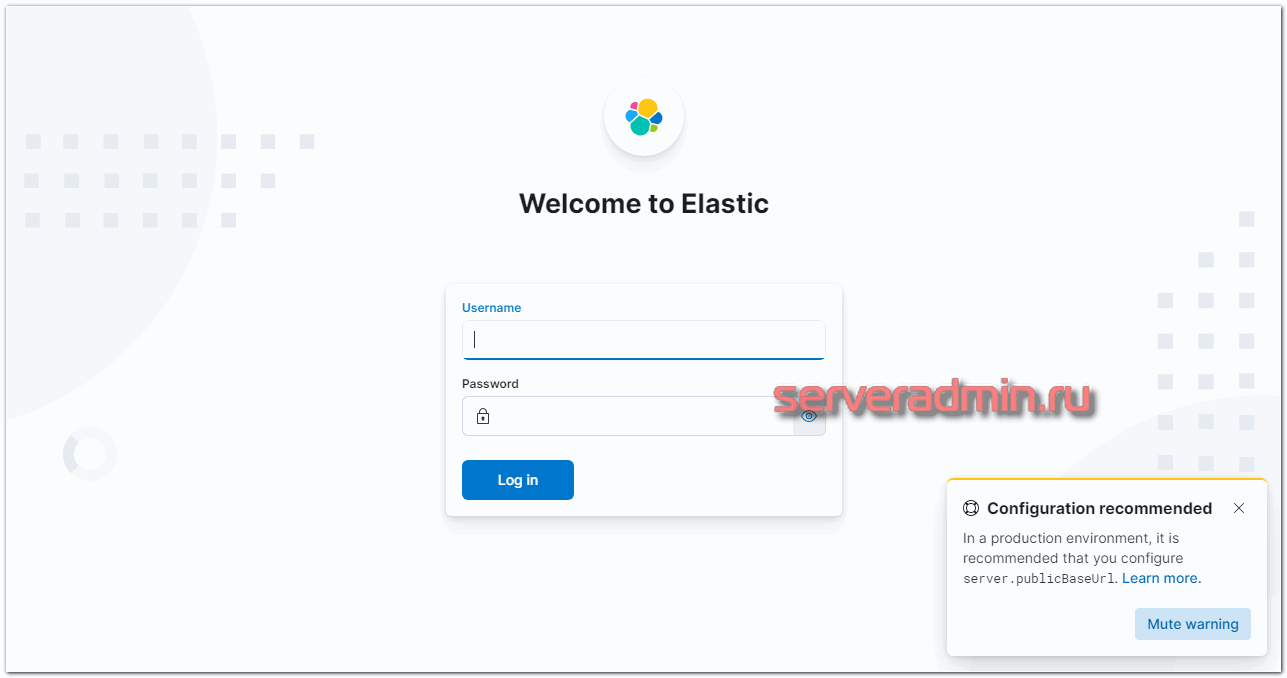

Идём в веб интерфейс по адресу http://10.20.1.56:5601. Если не открывается, подождите некоторое время. Kibana долго стартует.

Заходим под учётной записью elastic. Можно продолжать настройку и тестирование, а когда все будет закончено, запустить nginx и настроить проксирование. Я настройку nginx оставлю на самый конец. В процессе настройки буду подключаться напрямую к Kibana. При первом запуске Kibana предлагает настроить источники для сбора логов. Это можно сделать, нажав на Add integrations. К сбору данных мы перейдем чуть позже, так что можете просто изучить интерфейс и возможности этой веб панели

Периодически вы можете видеть в веб интерфейсе предупреждение:

server.publicBaseUrl is missing and should be configured when running in a production environment. Some features may not behave correctly.

Чтобы его не было, просто добавьте в конфиг Kibana параметр:

server.publicBaseUrl: "http://10.20.1.23:5601/"

Или доменное имя, если используете его.

Установка и настройка Logstash

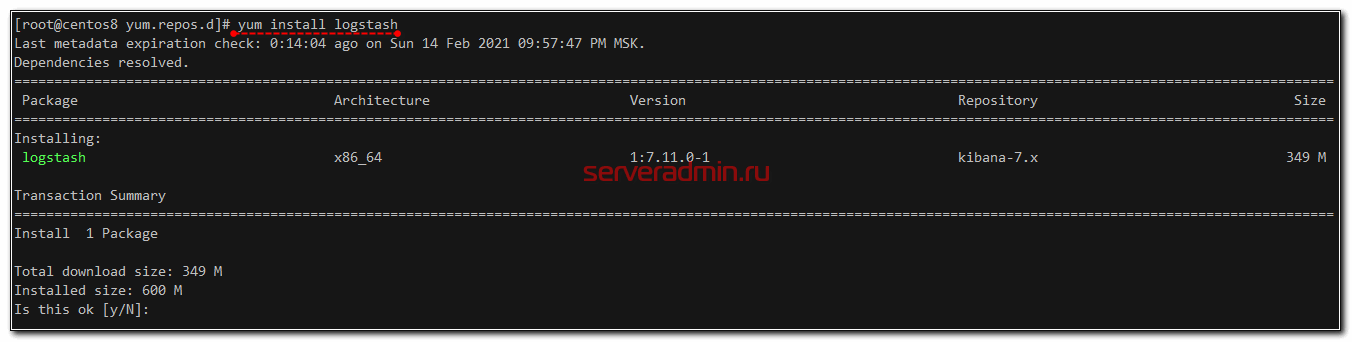

Logstash устанавливается так же просто, как Elasticsearch и Kibana, из того же репозитория. Не буду еще раз показывать, как его добавить. Просто установим его и добавим в автозагрузку. Установка Logstash в Centos:

# yum install logstash

Установка Logstash в Debian/Ubuntu:

Установка Logstash в Debian/Ubuntu:

# apt install logstash

Добавляем logstash в автозагрузку:

# systemctl enable logstash.service

Запускать пока не будем, надо его сначала настроить. Основной конфиг logstash лежит по адресу /etc/logstash/logstash.yml. Я его не трогаю, а все настройки буду по смыслу разделять по разным конфигурационным файлам в директории /etc/logstash/conf.d. Создаем первый конфиг input.conf, который будет описывать приём информации с beats агентов.

input {

beats {

port => 5044

}

}

Тут все просто. Указываю, что принимаем информацию на 5044 порт. Этого достаточно. Если вы хотите использовать ssl сертификаты для передачи логов по защищенным соединениям, здесь добавляются параметры ssl. Я буду собирать данные из закрытого периметра локальной сети, у меня нет необходимости использовать ssl. Теперь укажем, куда будем передавать данные. Тут тоже все относительно просто. Рисуем конфиг output.conf, который описывает передачу данных в Elasticsearch.

output {

elasticsearch {

hosts => "https://localhost:9200"

index => "websrv-%{+YYYY.MM}"

user => "elastic"

password => "ktNBdiTxO3hKqASVvHyu"

cacert => "/etc/logstash/certs/http_ca.crt"

}

}

Что мы настроили? Передавать все данные в elasticsearch под указанным индексом с маской в виде даты. Разбивка индексов по дням и по типам данных удобна с точки зрения управления данными. Потом легко будет выполнять очистку данных по этим индексам. Для аутентификации я указал учётку elastic, но вы можете сделать и отдельную через Kibana (раздел Stack Management -> Users). При этом можно создавать под каждый индекс свою учётную запись с разрешением доступа только к этому индексу.

Как и в случае с Kibana, для Logstash нужно указать CA, иначе он будет ругаться на недоверенный сертификат elasticsearch и откажется к нему подключаться. Копируем сертификаты и назначаем права:

# cp -R /etc/elasticsearch/certs /etc/logstash

# chown -R root:logstash /etc/logstash/certs

Остается последний конфиг с описанием обработки данных. Тут начинается небольшая уличная магия, в которой я разбирался некоторое время. Расскажу ниже. Рисуем конфиг filter.conf.

filter {

if [type] == "nginx_access" {

grok {

match => { "message" => "%{IPORHOST:remote_ip} - %{DATA:user} \[%{HTTPDATE:access_time}\] \"%{WORD:http_method} %{DATA:url} HTTP/%{NUMBER:http_version}\" %{NUMBER:response_code} %{NUMBER:body_sent_bytes} \"%{DATA:referrer}\" \"%{DATA:agent}\"" }

}

}

date {

match => [ "timestamp" , "dd/MMM/YYYY:HH:mm:ss Z" ]

}

geoip {

source => "remote_ip"

target => "geoip"

add_tag => [ "nginx-geoip" ]

}

}

Первое, что делает этот фильтр, парсит логи nginx с помощью grok, если указан соответствующий тип логов, и выделяет из лога ключевые данные, которые записывает в определенные поля, чтобы потом с ними было удобно работать. С обработкой логов у новичков возникает недопонимание. В документации к filebeat хорошо описаны модули, идущие в комплекте, которые все это и так уже умеют делать из коробки, нужно только подключить соответствующий модуль.

Модули filebeat работают только в том случае, если вы отправляете данные напрямую в Elasticsearch. На него вы тоже ставите соответствующий плагин и получаете отформатированные данные с помощью elastic ingest. Но у нас работает промежуточное звено Logstash, который принимает данные. С ним плагины filebeat не работают, поэтому приходится отдельно в logstash парсить данные. Это не очень сложно, но тем не менее. Как я понимаю, это плата за удобства, которые дает logstash. Если у вас много разрозненных данных, то отправлять их напрямую в Elasticsearch не так удобно, как с использованием предобработки в Logstash.

Для фильтра grok, который использует Logstash, есть удобный дебаггер, где можно посмотреть, как будут парситься ваши данные. Покажу на примере одной строки из конфига nginx. Например, возьмем такую строку из лога:

180.163.220.100 - travvels.ru [05/Sep/2024:14:45:52 +0300] "GET /assets/galleries/26/1.png HTTP/1.1" 304 0 "https://travvels.ru/ru/glavnaya/" "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/50.0.2661.102 Safari/537.36"

И посмотрим, как ее распарсит правило grok, которое я использовал в конфиге выше.

%{IPORHOST:remote_ip} - %{DATA:user} \[%{HTTPDATE:access_time}\] \"%{WORD:http_method} %{DATA:url} HTTP/%{NUMBER:http_version}\" %{NUMBER:response_code} %{NUMBER:body_sent_bytes} \"%{DATA:referrer}\" \"%{DATA:agent}\"

Собственно, результат вы можете сами увидеть в дебаггере. Фильтр распарсит лог и на выходе сформирует json, где каждому значению будет присвоено свое поле, по которому потом удобно будет в Kibana строить отчеты и делать выборки. Только не забывайте про формат логов. Приведенное мной правило соответствует дефолтному формату main логов в nginx. Если вы каким-то образом модифицировали формат логов, внесите изменения в grok фильтр. Надеюсь понятно объяснил работу этого фильтра. Вы можете таким образом парсить любые логи и передавать их в еластикс. Потом на основе этих данных строить отчеты, графики, дашборды.

Дальше используется модуль date для того, чтобы выделять дату из поступающих логов и использовать ее в качестве даты документа в elasticsearch. Делается это для того, чтобы не возникало путаницы, если будут задержки с доставкой логов. В системе сообщения будут с одной датой, а внутри лога будет другая дата. Неудобно разбирать инциденты.

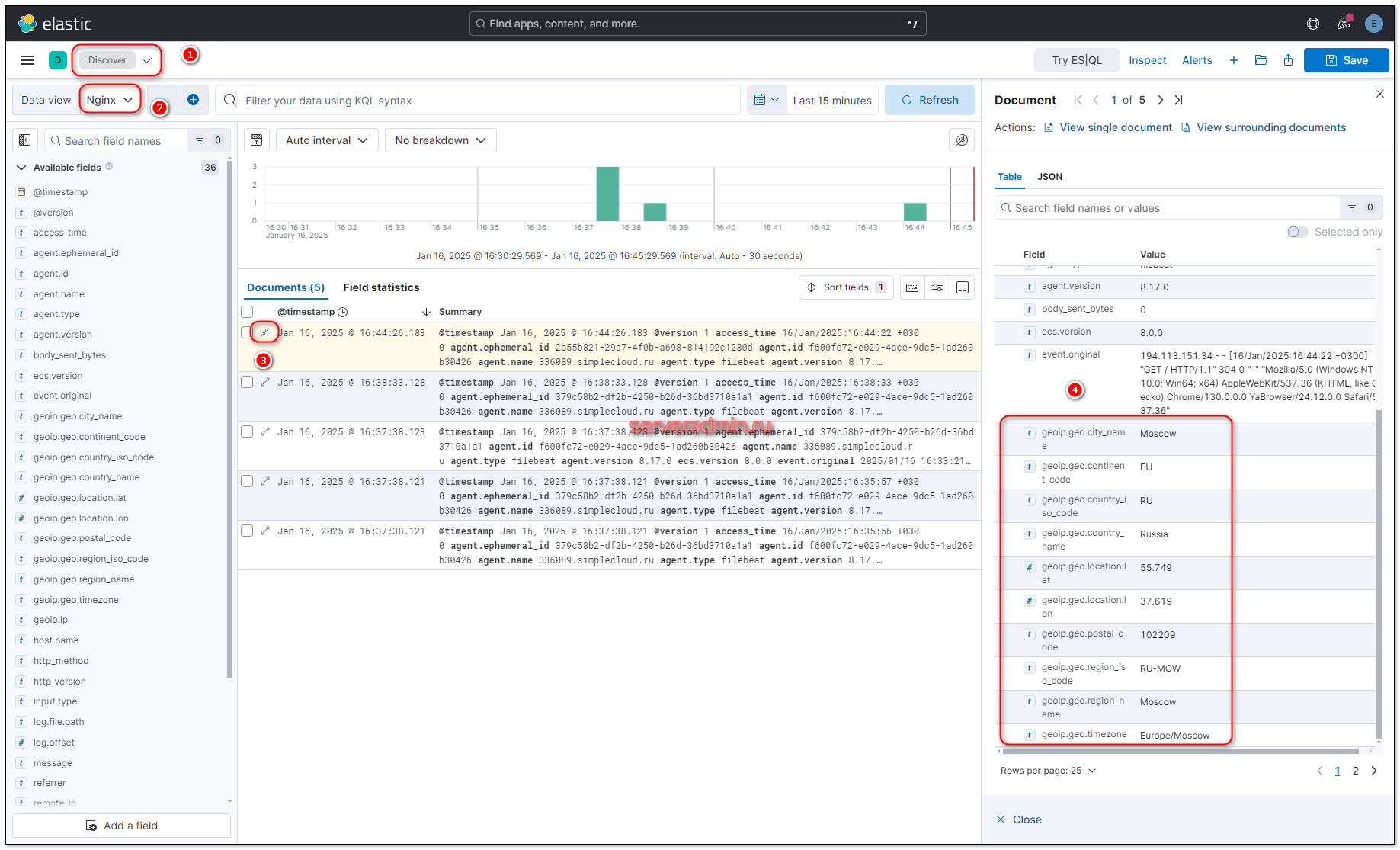

В конце я использую geoip фильтр, который на основе ip адреса, который мы получили ранее с помощью фильтра grok и записали в поле remote_ip, определяет географическое расположение. Он добавляет новые метки и записывает туда географические данные. Для его работы используется база данных из файла /var/lib/logstash/geoip_database_management/1737033914/GeoLite2-City.mmdb. Она будет установлена вместе с logstash. Впоследствии вы скорее всего захотите ее обновлять. Раньше она была доступна по прямой ссылке, но с 30-го декабря 2019 года правила изменились. База по-прежнему доступна бесплатно, но для загрузки нужна регистрация на сайте сервиса. Регистрируемся и качаем отсюда - https://dev.maxmind.com/geoip/geoip2/geolite2/#Download_Access. Передаем на сервер, распаковываем и копируем в /etc/logstash файл GeoLite2-City.mmdb. Теперь нам нужно в настройках модуля geoip указать путь к файлу с базой. Добавляем в /etc/logstash/conf.d/filter.conf:

geoip {

database => "/etc/logstash/GeoLite2-City.mmdb"

source => "remote_ip"

target => "geoip"

add_tag => [ "nginx-geoip" ]

}

Закончили настройку logstash. Запускаем его:

# systemctl start logstash.service

Можете проверить на всякий случай лог /var/log/logstash/logstash-plain.log, чтобы убедиться в том, что все в порядке. Признаком того, что скачанная geoip база успешно добавлена будет вот эта строчка в логе:

[2021-10-18T12:52:07,118][INFO ][logstash.filters.geoip ][main] Using geoip database {:path=>"/etc/logstash/GeoLite2-City.mmdb"}

Теперь настроим агенты для отправки данных.

Установка Filebeat для отправки логов в Logstash

Установим первого агента Filebeat на сервер с nginx для отправки логов веб сервера на сервер с ELK. Ставить можно как из общего репозитория, который мы подключали ранее, так и по отдельности пакеты. Как ставить - решать вам. В первом случае придется на все хосты добавлять репозиторий, но зато потом удобно обновлять пакеты. Если подключать репозиторий не хочется, можно просто скачать пакет и установить его. Ставим на Centos.

# curl -L -O https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-8.5.2-x86_64.rpm # rpm -ivh filebeat-8.5.2-x86_64.rpm

В Debian, Ubuntu ставим так:

# curl -L -O https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-8.5.2-amd64.deb # dpkg -i filebeat-8.5.2-amd64.deb

Или просто:

# yum install filebeat # apt install filebeat

После установки рисуем примерно такой конфиг /etc/filebeat/filebeat.yml для отправки логов в logstash.

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/nginx/*-access.log

fields:

type: nginx_access

fields_under_root: true

scan_frequency: 5s

- type: log

enabled: true

paths:

- /var/log/nginx/*-error.log

fields:

type: nginx_error

fields_under_root: true

scan_frequency: 5s

output.logstash:

hosts: ["10.1.4.114:5044"]

xpack.monitoring:

enabled: true

elasticsearch:

hosts: ["http://10.1.4.114:9200"]

Некоторые пояснения к конфигу, так как он не совсем дефолтный и минималистичный. Я его немного модифицировал для удобства. Во-первых, я разделил логи access и error с помощью отдельного поля type, куда записываю соответствующий тип лога: nginx_access или nginx_error. В зависимости от типа меняются правила обработки в logstash.

Запускаем filebeat и добавляем в автозагрузку.

# systemctl enable --now filebeat

Проверяйте логи filebeat в дефолтном системном логе. По умолчанию, он всё пишет туда. Лог весьма информативен. Если все в порядке, увидите список всех логов в директории /var/log/nginx, которые нашел filebeat по маске и начал готовить к отправке. Это события будут от подсистемы input.harvester. Не забудьте проверить свою маску, соответствует ли она той, что указана у меня в конфигурации.

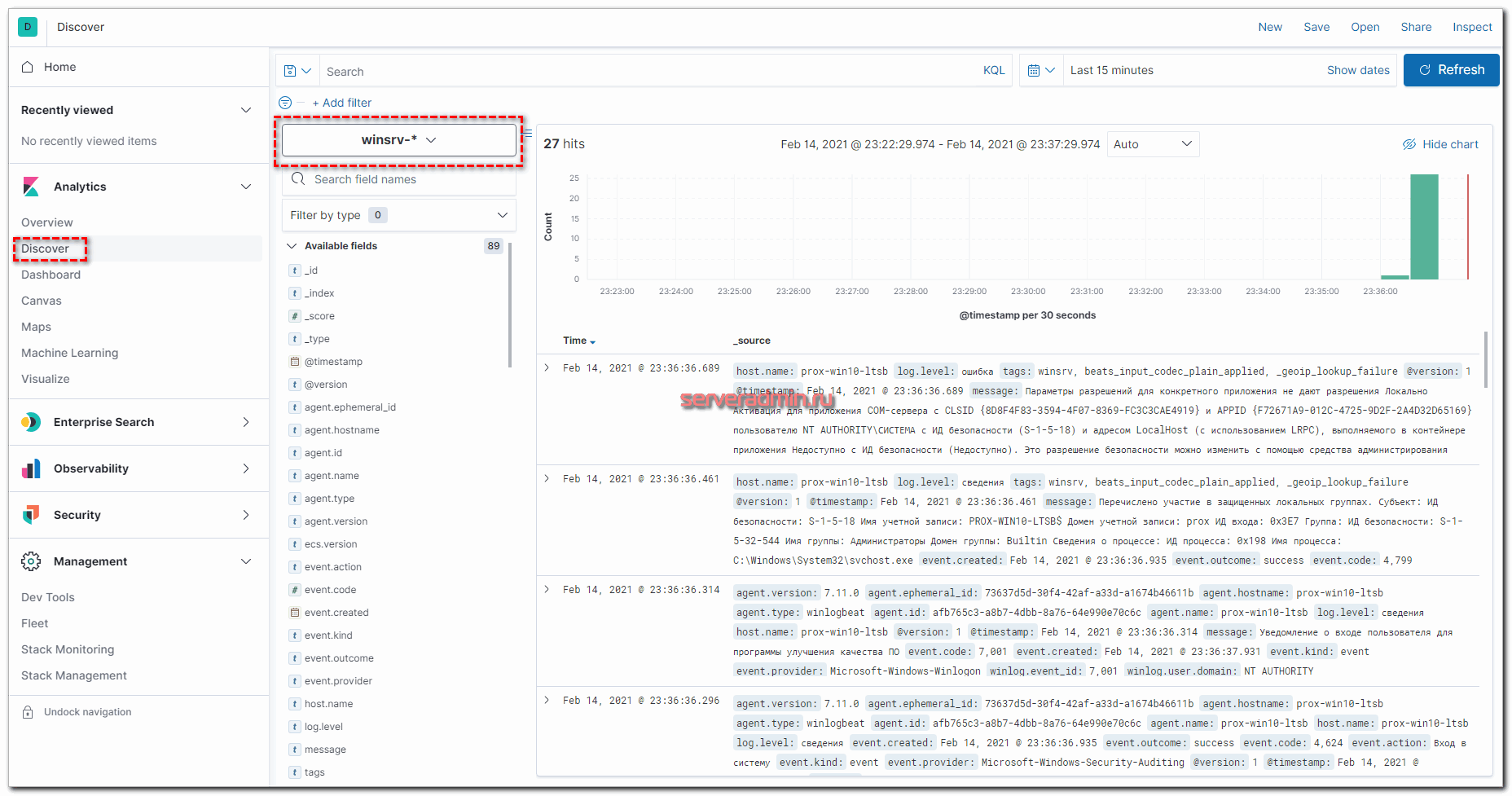

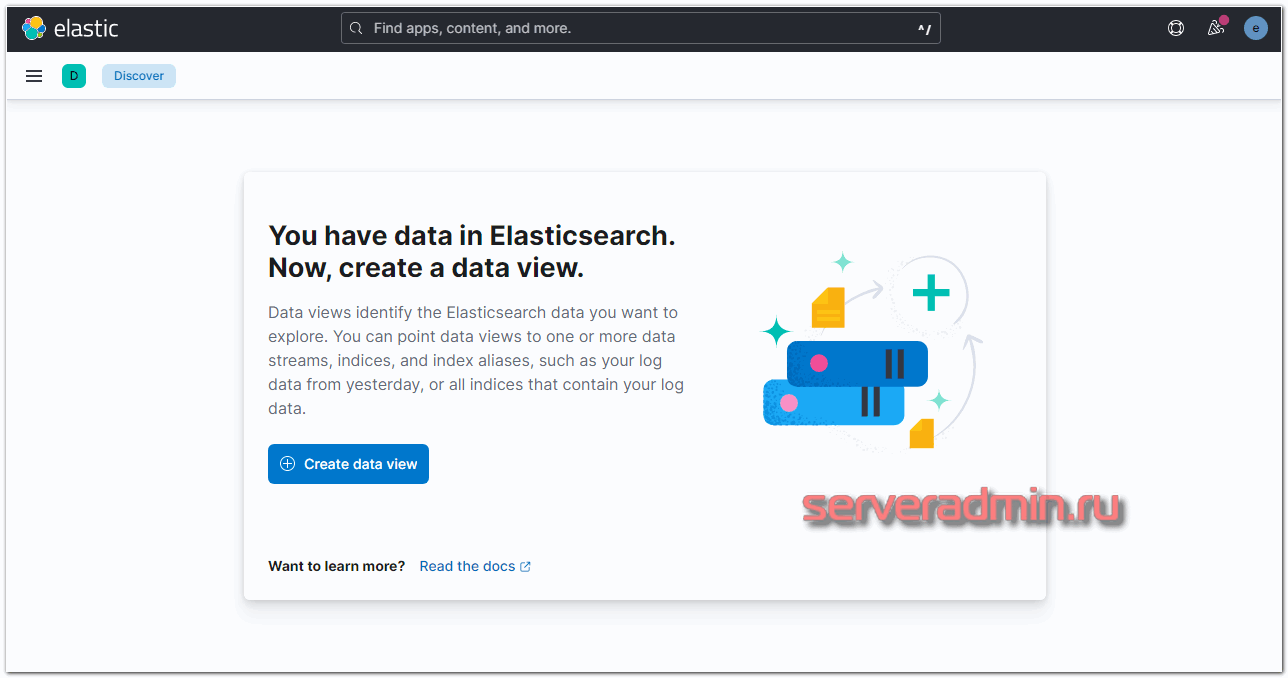

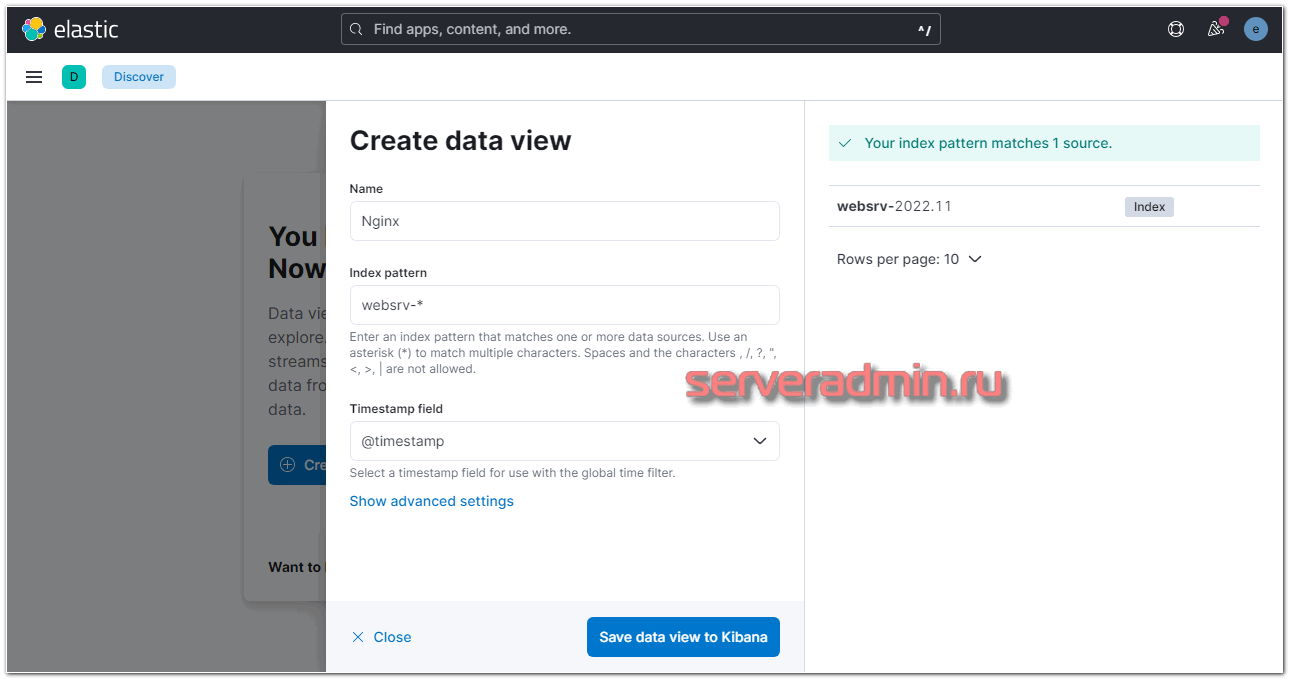

Если все сделали правильно, то данные уже потекли в elasticsearch. Мы их можем посмотреть в Kibana. Для этого открываем web интерфейс и переходим в раздел Discover. Так как там еще нет представления для нового индекса, нам предложат его добавить. Нажимайте Create data view.

Вы должны увидеть индекс, который начал заливать logstash в elasticsearch. В поле Index pattern введите websrv-* . Выберите имя поля для временного фильтра. У вас будет только один вариант - @timestamp, выбирайте его и жмите Save data view to Kibana.

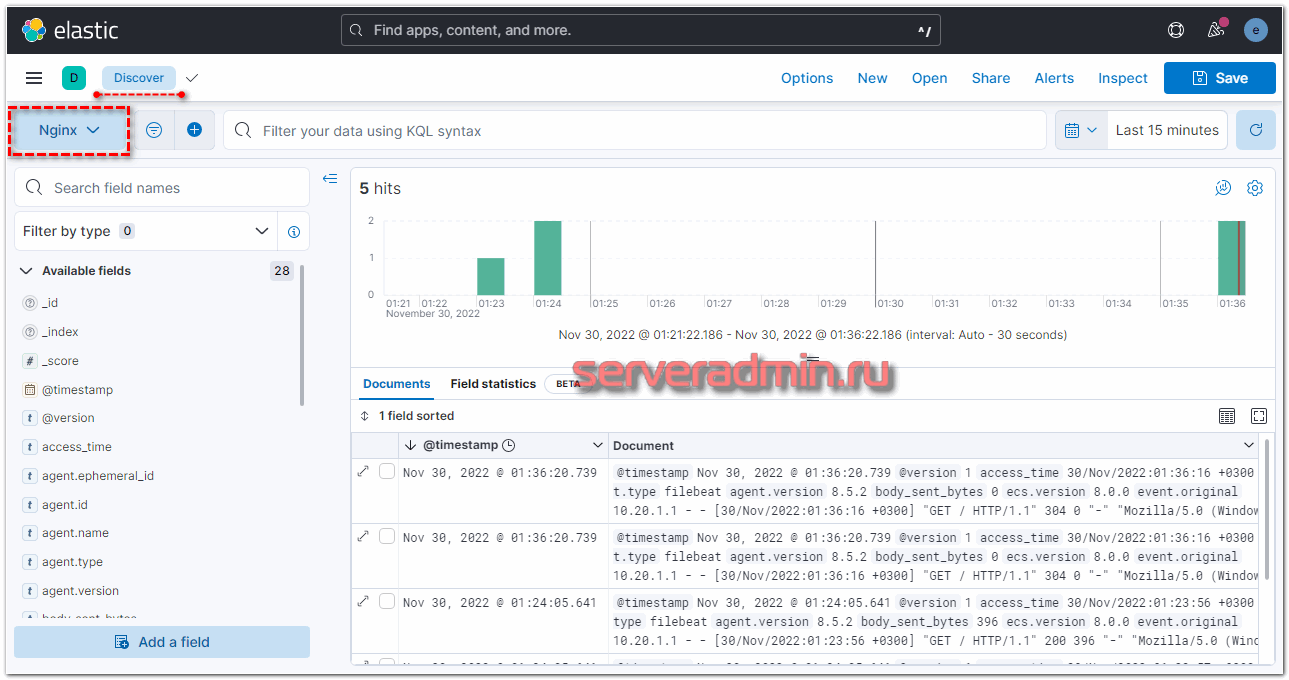

Новый индекс добавлен. Теперь при переходе в раздел Discover, он будет открываться по умолчанию со всеми данными, которые в него поступают.

Разворачиваем какую-то запись и смотрим подробности. В том числе работу модуля geoip.

По всем перечисленным полям можно делать поиск, выборки, строить дашборды и т.д.

Получение логов с веб сервера nginx на Linux настроили. Подобным образом настраивается сбор и анализ любых логов. Можно либо самим писать фильтры для парсинга с помощью grok, либо брать готовые. Вот несколько моих примеров по этой теме:

- Мониторинг производительности бэкенда с помощью ELK Stack

- Сбор и анализ логов samba в ELK Stack

- Дашборд для логов nginx

Теперь сделаем то же самое для журналов windows.

Установка и настройка Winlogbeat

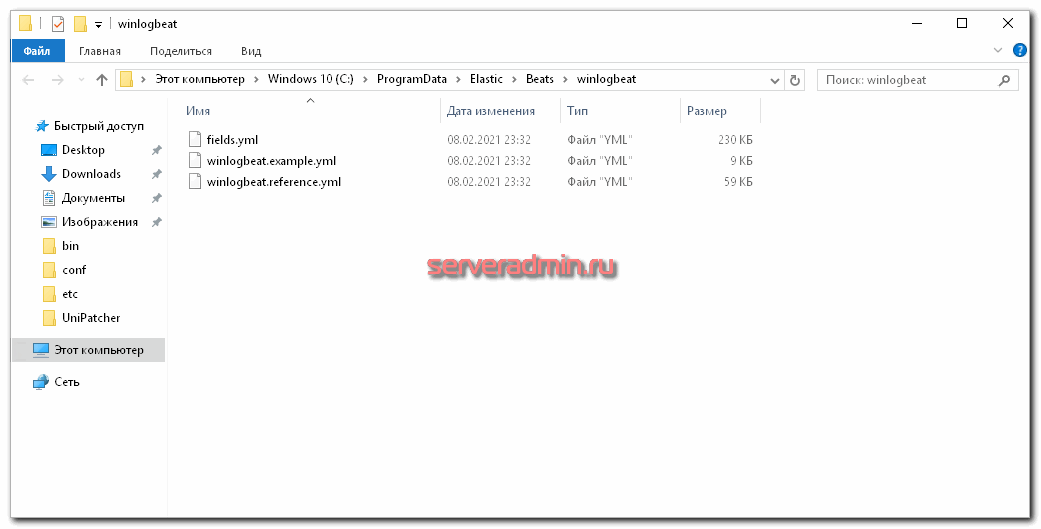

Для настройки централизованного сервера сбора логов с Windows серверов, установим сборщика системных логов winlogbeat. Для этого скачаем его и установим в качестве службы. Идем на страницу загрузок и скачиваем msi версию под вашу архитектуру - 32 или 64 бита. Запускаем инсталлятор и в конце выбираем открытие директории по умолчанию.

Создаем и правим конфигурационный файл winlogbeat.yml. Я его привел к такому виду:

Создаем и правим конфигурационный файл winlogbeat.yml. Я его привел к такому виду:

winlogbeat.event_logs:

- name: Application

ignore_older: 72h

- name: Security

- name: System

tags: ["winsrv"]

output.logstash:

hosts: ["10.20.1.56:5044"]

logging.level: info

logging.to_files: true

logging.files:

path: C:/ProgramData/Elastic/Beats/winlogbeat

name: winlogbeat.log

keepfiles: 7

В принципе, по тексту все понятно. Я беру 3 системных лога Application, Security, System (для русской версии используются такие же названия) и отправляю их на сервер с logstash. Настраиваю хранение логов. Отдельно обращаю внимание на tags: ["winsrv"]. Этим тэгом я помечаю все отправляемые сообщения, чтобы потом их обработать в logstash и отправить в elasticsearch с отдельным индексом. Я не смог использовать поле type, по аналогии с filebeat, потому что в winlogbeat в поле type жестко прописано wineventlog и изменить его нельзя. Если у вас данные со всех серверов будут идти в один индекс, то можно tag не добавлять, а использовать указанное поле type для сортировки. Если же вы данные с разных серверов хотите помещать в разные индексы, то разделяйте их тэгами. Для того, чтобы логи виндовых журналов пошли в elasticsearch не в одну кучу вместе с nginx логами, нам надо настроить для них отдельный индекс в logstash в разделе output. Идем на сервер с logstash и правим конфиг output.conf.

output {

if [type] == "nginx_access" {

elasticsearch {

hosts => "https://localhost:9200"

index => "nginx-%{+YYYY.MM.dd}"

}

}

else if [type] == "nginx_error" {

elasticsearch {

hosts => "https://localhost:9200"

index => "nginx-%{+YYYY.MM.dd}"

}

}

else if "winsrv" in [tags] {

elasticsearch {

hosts => "https://localhost:9200"

index => "winsrv-%{+YYYY.MM.dd}"

}

}

else {

elasticsearch {

hosts => "https://localhost:9200"

index => "unknown_messages"

}

}

}

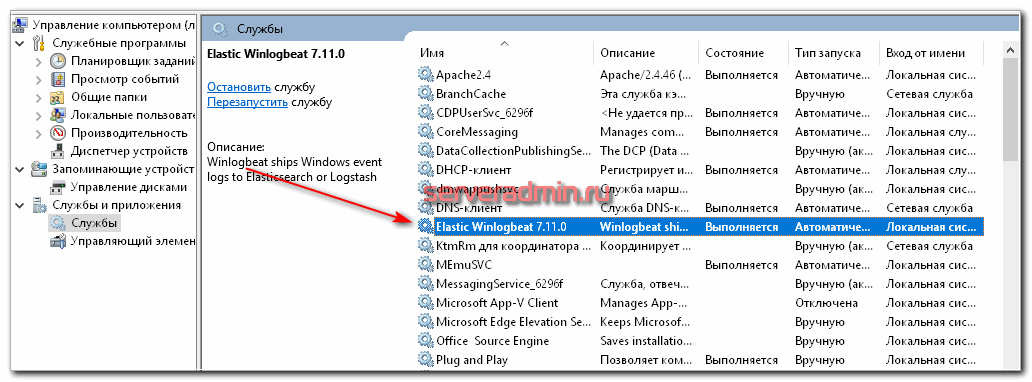

Думаю, по тексту понятен смысл. Я разделил по разным индексам логи nginx, системные логи виндовых серверов и добавил отдельный индекс unknown_messages, в который будет попадать все то, что не попало в предыдущие. Это просто задел на будущее, когда конфигурация будет более сложная, можно будет ловить сообщения, которые по какой-то причине не попали ни в одно из приведенных выше правил. Я не смог в одно правило поместить оба типа nginx_error и nginx_access, потому что не понял сходу, как это правильно записать, а по документации уже устал лазить, выискивать информацию. Так получился рабочий вариант. После этого перезапустил logstash и пошел на windows сервер, запустил службу Elastic Winlogbeat.

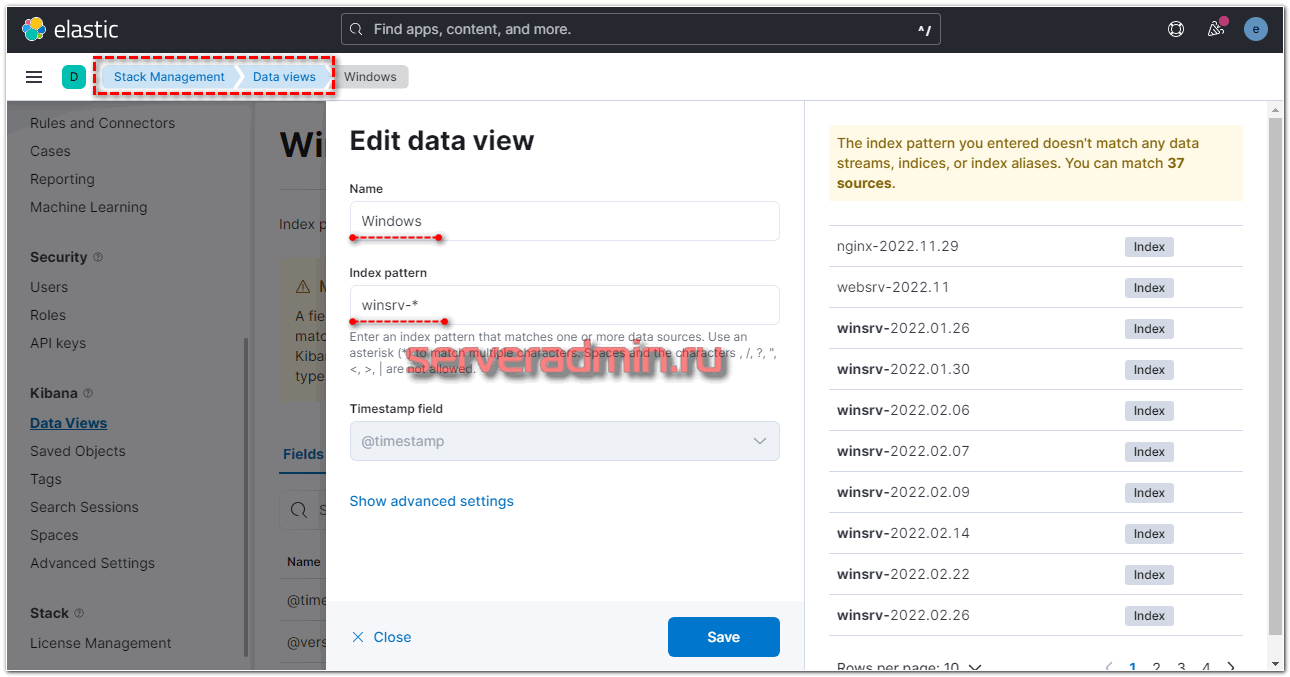

Подождал немного, пока появятся новые логи на виндовом сервере, зашел в Kibana и добавил новые data views. Напомню, что делается это в разделе Stack Management -> Data views. Добавляем новый вид по маске winsrv-*.

Можно идти в раздел Discover и просматривать логи с Windows серверов.

У меня без проблем всё заработало в том числе на серверах с русской версией Windows. Все логи, тексты в сообщениях на русском языке нормально обрабатываются и отображаются. Проблем не возникло нигде. На этом я закончил настройку ELK стека из Elasticsearch, Logstash, Kibana, Filebeat и Winlogbeat. Описал основной функционал по сбору логов. Дальше с ними уже можно работать по ситуации - строить графики, отчеты, собирать дашборды и т.д. В отдельном разделе ELK Stack у меня много примеров на этот счет.

Настройка безопасности и авторизация в Kibana

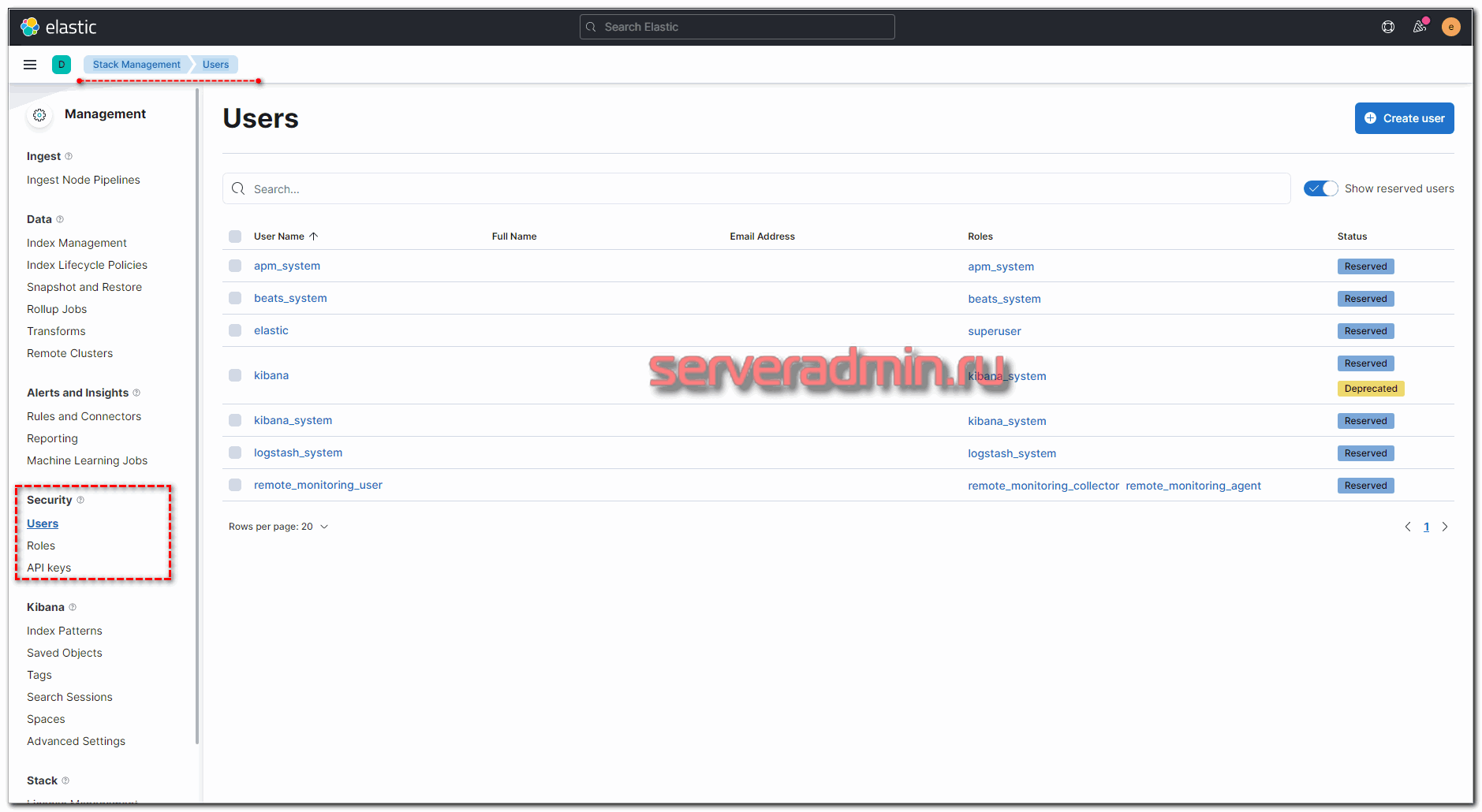

Мы настроили по умолчанию доступ в Kibana по паролю. Управлять пользователями и ролями можно через веб интерфейс. Делается это в разделе Stack Management -> Users. Там можно как отредактировать встроенные учетные записи, так и добавить новые.

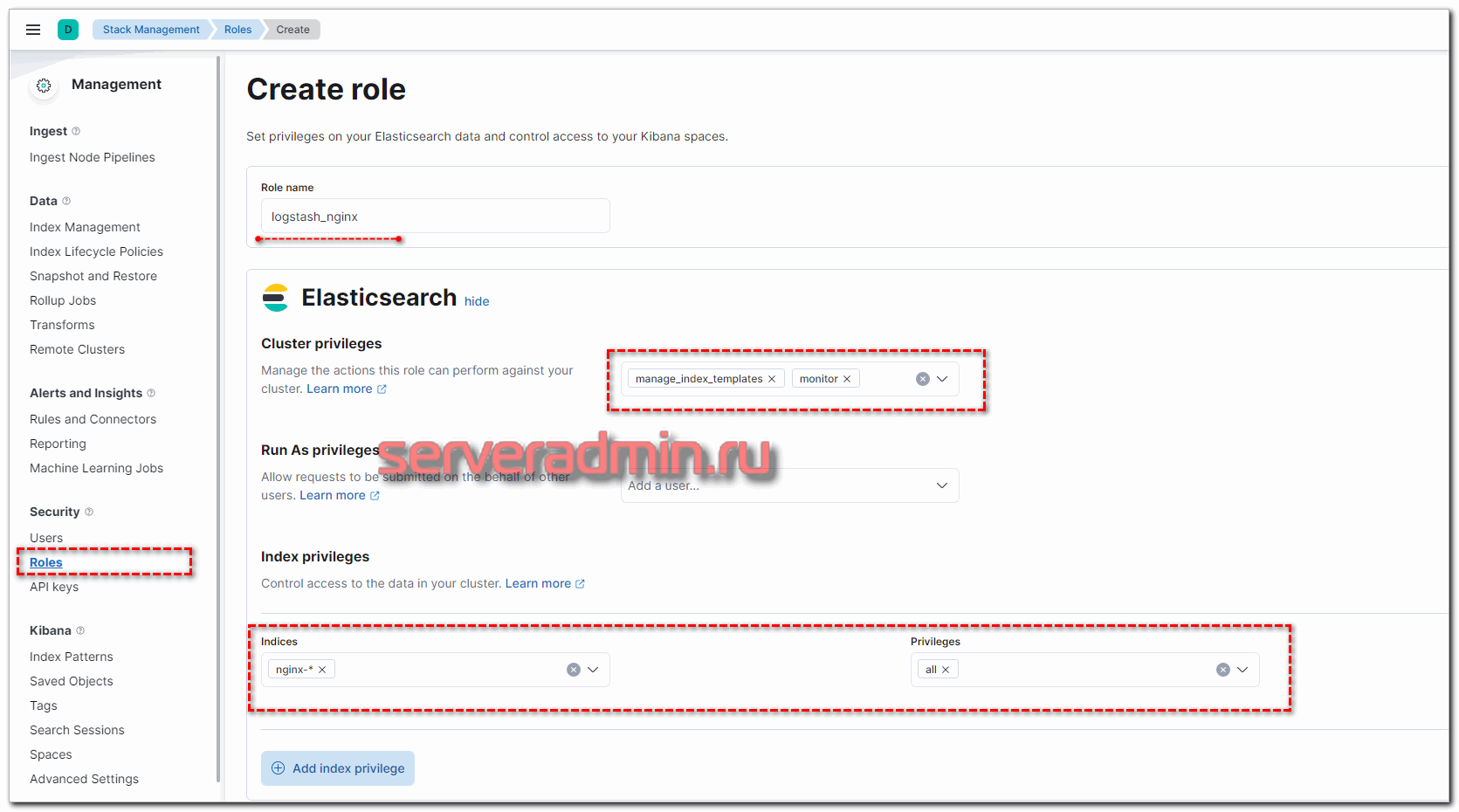

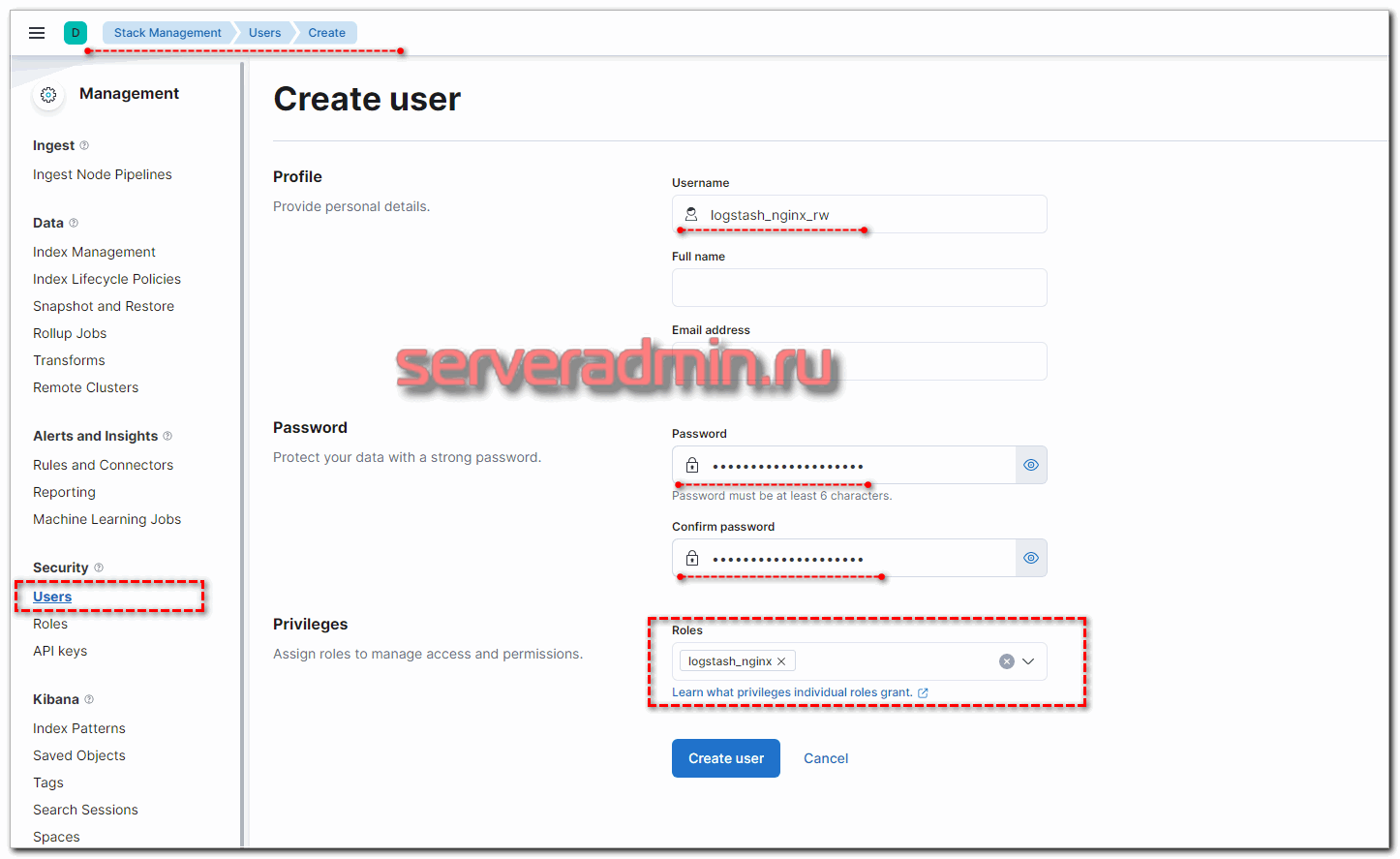

Сделаем это на примере пользователя для Logstash. Создадим отдельного юзера с правами на запись в нужные нам индексы. Для этого сначала создадим роль с соответствующими правами. Переходим в Roles и добавляем новую.

Набор индексов и права доступа к ним вы можете выбрать те, что вам нужны. Можно разделить доступ: одни могут только писать данные, другие удалять и т.д. После создания роли, добавьте пользователя и добавьте ему созданную ранее роль.

Теперь нам нужно настроить Logstash для аутентификации в кластере. Если это ещё не сделано, он не может отправлять данные. В логе у него будут ошибки, которые явно не указывают, в чем проблема, но мы это знаем и так.

[ERROR][logstash.outputs.elasticsearch][main][f8cdb7a9c640d0ed412a776071b8530fd5c0011075712a1979bee6c58b4c1d9f] Encountered a retryable error (will retry with exponential backoff) {:code=>401, :url=>"http://localhost:9200/_bulk", :content_length=>2862}

Открываем конфиг logstash, отвечающий за output и добавляем туда учетные данные для доступа в кластер. Выглядеть это будет примерно так:

output {

elasticsearch {

user => "logstash_nginx_rw"

password => "gdhsgfadsfsdfgsfdget45t"

hosts => "https://localhost:9200"

index => "nginx-%{+YYYY.MM.dd}"

cacert => "/etc/logstash/certs/http_ca.crt"

}

}

После этого данные как и прежде начнут поступать из logstash в elasticsearch, только теперь уже с аутентификацией по пользователю и паролю.

Проксирование подключений к Kibana через Nginx

Я не буду подробно рассказывать о том, что такое проксирование в Nginx. У меня есть отдельная статья на эту тему - настройка proxy_pass в nginx. Приведу просто пример конфига для передачи запросов с Nginx в Kibana. Я рекомендую использовать ssl сертификаты для доступа к Kibana. Даже если в этом нет объективной необходимости, надоедают уведомления браузеров о том, что у вас небезопасное подключение. Подробная инструкция по установке, настройке и использованию ssl в nginx так же есть у меня на сайте - настройка web сервера nginx. Все подробности настройки Nginx смотрите там. Вот примерный конфиг nginx для проксирования запросов к Kibana с ограничением доступа по паролю:

server {

listen 443;

server_name kibana.site.ru;

ssl_certificate /etc/letsencrypt/live/kibana.site.ru/fullchain.pem;

ssl_certificate_key /etc/letsencrypt/live/kibana.site.ru/privkey.pem;

location / {

auth_basic "Restricted Access";

auth_basic_user_file /etc/nginx/htpasswd.kibana;

proxy_pass http://localhost:5601;

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection 'upgrade';

proxy_set_header Host $host;

proxy_cache_bypass $http_upgrade;

}

}

Создаем файл для пользователей и паролей:

# htpasswd -c /etc/nginx/htpasswd.kibana kibanauser

Если утилиты htpasswd нет в системе, то установите ее:

# dnf install httpd-tools

# apt install apache2-utils

После этого выйдет запрос на ввод пароля. С помощью приведенной выше команды мы создали файл с информацией о пользователе и пароле kibanauser для ограничения доступа к web панели Кибана. Если у вас настроена внутренняя авторизация в Kibana, то большого смысла делать примерно то же самое через Nginx нет. Но это на ваше усмотрение. Auth_basic позволяет полностью скрыть информацию о том, какой сервис находится за аутентификацией, что может быть очень актуально при прямом доступе к Kibana из интернета.

Автоматическая очистка индексов в Elasticsearch

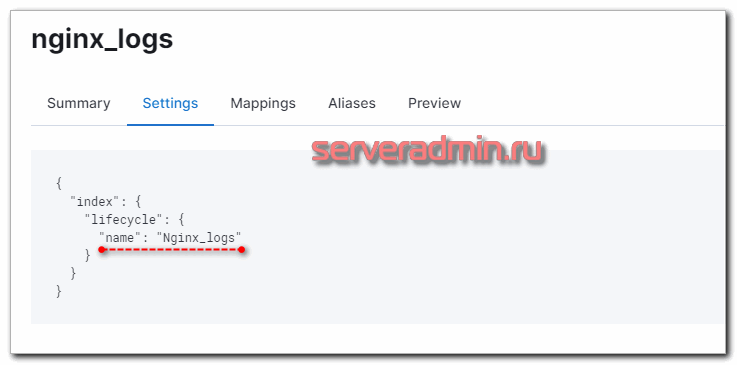

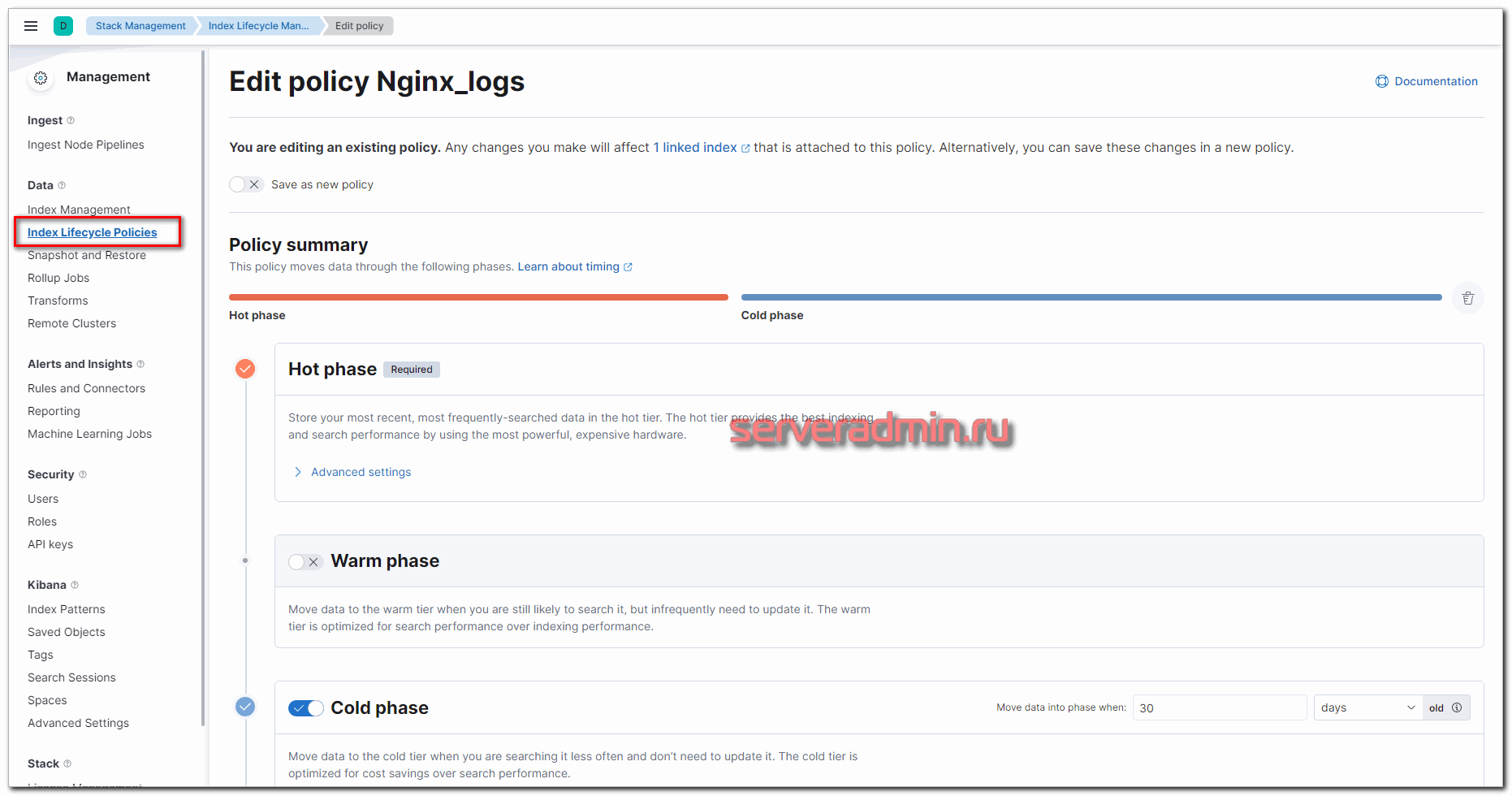

Некоторое время назад для автоматической очистки индексов в Elasticsearch необходимо было прибегать к помощи сторонних продуктов. Наиболее популярным был Curator. Сейчас в Kibana есть встроенный инструмент для очистки данных - Index Lifecycle Policies. Его не трудно настроить самостоятельно, хотя и не могу сказать, что там всё очевидно. Есть некоторые нюансы, так что я по шагам расскажу, как это сделать. Для примера возьму всё тот же индекс nginx-*, который использовал ранее в статье.

Настроим срок жизни индексов следующим образом:

- Первые 30 дней - Hot phase. В этом режиме индексы активны, в них пишутся новые данные.

- После 30-ти дней - Cold phase. В этой фазе в индексы невозможна запись новых данных. Запросы к этим данным имеют низкий приоритет.

- Все, что старше 90 дней удаляется.

Чтобы реализовать эту схему хранения данных, идем в раздел Stack Management -> Index Lifecycle Management и добавляем новую политику. Я её назвал Nginx_logs. Выставляем параметры фаз в соответствии с заданными требованиями.

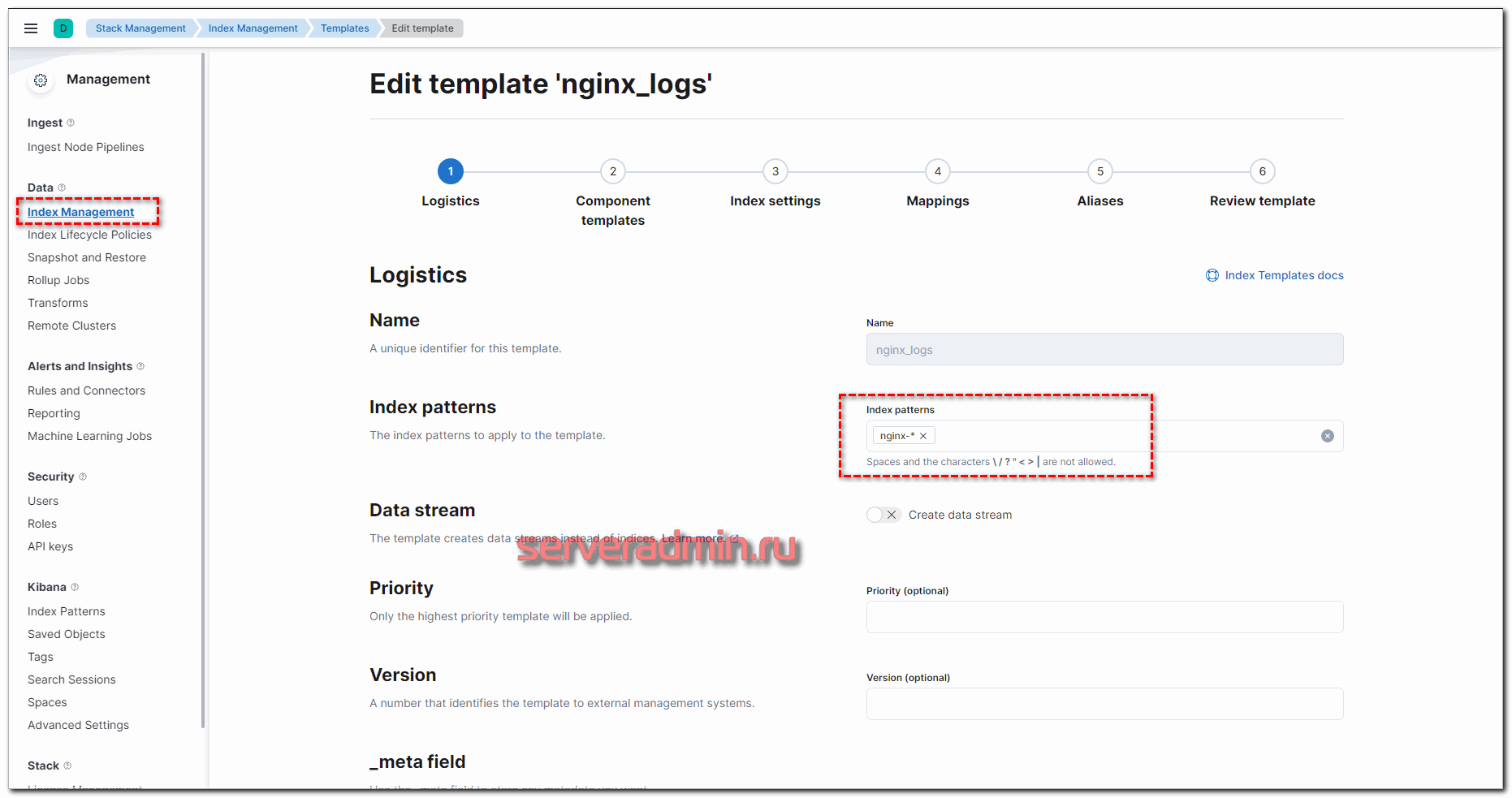

Не уместилось полное изображение настроек, но, думаю, вы там сами разберётесь, что выбрать. Ничего сложного тут нет. Далее нам нужно назначить новую политику хранения данных к индексам. Для этого переходим в Index Management -> Index Templates и добавляем новый индекс. В качестве шаблона укажите nginx-*, все остальные параметры можно оставить дефолтными.

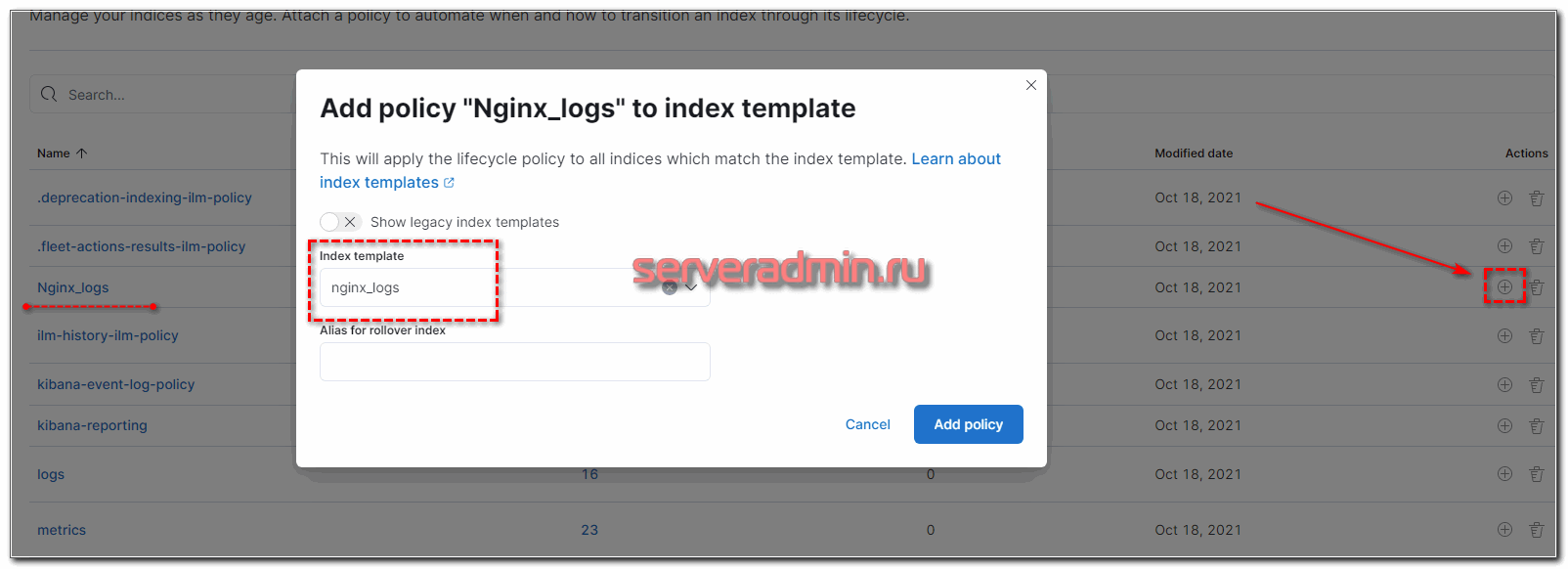

Теперь возвращаемся в Index Lifecycle Policies, напротив нашей политики нажимаем на + и выбираем только что созданный шаблон.

Проверяем свойства шаблона и убеждаемся в том, что Lifecycle Policies применилась.

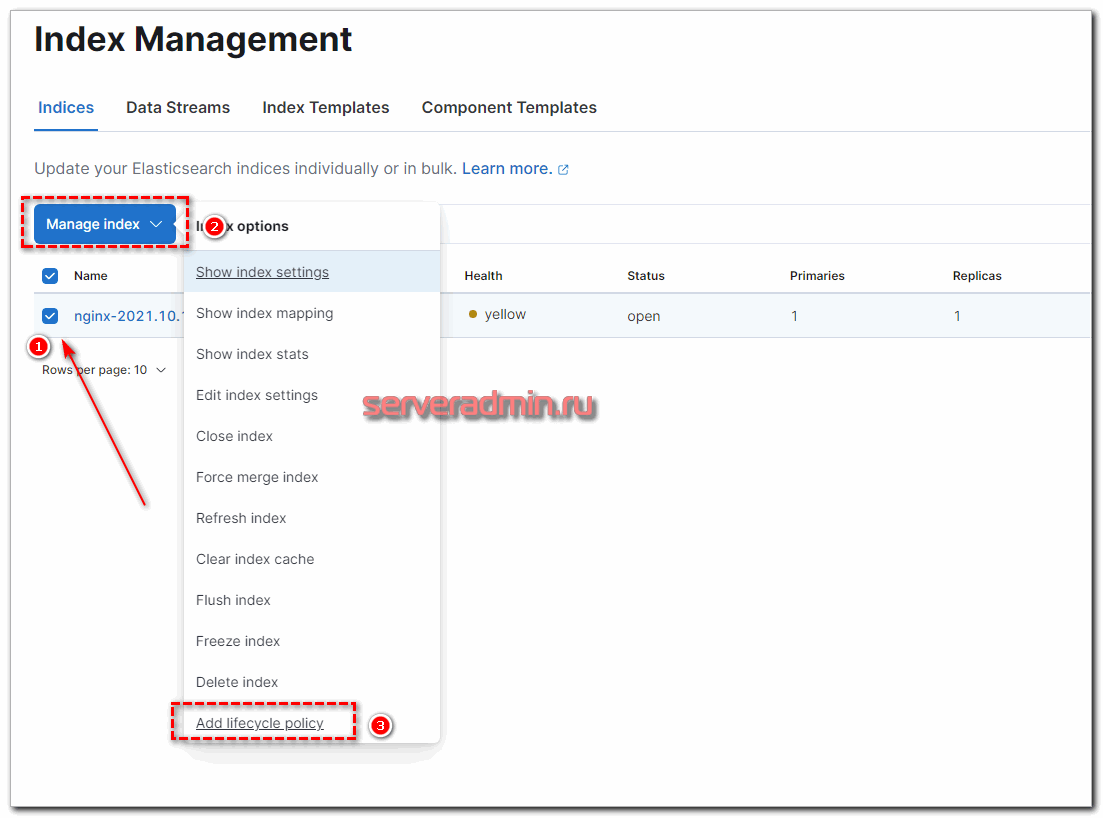

Теперь ко всем новым индексам, созданным по этому шаблону, будет применяться политика хранения данных. Для уже существующих это нужно проделать вручную. Достаточно выбрать нужный индекс и в выпадающем списке с опциями выбрать нужное действие.

Такими несложными действиями можно настроить автоматическую очистку индексов встроенными инструментами Elasticsearch и Kibana. В некоторых случаях быстрее и удобнее воспользоваться Curator, особенно если нужно быстро реализовать много разных схем. Единый конфиг куратора выглядит более наглядным, но это уже вкусовщина и от ситуации зависит.

Часто задаваемые вопросы по теме статьи (FAQ)

Да, можно. Наиболее популярными заменами Filebeat является Fluentd и Vector. Они более функциональны и производительны. В некоторых случаях могут брать на себя часть функциональности по начально обработке данных. В итоге можно отказаться от Logstash.

Да, если вы просто собираете логи, без предварительной обработки и изменений, можно отправлять данные напрямую в Elasticsearch. На нем их так же можно обработать с помощью grok фильтра в elastic node. Вариант рабочий, но не такой функциональный, как Logstash.

Да, есть такой механизм - Index Lifecycle Policies, который требует отдельной настройки в Kibana. Также можно использовать сторонний софт. Пример такого софта - curator.

Проще всего использовать для этого Nginx в режиме proxy_pass. С его помощью можно без проблем подключить бесплатные сертификаты от Let's Encrypt. В Kibana можно подключить готовые сертификаты через набор параметров server.ssl, но отдельно придётся решать вопрос их обновления и перезапуска службы после этого события.

Начать настройку можно с 2CPU и 6Gb RAM. Но для более-менее комфортной работы желательно 8Gb RAM.

Заключение

Я постарался рассказать подробно и понятно о полной настройке ELK Stack. Информацию в основном почерпнул в официальной документации. Мне не попалось более ли менее подробных статей ни в рунете, ни в буржунете, хотя искал я основательно. Вроде бы такой популярный и эффективный инструмент, но статей больше чем просто дефолтная установка я почти не видел.

В эксплуатации подобного стэка много нюансов. Например, если отказаться от Logstash и отправлять данные с beats напрямую в Elasticsearch, то на первый взгляд все становится проще. Штатные модули beats сами парсят вывод, устанавливают готовые визуализации и дашборды в Kibana. Вам остается только зайти и любоваться красотой. Но на деле всё выходит не так красиво, как хотелось бы. Кастомизация конфигурации усложняется. Изменение полей в логах приводит к более сложным настройкам по вводу этих изменений в систему. Все настройки поступающей информации переносятся на каждый beats, изменяются в конфигах отдельных агентов. Это неудобно.

В то же время, при использовании Logstash, вы просто отправляете данные со всех beats на него и уже в одном месте всем управляете, распределяете индексы, меняете поля и т.д. Все настройки перемещаются в одно место. Это более удобный подход. Плюс, при большой нагрузке вы можете вынести Logstash на отдельную машину.

Я не рассмотрел в своей статье такие моменты как создание визуализаций и дашбордов в Kibana, так как материал уже и так получился объемный. Мне стало трудно всё это увязывать в одном месте. Смотрите остальные мои материалы по данной теме. Там есть примеры. Также я не рассмотрел такой момент. Logstash может принимать данные напрямую от syslog. Вы можете, к примеру, в Nginx настроить отправку логов в syslog, минуя файлы и beats. Это может быть более удобно, чем описанная мной схема. Особенно это актуально для сбора логов с различных сетевых устройств, на которые невозможно поставить агента, например Mikrotik. Syslog поток также можно парсить на ходу с помощью grok.

Подводя итог скажу, что с этой системой хранения логов нужно очень вдумчиво и внимательно разбираться. С наскока ее не осилить. Чтобы было удобно пользоваться, нужно много всего настроить. Я описал только немного кастомизированный сбор данных, их визуализация - отдельный разговор. Сам я постоянно использую и изучаю систему, поэтому буду рад любым советам, замечаниям, интересным ссылкам и всему, что поможет освоить тему. Все статьи раздела elk stack - https://serveradmin.ru/category/elk-stack/.

На углубленном курсе "Архитектура современных компьютерных сетей" вы с нуля научитесь работать с Wireshark и «под микроскопом» изучите работу сетевых протоколов. На протяжении курса надо будет выполнить более пятидесяти лабораторных работ в Wireshark.

Реклама ИП Скоромнов Д.А. ИНН 331403723315

Server Admin Авторский блог системного администратора

Server Admin Авторский блог системного администратора

Добрый вечер. Похоже, что время пришло актуализировать статью. =)

Рисуем конфиг output.conf, который описывает передачу данных в Elasticsearch.

output {

elasticsearch {

hosts => "https://localhost:9200"

index => "websrv-%{+YYYY.MM}"

user => "elastic"

password => "ktNBdiTxO3hKqASVvHyu"

cacert => "/etc/logstash/certs/http_ca.crt" ... вместо cacert использовать ssl_certificate_authorities

}

}

Далее в разделе установки и настройки Winlogbeat

Идем на сервер с logstash и правим конфиг output.conf.

output {

if [type] == "nginx_access" {

elasticsearch {

hosts => "https://localhost:9200"

index => "nginx-%{+YYYY.MM.dd}"

}

}

else if [type] == "nginx_error" {

elasticsearch {

hosts => "https://localhost:9200"

index => "nginx-%{+YYYY.MM.dd}"

}

}

else if "winsrv" in [tags] {

elasticsearch {

hosts => "https://localhost:9200"

index => "winsrv-%{+YYYY.MM.dd}"

}

}

else {

elasticsearch {

hosts => "https://localhost:9200"

index => "unknown_messages"

}

}

}

Получается что из конфига output.conf пропадают следующие строки:

user => "elastic"

password => "ktNBdiTxO3hKqASVvHyu"

cacert => "/etc/logstash/certs/http_ca.crt"

Для меня не очевидно почему так происходит и как после этого заработает logstash, он же не сможет подключиться к elasticsearch без этих данных?

Не очень понял комментарий. Конструкция ниже из статьи больше не работает?

output {elasticsearch {

hosts => "https://localhost:9200"

index => "websrv-%{+YYYY.MM}"

user => "elastic"

password => "ktNBdiTxO3hKqASVvHyu"

cacert => "/etc/logstash/certs/http_ca.crt"

}

}

Верно в 9+ версии (свежая установка) вместо cacert используется ssl_certificate_authorities.

Из Вашей статьи в разделе установки и настройки Winlogbeat

Вы приводите пример отредактированного output.conf и в нем отсутствуют следующие строки:

user => "elastic"

password => "ktNBdiTxO3hKqASVvHyu"

cacert => "/etc/logstash/certs/http_ca.crt"

Собственно у меня возник вопрос:

Почему так происходит и как после этого заработает logstash, он же не сможет подключиться к elasticsearch без этих данных?

ДОБРЫЙ ДЕНЬ.

Обновите плз ключ для Debian 12

Вроде всё обновлено. Я на днях без проблем всё установил по статье на Debian 12.

Добрый день. Возможно у вас такая же проблема как и у меня была. Почему-то командой из статьи не скачивался .asc файл в папку trusted.gpg.d. Зашел туда и командой wget http://elasticrepo.serveradmin.ru/elastic.asc скачал файл, после этого update прошел и началась установка.

Можно и даже лучше будет использовать зеркало Яндекса:

https://mirror.yandex.ru/mirrors/elastic/

Я не замечал, либо его раньше не было.

Доброго времени суток!

По ходу ключ для репозитория под Debian 12 просрочился

pub rsa4096 2022-11-29 [SC] [просрочен с: 2024-11-28]

$$$$$$$$

uid [ просрочен ] elastic

Подскажите а важно какую версию Elasticsearch использовать для Debian 11? Можно брать самую последнюю (8.15.3)? И какую версию вы используете?

В каком плане важно? Вы можете использовать любую версию. Обычно во время установки берут самую свежую.

Думал может быть для Debian 12 нужно такую-то версию, а для Debian 11 другую версию. Первый раз просто знакомлюсь с этим стеком). Ох и сложный стек, я решил пропустить логирование nginx. Сразу установил на Windows Winlogbeat, вроде всё настроил по вашим примерам, но ничего нет в Kibana. Ну всё равно спасибо за статью, продолжу разбираться.

Владимир, можете пожалуйста выложить ваш конфиг filter.conf logstash с фильтрами для нескольких сервисов? Делаю по вашей статье, когда фильтр один, все работает. Но как только начинаю добавлять фильтры для других сервисов, например для микротика по второй вашей статье, logstash перестает запускаться ссылаясь на синтаксические ошибки.

Заранее спасибо.

Вот полный конфиг с одного из серверов. Ничего не правил:

https://pastebin.com/2U0SUWdE

Добрый день! не судите строго, опыта у меня не много, возник вопрос:

в конфиге logstash, во входящем трафике, если нужно использовать шифрование, то нужно выпускать отдельный сертификат для этого -pem формата и прописывать пути к *.cer и *.key? если нет, то подскажите пожалуйста, как должен выглядеть конфиг на вх трафик. Спасибо.

Если честно, не знаю. Не настраивал в logstash шифрованную передачу. Думаю, достаточно в конфигурации указать сертификат и ключ. В документации надо посмотреть, как это сделать. Не думаю, что там есть какие-то сложности.

Будем искать, спасибо)))

А чего там искать, вот оно: https://www.elastic.co/guide/en/logstash/8.13/plugins-inputs-elasticsearch.html Смотрим параметры с ssl. Вот пример конфига https://discuss.elastic.co/t/logstash-input-tcp-with-tls-and-handshake/70126

Добрый день,

ELK настроил два года назад для сбора логов с synology, работал проблем не было.

Захожу вчера там логи за 4 дня уже не пишутся.

Вылезает ошибка

190 of 490 shards failed

The data you are seeing might be incomplete or wrong.

no_shard_available_action_exception at shard 0index synology-2023.05.02

Подскажите пожалуйста как исправить?

В логах logstash нашел

[2024-04-03T15:44:21,323][INFO ][logstash.outputs.elasticsearch][main][ac6f3ec32f5738ab7bb4303613a937b9e788acf95f4cfeb11e592b9fa2935845] Failed to perform request {:message=>"Connect to localhost:9200 [localhost/127.0.0.1] failed: Connection refused (Connection refused)", :exception=>Manticore::SocketException, :cause=>org.apache.http.conn.HttpHostConnectException: Connect to localhost:9200 [localhost/127.0.0.1] failed: Connection refused (Connection refused)}

[2024-04-03T15:44:21,332][WARN ][logstash.outputs.elasticsearch][main][ac6f3ec32f5738ab7bb4303613a937b9e788acf95f4cfeb11e592b9fa2935845] Marking url as dead. Last error: [LogStash::Outputs::ElasticSearch::HttpClient::Pool::HostUnreachableError] Elasticsearch Unreachable: [http://localhost:9200/_bulk][Manticore::SocketException] Connect to localhost:9200 [localhost/127.0.0.1] failed: Connection refused (Connection refused) {:url=>http://logstash_rw:xxxxxx@localhost:9200/, :error_message=>"Elasticsearch Unreachable: [http://localhost:9200/_bulk][Manticore::SocketException] Connect to localhost:9200 [localhost/127.0.0.1] failed: Connection refused (Connection refused)", :error_class=>"LogStash::Outputs::ElasticSearch::HttpClient::Pool::HostUnreachableError"}

[2024-04-03T15:44:21,335][ERROR][logstash.outputs.elasticsearch][main][ac6f3ec32f5738ab7bb4303613a937b9e788acf95f4cfeb11e592b9fa2935845] Attempted to send a bulk request but Elasticsearch appears to be unreachable or down {:message=>"Elasticsearch Unreachable: [http://localhost:9200/_bulk][Manticore::SocketException] Connect to localhost:9200 [localhost/127.0.0.1] failed: Connection refused (Connection refused)", :exception=>LogStash::Outputs::ElasticSearch::HttpClient::Pool::HostUnreachableError, :will_retry_in_seconds=>2}

[2024-04-03T15:44:22,936][WARN ][logstash.outputs.elasticsearch][main] Attempted to resurrect connection to dead ES instance, but got an error {:url=>"http://logstash_rw:xxxxxx@localhost:9200/", :exception=>LogStash::Outputs::ElasticSearch::HttpClient::Pool::BadResponseCodeError, :message=>"Got response code '401' contacting Elasticsearch at URL 'http://localhost:9200/'"}

[2024-04-03T15:44:23,349][ERROR][logstash.outputs.elasticsearch][main][ac6f3ec32f5738ab7bb4303613a937b9e788acf95f4cfeb11e592b9fa2935845] Attempted to send a bulk request but there are no living connections in the pool (perhaps Elasticsearch is unreachable or down?) {:message=>"No Available connections", :exception=>LogStash::Outputs::ElasticSearch::HttpClient::Pool::NoConnectionAvailableError, :will_retry_in_seconds=>4}

[2024-04-03T15:44:27,353][ERROR][logstash.outputs.elasticsearch][main][ac6f3ec32f5738ab7bb4303613a937b9e788acf95f4cfeb11e592b9fa2935845] Attempted to send a bulk request but there are no living connections in the pool (perhaps Elasticsearch is unreachable or down?) {:message=>"No Available connections", :exception=>LogStash::Outputs::ElasticSearch::HttpClient::Pool::NoConnectionAvailableError, :will_retry_in_seconds=>8}

[2024-04-03T15:44:28,095][WARN ][logstash.outputs.elasticsearch][main] Restored connection to ES instance {:url=>"http://logstash_rw:xxxxxx@localhost:9200/"}

Менял пароль пользователя не помогло.

Гуглить ошибку и пробовать предложенные решения. Я бы начал с того, что перезапустил elasticsearch. Потом удалил индекс, на который ругается ошибка в логе, если этот индекс уже не нужен. Возможно на сервере в какой-то момент место закончилось. В общем, тут надо разбираться и пробовать разные решения.

Zerox, подскажите.

Нужно зайти в Index Management и удалить там ?

Вот тут рассказано, как это делать:

https://www.elastic.co/guide/en/elasticsearch/reference/current/indices-delete-index.html

Может кому то пригодится.

Удалил индексы за 2022 год в Index Management и все само собой заработало.

80гб было свободно из 100гб на hdd.

Добрый день. Не подскажете, почему в списке индексов не появляется из output.conf?

присутствует только metrics-endpoint.metadata_current_default

Где-то ошибка, вероятно. Что я ещё могу сказать заочно? Смотрите логи при отправке и на приёме. Судя по всему данные не идут, раз индекс не создаётся. Он в момент поступления первых данных будет создан.

почему то середина неверно вставилась из-за EOF, переписал

из-за блокировки ELK ip адресов из России kibana при попытке посмотреть доступные интеграции начинает зависать, для решения этой проблемы и возможности использовать интеграции elk необходимо развернуть сервис Elastic Package Registry затем собрать из исходников пакеты интеграций и поместить их в локальные хранилище.

все сборки я проводил на debian 12 под root

сначала соберем Elastic Package Registry и сделаем unit

https://github.com/elastic/package-registry

соберем упаковщик пакетов интеграций ELK

https://github.com/elastic/elastic-package

c помощью упаковшика соберем пакеты интеграций и поместим в локальное хранилище

https://github.com/elastic/integrations

Нам понадобится версия go 1.21.4 или выше, у меня установлена 1.19 обновляем ее

apt update && apt upgrade -y

go version #если не стала нужной версии удаляем

apt remove golang -y && apt autoremove -y

cd ~

качаем go https://go.dev/doc/install и установим

wget https://go.dev/dl/go1.21.5.linux-amd64.tar.gz

rm -rf /usr/local/go && tar -C /usr/local -xzf go1.21.5.linux-amd64.tar.gz

rm go1.21.5.linux-amd64.tar.gz

echo export PATH=$PATH:/usr/local/go/bin >> /root/.bashrc && source /root/.bashrc

go version

установим зависимости

apt update && apt install -y media-types zip rsync curl

качаем репозиторий

git clone https://github.com/elastic/package-registry

собираем

cd /root/package-registry/

go build .

создаем каталога для конфига и локального хранилища

mkdir /etc/package-registry

mkdir /opt/local-storage

копируем bin , конфиг , один тестовый пакет без него не запустится package-registry

cp /root/package-registry/package-registry /usr/bin/package-registry

cp "/root/package-registry/testdata/local-storage/nodirentries-1.0.0.zip" "/opt/local-storage/nodirentries-1.0.0.zip"

nano /etc/package-registry/config.yml

package_paths:

- /opt/local-storage/

создаем Unit

nano /etc/systemd/system/package-registry.service

[Unit]

Description=Elastic package-registry.

[Service]

StartLimitInterval=5

StartLimitBurst=10

ExecStart=/usr/bin/package-registry --config /etc/package-registry/config.yml

Restart=always

KillMode=process

RestartSec=120

[Install]

WantedBy=multi-user.target

включаем сервис

systemctl enable package-registry

systemctl start package-registry

удаляем за собой

rm -R "/root/package-registry/"

добавляем в конфиг кибаны наше зеркало

echo xpack.fleet.registryUrl: http://127.0.0.1:8080 >> /etc/kibana/kibana.yml

systemctl restart kibana

собираем упаковщик

cd ~

go install github.com/elastic/elastic-package@latest

cp "/root/go/bin/elastic-package" /usr/bin/elastic-package

убираем за собой

rm -R "/root/go/"

нам потребуется в будущем одна команда

elastic-package build

также возможно напрямую установить пакет в кибана но поскольку мы собрали свое зеркало то будем просто копировать пакеты в local

elastic-package install

собираем пакет интеграции, я заметил что readme на оф. сайте отличается от github но можно ориентироваться по версии и названию пакета

cd ~

git clone https://github.com/elastic/integrations

cd /root/integrations/packages/fortinet_fortigate/

elastic-package build

собранный пакет появляется в /root/integrations/build/packages/

cp "/root/integrations/build/packages/fortinet_fortigate-1.23.0.zip" /opt/local-storage/fortinet_fortigate-1.23.0.zip

systemctl restart package-registry

проверяем

для того чтобы навсегда решить проблему пишем скрипт который будет скачивать репозиторий собирать все пакеты и обновлять локальное хранилище

создадим скрипт и сделаем его исполняемым, кроп будет его запускать раз в месяц

nano /etc/cron.monthly/update_epr.sh

#!/bin/bash

cd /tmp/

git clone https://github.com/elastic/integrations

for i in `find /tmp/integrations/packages/ -maxdepth 1 -type d`

do

cd $i

elastic-package build

done

cp /tmp/integrations/build/packages/*.zip /opt/local-storage/

systemctl restart package-registry

rm -R /tmp/integrations/

chmod u+x /etc/cron.monthly/update_epr.sh

Спасибо за информацию. Нужно будет разбираться с этим вопросом.

Спасибо большое за справку по решению проблемы с репозиторием пакетов!

Добавлю после пункта по сборке и появлению пакета в папке в формате zip, чтобы его установить в kibana, которая установлена по статье, необходимо сделать следующие настройки:

# export ELASTIC_PACKAGE_KIBANA_HOST="http://192.168.1.1:5601" реальный

# export ELASTIC_PACKAGE_ELASTICSEARCH_USERNAME="elastic"

# export ELASTIC_PACKAGE_ELASTICSEARCH_PASSWORD=""

# export ELASTIC_PACKAGE_CA_CERT="" если нет https

Далее установки пакетов выполняются командой # elastic-package install --zip .zip -v

Если делать по справке, то после перемещения собранного пакета в zip и перезагрузки службы package-registry ничего не происходит и пакет не появляется в установленных интеграциях.

Спасибо за инструкцию, все понятно подробно хоть и приходилось совмещать с другими инструкциями что бы добиться работоспособности всего этого.

Единственный из ключевых моментов, будет скорее всего что пункт по настройки "Установка Filebeat для отправки логов в Logstash" стал не потянет от слова совсем. Тут конечно две причины либо я туплю, либо очень много изменилось с написание вашей инструкций. Один из пунктов "Нажимайте Create data view." это я нашел хоть он и не предлагал, а что то встроенное подтянул но при добавление выдает ошибку Типа "Данный не найдены, введите корректные данные" вот до этого момента все шло более менее гладко.

Владимир, добрый день!

Такой вопрос: у MaxMind есть также база с ASN. Можно её как-то прикрутить в выгружаемым к Кибану данным?

Спасибо.

Наверное можно, но я этим не занимался.

Просто добавил:

geoip {

database => "/usr/share/GeoIP/GeoLite2-ASN.mmdb"

default_database_type => "ASN"

source => "remote_ip"

target => "geoip"

add_tag => [ "nginx-geoip-asn" ]

}

Что-то я протупил. Думал по умолчанию какая-то другая база используется. Эта база ставится вместе с logstash и им же используется. Я в статье об этом рассказываю. Забыл просто, что эта база как раз от MaxMind.

Спасибо ещё раз! Все работает и уже очень помогает!

Не помешало бы расширить твой репо с эластиком для debian 10

спасибо, всех благ

А зачем? Уже 12-я версия вышла. К тому же в пакетах elastic нет привязки к версии. Можно скачать deb пакеты и установить в любую версию Debian.

Базу можно не качать, Logstash сам скачает базу, если будет использована в конфиге. Elastic тоже сам качает ежедневно базу, загрузку можно в настройках отключить - качает со своей шары в гугле

geoip {

source => "[source][ip]"

default_database_type => 'ASN'

}

Забыл дополнить. База обновляется исправно ежедневно, проверка базы происходит в тоже время (часы минуты), в которое был ранее запущен Logstash - вся информация есть в логах

Спасибо за информацию. Раньше такого не было. Я по привычке с 6-й версии плюс-минус одинаково настраиваю.

Еще нашел интересную информацию по индексам в Elastic

У меня ELK работает на одной ноде, кластер не собирал

За почти год собрались разные индексы и у них был желтый статус

Для некоторых индексов настраивал время жизни - Hot > Cold > Delete

Но они останавливались на фазе Cold, откладывал все момент поиска информации пока не накопятся разные данные

По итогу выяснил, что если ELK работает на одной ноде, то следует выставлять параметр number_of_replicas = 0

Из за того, что по умолчанию стоит 1 - индекс не может нормально собраться, появляются не распределенные шарды (shards) и статус индекса горит желтым

Нашел статью, как раз описывающую этот момент и пошаговую инструкцию как это исправить

https://community.ibm.com/community/user/ibmz-and-linuxone/blogs/james-porell1/2023/09/22/elasticsearch-index-lifecycle-management-policy-an

После отключения реплики, статус индексов перешел в зеленый и все фазы самостоятельно завершились.

Заметил, что данные с объемных индексов стали быстрее выгружаться

Добрый день!

Большое спасибо за мануал, всё заработало вроде, но: в эластик отправляется раз в несколько минут только первая запись лога (сам лог на данный момент примерно 28Мб), и всё на этом. Что может быть?

Лог, файлбит и логстэш находятся на удалённой машине от эластика и кибаны, вроде все друг друга видят.

Вроде нашёл. Был включен модуль апача в файлбит, из-за него вылетал, т.к. он не был сконфигурирован. Всем спасибо! :)

Что не не совсем понятно почему не срабатывает добавление при Create Data Vew:

Index pattern

Name must match one or more data streams, indices, or index aliases.

"

Если у вас нет доступа к репозиторию, то можете воспользоваться моим. Я создал копию репозитория elastic для Debian 11. Под все остальные системы можно через браузер скачать нужный пакет и установить вручную.

"

Ого! Прям отдельный респект за такое!!!

К сожалению, я не слежу за актуальностью этого репозитория, чтобы не было расхождений в версиях репозитория и статьёй. Это довольно хлопотное занятие. Так что сейчас там те версии, что точно заработают по этой статье. А дальше обновляться вам нужно уже своими силами, если нужна последняя версия.

Вот, кстати, и идея для новой статьи. Опишите как вы это сделали, думаю многим это будет интересно.

Я писал об этом в telegram канале:

https://t.me/srv_admin/2277

Интересен ваш опыт по сборку алертов. Предположим, что хочется иметь выгрузку алертов в красивом виде, с возможностью искать по ним через UI. Если выгружать в Elastic - есть на `github` утилиты типа alertmanager2gelf, alertmanager2es. Но они давно не поддерживаются и не до конца ясно, какую альтернативу себе нашли люди. Поделитесь, пожалуйста, опытом.

Ещё раз: задача - поиск по алертам, как в ES по логам.

лювлю на чистой установке ошибку в web кибаны.

Version: 8.7.1

Build: 61224

Error: Definition of plugin "banners" not found and may have failed to load.

at http://192.168.1.131:5601/61224/bundles/core/core.entry.js:1:342508

at plugin_PluginWrapper.createPluginInstance (http://192.168.1.131:5601/61224/bundles/core/core.entry.js:1:342752)

at plugin_PluginWrapper.setup (http://192.168.1.131:5601/61224/bundles/core/core.entry.js:1:341952)

at plugins_service_PluginsService.setup (http://192.168.1.131:5601/61224/bundles/core/core.entry.js:1:344987)

at core_system_CoreSystem.setup (http://192.168.1.131:5601/61224/bundles/core/core.entry.js:1:350676)

at async Module.Gi (http://192.168.1.131:5601/61224/bundles/core/core.entry.js:1:356895)

AlmaLinux release 9.2, установка через пакетный менеджер. версии кибаны и es одинаковые. В конфиге указано минимум, как и в статье.

Кто-нибудь сталкивался? Решение нагуглить не смог.

По ошибке not found and may have failed to load можно предположить, что установщик пытается что-то загрузить, но из-за блокировки с адресов РФ это не получается.

Я из Казахстана. Доступ к репозиториям имеется. Пробовал удалять все и ставить версии, что указаны в статье. Скачал rpm пакеты с официального сайта. Установил всё как в статье, поменял конфиг и первый же вход в веб морду кибаны - ошибка.

ладно, буду смотреть. Найду проблему отпишусь.

Веб морда стала нормально запускаться после удаления директории со всем содержимым /usr/share/kibana/x-pack/plugins/banners

Объясните нюанс.

Зачем делать в filebeate использовать:

fields:

type: nginx_access

fields_under_root: true

если можно делить верхним type: log

То есть я могу записать в filebeate так :

filebeat.inputs:

- type: nginx_access

enabled: true

paths:

- /var/log/nginx/*-access.log

scan_frequency: 5s

- type: nginx_error

enabled: true

paths:

- /var/log/nginx/*-error.log

Вроде чем меньше строк, тем проще читать. Или в Вашем варианте есть какой-то нюанс, который я не улавливаю

Ужасно кастомный гайд. Не теряйте время, не работает. Зачем пилить костыли когда есть https://www.elastic.co/guide/en/beats/filebeat/current/filebeat-module-nginx.html ?

Я же не заставляю читать. Изучи продукт, напиши статью и обновляй её регулярно вместе с обновлением продукта, которое происходит каждые пол года. Пришли ссылку, я поучусь у тебя и своим подписчикам расскажу про классную статью.

Если у тебя что-то не получается, это не значит, что статья плохая. Я получал десятки отзывов о том, как всё получилось. А в статистике сайта я вижу обратные ссылки на эту статью из внутренней документации очень многих компаний, в том числе крупных.

Раза три пробовал поставить по данному ману, не рабочий вариант для debian 11, не хочите kibana дружить с elastic

Kibana cannot connect to the Elastic Package Registry, which provides Elastic Agent integrations

Ensure the proxy server(opens in a new tab or window) or your own registry(opens in a new tab or window) is configured correctly, or try again later.

За репозиторий спасибо.

Что за высер? Новичек никогда не разберется по твоей ссылке.

Zerox отличные статьи выпускает и помогает сотням - тысячам людей.

Все описал, привел конфиг и все испортил выпиливанием в стек nginx. Зачем ? Неужели нельзя вся поднять и описать из коробки ? Кто захочет разобраться, тот сам допилит так как ему удобно будет. Кнопки Create data view больше нет в разделе дискавер. Что дальше то ? Для новичков просто не статья а потерянное время. Зачем так делать ? Посмотрите сколько комментариев а как это а как то. Очень жаль что потратил время.

Ах вот оно что вот тут и у меня стопор тоже. Что данная кнопка не появляется.

Nginx тут вообще не при чём.

Добрый день

Замечательная статья! Как и многие статьи на этом сайте. Позволяет легко и быстро вкатиться в технологию. Спасибо Автору за труд!

По самой статье есть вопрос, который пока не удалось однозначно разрешить: Есть ли механизм бесплатно прикрутить LDAP авторизацию к реализованному стеку?

Сама установка по статье прошла без проблем. Отдельное спасибо за репу) Прокси Nginx также без проблем прикрутился, но появилась потребность назначать метрики по пользователям и ролям. Пользователей около 100, вручную администрировать это не хотелось бы.

Наткнулся на https://docs.readonlyrest.com/kibana Но так и не понял как это скрутить вместе. Похоже что для Кибана плагин всё равно платный(

Поэтому вопрос: есть ли рабочий способ прикрутить LDAP авторизацию в бесплатной версии стека ELK ?

Возможно есть способ прикрутить LDAP через Keycloack в бесплатной версии?

И если такого пути нет, то хотелось бы услышать Ваше мнение по стеку OpenSearch? (на сколько я понял это по сути форк ELK, так ли это?)

Также в качестве хотелки, конечно, хотелось бы увидеть статью от Автора по OpenSearch тоже :)

Заранее большое спасибо за ответы! )

И извините за глупые вопросы новичка)

С OpenSearch у меня были мысли разобраться, но по факту, он уже довольно сильно отличается от ELK. И настройка там посложнее и дольше. С учётом того, что я хорошо знаю ELK, не вижу смысла распыляться и тратить время на оба продукта. Насчёт LDAP не подскажу, не прорабатывал этот вопрос.

Спасибо за ответ)

Буду разбираться. Но похоже открытого бесплатного способа прикрутить LDAP или SSO к ELK нет (

Здравствуйте. Спасибо за подробную статью.

Уже после установки Elastic стека при обращении к странице Меню -> Management -> Fleet сталкиваюсь с проблемой - возникает ошибка следующего содержания:

Unable to initialize Fleet

[Default policy] could not be added. [system] could not be installed due to error: [RegistryResponseError: '403 Forbidden' error response from package registry at https://epr.elastic.co/search?..

Как понимаю, это снова недоступность репозиториев, откуда подгружается Fleet, из-за ограничений ip из России. Каким способом всё же можно успешно запустить Fleet? Пожалуйста, подскажите

Да, проблема с доступом к репозиторию. Как решить в данном случае, даже не знаю. Надо на сервере VPN настраивать в обход блокировок. Путь прописан явно где-то в веб интерфейсе и так просто подложить скачанный пакет или изменить адрес не получится. Хотя можно попробовать в исходники Kibana зайти и подменить url. Не знаю, насколько это реализуемо.

Было бы не плохо добавить в инструкцию пункт с добавлением портов

Можно так, например:

sudo iptables -A INPUT -p tcp --dport 9200 -j ACCEPT

sudo iptables -A INPUT -p tcp --dport 9300 -j ACCEPT

sudo iptables -A INPUT -p tcp --dport 5601 -j ACCEPT

sudo iptables-save

В конфигах для репозиториев ошибка, name должен с новой строки начинаться, иначе не установится

Спасибо большое за статью, особенно за раздел с безопасной передачей. Ставил по умолчанию ELK, он сразу включил https. Делал по вашей инструкции, нашёл несоответствие.

В файле .conf индекс создаётся в виде index => "websrv-%{+YYYY.MM}"

А в настройке привилегий для роли указываете nginx-*, и логстеш не может создать индекс, прежде чем туда что-то писать.

Либо маску "websrv-*" указывать, либо (проще) "*".

Скорее всего ошибка закралась во время очередного редактирования. Эта статья переписывалась уже раз 5. ELK постоянно обновляется. Приходится то частями, то полностью переписывать статью.

Я посоветовал (настоятельно) автору такого уважаемого сайта-портала рекламу курса OTUS про DevOps убрать от греха подальше. Я был на этом курсе и ушёл от туда почти сразу. Курс сам по себе старый и не проработанный, очень много воды. Постоянно накладки с лекциями. Домашние задания не проработаны и мучительны, в них много ошибок, на устранение которых люди тратят много часов (просто на ошибки в ДЗ, которые ОТУС не исправляет скоро уже как с год). Поддержка преподавателей никакая совсем. Если вы вдруг решили позаниматься на длинных выходных, то ответят вам в лучшем случае через 3-4 дня. Причём ответы на "отвали".

Сам курс не уникальный и идёт тупая нудная начитка лекций. Материал куда полезнее и интереснее (и уже более актуальный) есть бесплатно на ютубе. Оно много лучше и красивее подан. У преподавателей даже нет нормальных микрофонов и иногда проблема с техникой на занятиях.

В общем, это даже самое малое, что я могу написать. Курс - обман и просто высасывание бабла. Ничему не научит, бесполезная трата времени и денег.

ОТУС ещё и обманщики чистой воды. Уверяют, что можно будет вернуть ВСЕ деньги, если курс не понравится. Много подводных камней. ВСЕ деньги мне не вернули, а лишь часть. Да, сам не прочитал что-то мелкими буквами, но лить в уши неправду, чтобы просто заманить на курс - это очень низко.

Этот курс есть на торрентах, можно посмотреть и оценить. Я получал негативные отзывы абсолютно на все курсы, что так или иначе рекламировались, но не все они плохие, так как некоторые я проходил лично. Идеальных нет, где не было бы плохих отзывов. Otus на общем фоне, по моему мнению, делает нормальные курсы. Многие лекторы - публичные люди, которых можно посмотреть или послушать на ютубе или каких-то других публичных записях. Конкретно этот курс я не смотрел.

автору спасибо за работу,

статья старая и кибана уже поменялась а именно начиная отсюда

Если все сделали правильно, то данные уже потекли в elasticsearch. Мы их можем посмотреть в Kibana. Для этого открываем web интерфейс и переходим в раздел Discover. Так как там еще нет представления для нового индекса, нам предложат его добавить. Нажимайте Create data view.

Добрый день.

Споткнулся на этапе настройки Kibana.

Отредактировал конфиг по гайду (IP адрес подставил свой)

В итоге в логе Кибаны получаю ошибку:

This version of Kibana (v8.6.1) is incompatible with the following Elasticsearch nodes in your cluster: v8.5.2 @ 10.3.204.16:9200 (10.3.204.16), v8.5.2 @ 10.3.204.14:9200 (10.3.204.14)","log":{"level":"ERROR","logger":"elasticsearch-service"},"process":{"pid":10019},"trace":{"id":"66c2afff2f75fd758506ba439778afea"},"transaction":{"id":"9329a5b487b613f5"}}

Соответственно на веб интерфейсе получаю сообщение Kibana server is not ready yet.

Вопрос: Что то упустил и не донастроил или в репозитории лежит не та версия кибаны?

Проверьте, какие версии у вас установлены на сервере. По логам видно, что Elastic v8.5.2, а Kibana v8.6.1. У меня в репозитории есть обе эти версии. У вас по какой-то причине установлены разные. Они не совместимы между собой.

Добрый день! Настроил по Вашему мануалу. Отправляю логи с winlogbeat, конфиг:

winlogbeat.event_logs:

- name: Application

ignore_older: 72h

- name: Security

- name: System

tags: ["winsrv"]

output.logstash:

hosts: ["ip:5044"]

logging.level: info

logging.to_files: true

logging.files:

path: C:/ProgramData/Elastic/Beats/winlogbeat

name: winlogbeat.log

keepfiles: 7

Проверкак подключения tnc ip -p 5044 проходит ок.

Конфиг logstash output:

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "winsrv-%{+YYYY.MM}"

}

}

Данных в Index patterns нету. Что может быть?

Может быть всё, что угодно. Так трудно судить. Надо внимательно смотреть логи на обоих сторонах, проверять всю последовательность настройки. Где-то что-то упущено.

ELK 8.5.3

[ERROR][elasticsearch-service] Unable to retrieve version information from Elasticsearch nodes. unsupported certificate purpose

При настройке эластик-кибана

Чаще всего такие проблемы возникают при неправильной настройки ca.crt, из-за которого не может быть проверен сертификат при подключении. Может прав у кибаны нет к этому файлу с сертификатом, ошибка в пути или ещё что-то.

Добрый день, подскажите, пожалуйста, может сталкивался кто. Настроил ELK, чтоб через реверс прокси Nginx кибана грузилась по адресу http://mysite.com/analytics/ . На сайте настроен сертификат от Let's Encrypt. При попытке зайти на HTTPS версию получаю белую страницу.

Через просмотр кода виден код страницы elastic, но все ресурсы в 404, поэтому ничего не грузится. Пытаюсь настроить через конфиг кибаны, копирую сертификаты Let's Encrypt от домена в папку кибаны, выставляю права и разрешения, потом добавляю в конфиг:

server.ssl.enabled: true

server.ssl.certificate: /etc/kibana/certs/fullchain.pem

server.ssl.key: /etc/kibana/certs/privkey.pem

И стабильно получаю ошибку 502 Gateway. Если кто настроил, пните, пожалуйста в нужную сторону.

Вы проксируете запросы на алиас /analytics. Они в таком же виде с /analytics в url приходят ни Kibana, но сама Kibana настроена на работу без этого алиаса. В общем, если не разбираетесь в этом, то посадите Kibana на отдельный поддомен, а не /analytics/ или разберитесь с этим перенаправлением. Ошибка в нём, а не сертификате.

Привет добрый человек. Спасибо, все работает.... Вот только не могу понять... как мне добавить мониторинг iis??? Как работает интеграция через api

Я никогда не настраивал анализ логов IIS. Он вроде бы пишет логи в системный лог Windows. А для сбора логов Windows есть готовый сборщик Winlogbeat. Надо его установить и настроить.

Установил Winlogbeat и настроил.... показывает все кроме IIS )). Видел, что можно мониторить iis более подробно. А не пробовали Вы делать интеграцию через fleet ?

Я не пробовал. Так сами логи iis где находятся?

В папке по умолчанию

Для IIS есть отдельный модуль, который входит в состав Filebeat. В документации показано, как настроить:

https://www.elastic.co/guide/en/beats/filebeat/current/filebeat-module-iis.html

Спасибо за наводку. Решил проблему с ошибкой 509. Вот только осталась одна проблема. вот такая ошибка:

{"log.level":"error","@timestamp":"2023-03-08T12:19:50.986-0800","log.origin":{"file.name":"cfgfile/reload.go","file.line":258},"message":"Error loading configuration files: 1 error: Unable to hash given config: missing field accessing '0.vpcflow' (source:'C:\\Program Files\\Filebeat\\modules.d\\gcp.yml.disabled')","service.name":"filebeat","ecs.version":"1.6.0"}

{"log.level":"info","@timestamp":"2023-03-08T12:19:50.987-0800","log.logger":"load","log.origin":{"file.name":"cfgfile/list.go","file.line":139},"message":"Stopping 68 runners ...","service.name":"filebeat","ecs.version":"1.6.0"}

Loaded Ingest pipelines

Вопрос решен. В кибане в настройках elasticsearch внес отпечаток сертификата и все заработало. Теперь агенты работают через fleet сервер. Теперь все подробно показывает. Всем спасибо

Подскажите,

Failed to fetch https://artifacts.elastic.co/packages/8.x/apt/dists/stable/InRelease 403 Forbidden [IP: 34.120.127.130 443]